Parmi les nombreuses annonces effectuées par Google lors de la keynote d'ouverture de la Google I/O, il y en a une qui est passée plutôt inaperçue : Gemma 3n. Pourtant, ce nouveau mini modèle a de grandes implications.

Ce fut une soirée riche en annonces majoritairement centrées, sans surprise, sur l'intelligence artificielle (IA). Gemini, le produit phare de Google, va ainsi développer de nouvelles capacités comme la compréhension du contexte personnel, tandis que Google Search va se doter d'un nouveau mode IA censé révolutionner l'expérience utilisateur. Ce fut aussi l'occasion pour le géant de Mountain View de lever le voile sur de nouveaux modèles, à l'instar Gemma 3n.

Un SLM multimodal

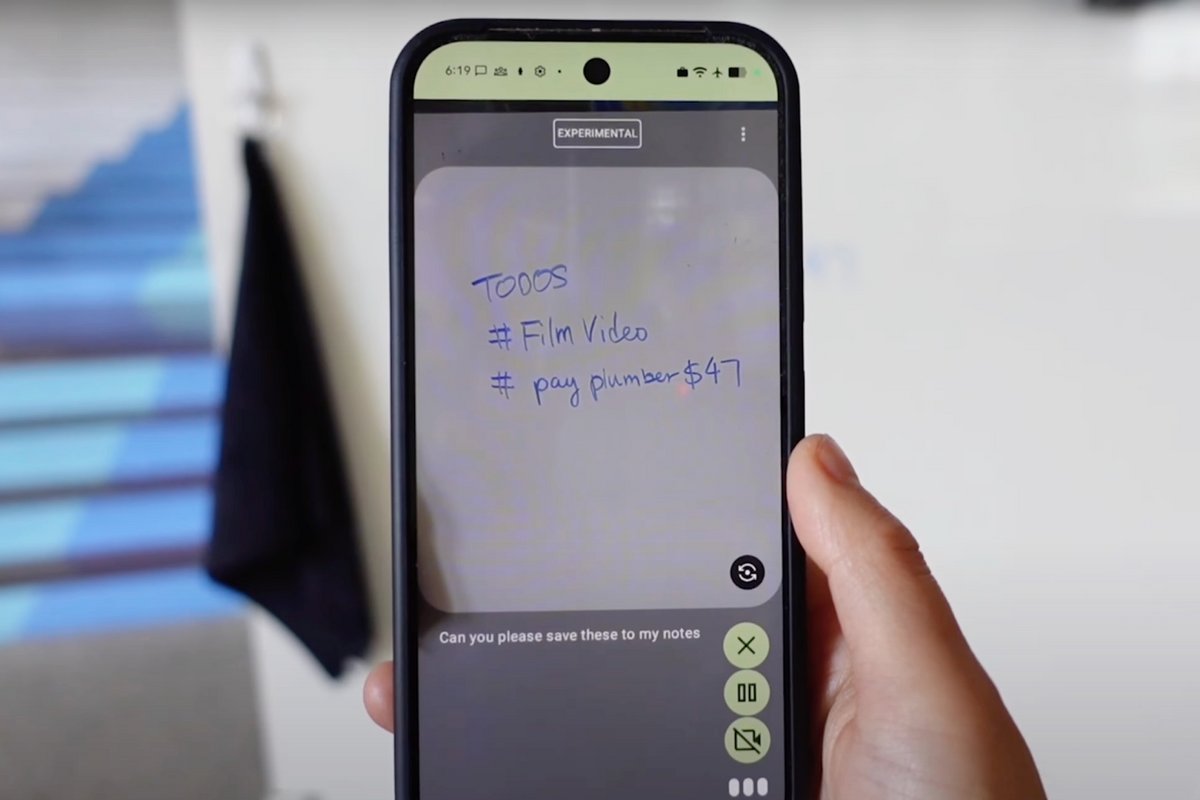

Il s'agit d'une nouvelle variante de Gemma, un Small Language Model (SLM), présenté par Google l'année dernière. La grande nouveauté, sa multimodalité : contrairement à ses prédécesseurs qui ne comprenaient que le texte, Gemma 3n peut analyser simultanément du texte, des images, de l'audio et même de la vidéo.

Fruit du travail de la division Google DeepMind, il incorpore la technologie de compression intelligente Per-Layer Embeddings (PLE), réduisant la mémoire nécessaire pour son déploiement en local. Le nombre de paramètres bruts pour Gemma 3n est de 5 milliards et 8 millards de paramètres, mais ses besoins en mémoire sont comparables à ceux de modèles de 2 milliards et 4 milliards de paramètres. Google affirme que sa nouvelle technologie fonctionne avec une empreinte mémoire allant de 2 Go à 3 Go seulement.

En outre, Gemma 3n est en capacité de répondre 1,5 fois plus rapidement que Gemma 3, en plus de pouvoir créer dynamiquement des sous-modèles qui répondent de manière plus optimale à des cas d'utilisation spécifiques.

Des modèles capables de tourner en local

Mais alors, pourquoi confectionner des modèles plus petits ? La réponse est simple : les grands modèles de langage (LLM) comme GPT-4 ou Claude Sonnet, sont incroyablement énergivores, et doivent donc passer par des centres de données massifs pour fonctionner correctement.

À l'inverse, les SLM sont en mesure de marcher sur un appareil en local, et les avantages sont nombreux. En plus de garantir le respect de la vie privée, les données ne quittant pas l'appareil, ces modèles n'ont pas besoin d'une connexion Internet. De quoi ouvrir la voie à des produits électroniques incorporant des IA directement en local, un domaine qui commence à prendre de l'élan avec, par exemple, certains aptitudes d'Apple Intelligence.

Si ces modèles ne sont pas en mesure de réaliser des tâches ultra complexes, le champ des possibles reste très vaste, d'autant plus pour l'usage grand public. Et c'est pour cette raison que les géants de la tech développent aussi ce type de technologies. D'ailleurs, Microsoft travaillerait à intégrer son propre SLM, Phi-4, directement dans le navigateur Edge.