Depuis les premières images la semaine dernière, le télescope James Webb continue de transmettre ses photographies. Pourtant, sur ce grand appareil de plus de 6 tonnes, les données transitent sur un disque dur de… 68 Go.

À peine de quoi contenir plus d'une journée de relevés. Mais tout est calculé, et en réalité, c'est déjà beaucoup !

Mémoire insuffisante, voulez-vous supprimer des photos ?

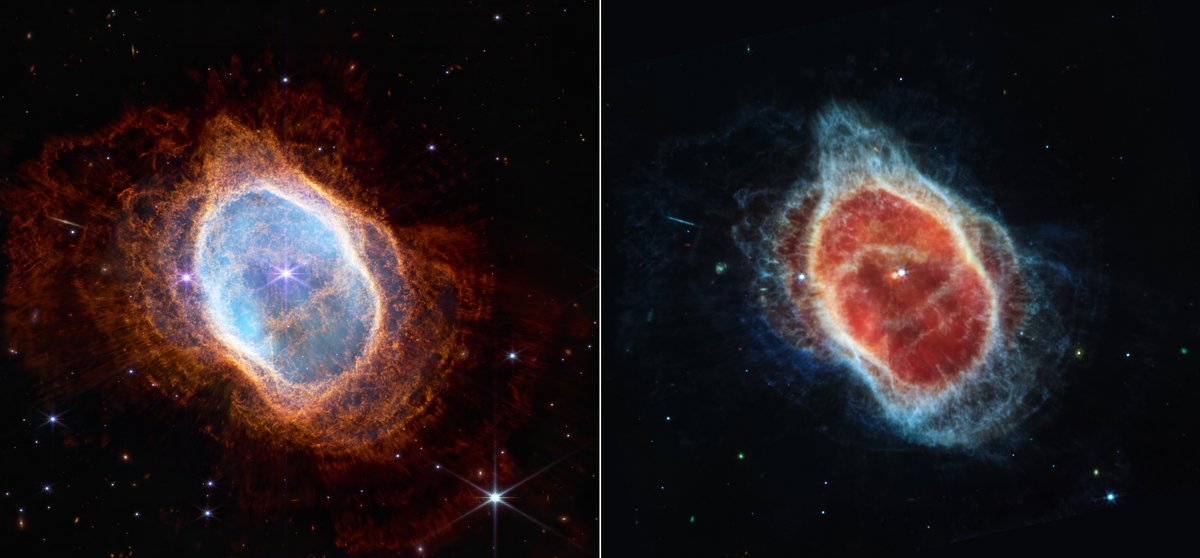

Si tout se passe bien, c'est sur ce disque dur que vont transiter les photographies qui vont peut-être révolutionner l'astrophysique. « Chaque image est une nouvelle découverte, et chacune offre à l'humanité une perspective inédite sur notre Univers », rappelait l'administrateur de la NASA Bill Nelson le 13 juillet dernier, à l'occasion de la présentation des premières images scientifiques.

Depuis, la source ne tarit pas, et les équipes scientifiques préparent déjà d'autres publications fascinantes. Mais tout cela est permis grâce à une mémoire de seulement… 68 Go. Ce qui peut sembler ridicule, car nos PC, tablettes, et même de nombreux smartphones ont des capacités qui excèdent largement le stockage du JWST !

Des transferts en continu

Le télescope James Webb peut produire et stocker jusqu'à 58,8 Go de données chaque jour, un progrès absolument énorme par rapport aux 2 Go de données de capacité Hubble, ou au disque dur de la même taille du rover Curiosity.

Dans les modes d'acquisition les plus rapides, le JWST peut même remplir son disque dur en 120 minutes seulement… Ce qui force ensuite les équipes à télécharger rapidement ces données pour ne pas saturer la mémoire du télescope.

Mais pas de panique : le James Webb envoie ses paquets de relevés en bande Ka depuis le point de Lagrange L2 (à 1,5 million de kilomètres de la Terre) en deux périodes de 4 heures de transmission chaque jour. Et l'avantage de sa position réside aussi dans la constance de pointage nécessaire pour échanger des données avec lui. Ses observations, prévues très à l'avance, ne passent que quelques heures en mémoire avant d'être téléchargées !

Assez pour rêver sans s'inquiéter

Pas d'inquiétude donc, tout est prévu pour que ce stockage, blindé et amplement suffisant, puisse survivre à 20 années d'exploitation à longue distance. Et si vous vous demandez pourquoi il n'y a pas plus de marge, il faut se souvenir que 68 Go, c'est encore énorme pour un véhicule spatial aujourd'hui, et ce, alors que le télescope James Webb a été conçu il y a près de 20 ans.

Les images sont donc bien à l'abri, et passeront beaucoup plus de temps sur les serveurs de la NASA et du Space Telescope Science Institute, qui les réceptionnent, les distribuent aux scientifiques concernés et les traitent pour leur présentation au public. De quoi se régaler !

Source : Tom's Hardware