Cultivant sa différence face aux traditionnels radars et caméras, le LiDAR est une technologie de plus en plus sollicitée. La toute jeune start-up française Outsight est l’une des plus actives sur le sujet. Faisons le tour de la question…

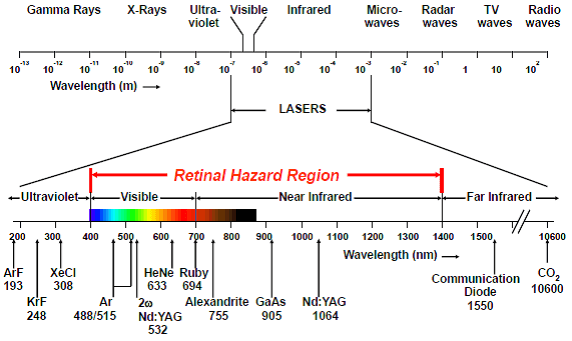

Le LiDAR, ou Light Detection And Ranging, fait partie de la grande famille des capteurs. Cette technologie permet de mesurer la distance entre un capteur et sa cible (un objet ou une personne) à l’aide de la lumière qu’elle émet, un laser. Si la technologie LiDAR n’est pas encore grandement répandue, elle tend à se développer dans divers secteurs et marchés, notamment celui du véhicule autonome ou, plus récemment, de la téléphonie mobile avec une incursion dans les derniers iPhone 12 Pro et iPhone 12 Pro Max.

La start-up française Outsight, elle, exploite avec intérêt plusieurs de ses autres propriétés, parmi lesquelles la robotique, le calcul de volume ou le suivi en temps réel des flux de personnes et de marchandises, notamment à l’aéroport Paris-Charles de Gaulle. C’est précisément ce dernier cas pratique que nous avons évoqué avec Raul Bravo, co-fondateur et président d’Outsight. Mais avant toute chose, tentons de préciser les caractéristiques du LiDAR, et de les distinguer de celles de technologies adjacentes aux atouts et inconvénients différents : la caméra et le radar.

Radar, caméras et LiDAR : de rares points communs, de nombreuses différences

Commençons par comparer le LiDAR, la caméra et le radar, au regard de leurs qualités et de leurs défauts respectifs - sans dénigrer aucune de ces technologies. On débute avec la plus célèbre d’entre elles : la caméra.

La caméra

Une caméra, au sens technique du terme, permet de capter la lumière extérieure et de l’enregistrer dans de petites cellules, appelées des pixels. Comme nous l’explique Raul Bravo, « il s’agit d’un dispositif passif, parce que s'il n'y a pas de lumière, il n'y a pas l'information, il n’y a pas de donnée ». C'est donc pour cela que la nuit, à la base, une caméra ne voit rien.

Par définition, la caméra souffre donc d’un désavantage majeur, puisque son bon fonctionnement dépend des conditions de luminosité. « Et les changements d’intensité importants sont difficiles à gérer pour elle », explique l’entrepreneur. « Avant de pénétrer dans un tunnel, vous avez un plein soleil, vous rentrez, puis vous sortez. Même l'humain peut avoir, à ce moment-là, quelques secondes d'adaptation à la nouvelle situation ». Le phénomène expliqué est le même pour une caméra.

Un autre désavantage de la caméra classique est que si elle capte l'image, elle n'a pas une notion de distance, au contraire du LiDAR dont nous allons reparler plus bas. Ses propriétés restent limitées, puisqu’elle a été conçue pour des humains. « Les caméras essaient de représenter de la façon la plus fidèle possible ce que nous voyons avec nos yeux. L'objectif est véritablement que l'humain comprenne ce qu'il voit. Quand on parle de robot ou de voiture autonome, ce n'est plus le cas », nous dit Raul Bravo.

La caméra présente toutefois un avantage important face au radar et au LiDAR : la résolution. « On peut avoir de formidables résolutions, on peut capter des pixels très petits, c’est une vraie différence », témoigne le patron d’Outsight.

Le radar

Avec le radar, nous entrons dans le domaine des ondes radio.

Au contraire de la caméra, le radar est un dispositif actif, un point qu'il partage avec le LiDAR. Le radar génère en effet son propre signal, composé non pas de lumière, mais d'ondes radio. À la différence de la caméra, qui n’aime pas l’obscurité, le radar peut alors fonctionner la nuit.

La différence avec le LiDAR, c'est que le pixel enregistré par le radar est très gros, de l'ordre de quelques mètres. Il en résulte l'impossibilité de distinguer, par exemple, deux personnes placées côte à côte.

« C'est pour cela qu'on l'utilise sur les routes », explique Raul Bravo. « Les voitures sont suffisamment séparées, donc la marge d'erreur diminue. Mais même dans ces applications-là, on commence à avoir des demandes pour le LiDAR, plus précis que le radar ».

Le radar a été la source de plusieurs accidents ces dernières années, notamment avec les véhicules Tesla. Une voiture de la marque embarquant un radar avait notamment traversé un camion blanc, que le radar avait confondu avec un pont. La caméra, elle, avait assimilé le blanc du camion au blanc du ciel. « Le LiDAR, lui, l'aurait perçu », précise Raul. À ce jour, Tesla reste fermement opposée au LiDAR, préférant encore le couple radar-caméra. Pour son fondateur Elon Musk, « le LiDAR est la course d’un imbécile, et quiconque compte sur le LiDAR est condamné ». Une position radicale, qui tiendrait en réalité à des considérations économiques, le LiDAR demeurant une technologie coûteuse pour un véhicule autonome (10 000 dollars par véhicule selon les arguments avancés par les constructeurs).

Le LiDAR : une technologie complémentaire, entre opportunités et précision

Comme le radar, le LiDAR est un système actif, c'est-à-dire qui génère sa propre lumière au lieu d'attendre ou d'utiliser une lumière existante. Envoyée en ligne droite, la lumière voyage en ligne droite, puis rebondit sur un objet avant de revenir. « Et grâce au temps de vol (soit le temps entre l'aller et le retour), on sait connait la distance, parce que la vitesse de la lumière est connue », explique Raul Bravo.

Au contraire de la caméra, on peut alors connaître la distance qui sépare le capteur d’un objet, ou d’une personne. Mais le LiDAR n’est pas utile que pour déterminer des distances. Par extension, il permet aussi de connaître la taille et le volume des objets de façon très précise, ce qui peut se révéler extrêmement utile pour le transport de marchandises.

En termes de résolution, le LiDAR est soumis au fait que chacun de ses pixels est un laser. « Une lumière laser signifie que nous avons une lumière focalisée », explique le co-fondateur d’Outsight. « C'est un point qui ne se déforme pas et permet une grande précision. Il est plus compliqué de multiplier les lasers dans un espace très petit, et c'est pour cela que pour l'instant, le LiDAR a une résolution beaucoup, beaucoup plus faible que la caméra ».

La comparaison entre un smartphone et le LiDAR est criante. « Un mobile peut avoir 8 millions de pixels par image par exemple, alors que dans une image, le LiDAR en aura environ 30 000, au grand maximum », détaille Raul Bravo. Le LiDAR de l'iPhone est notamment utilisé pour des fonctionnalités basiques, comme celle qui consiste à mapper une pièce à proximité immédiate.

Les domaines que le LiDAR touche ou touchera demain

Le LiDAR utilise un faisceau laser pour la détection, l’analyse et le suivi. Il possède ainsi des propriétés multiples qui peuvent servir différentes applications.

Son apparition n’est pas récente, puisque la technologie fut notamment utilisée durant la mission Apollo 15, en 1971, pour cartographier la surface de la Lune. Plus récemment, le LiDAR a fait partie des outils ayant permis de réinventer l’archéologie. Avec la télédétection par laser, il est en effet possible de mesurer et cartographier des objets, lieux et autres vestiges comme jamais auparavant. On relève ainsi deux grandes catégories d’utilisation du LiDAR.

¤ Applications nouvelles, impossibles sans LiDAR : ici, on touche à l'autonomie, avec la robotique, l'automatisation, etc. Outsight travaille notamment sur le port de Dubaï pour automatiser le transport des conteneurs. « Tout ça reste "le futur", avec des marchés émergents : la robotique, bien au-delà de la voiture », analyse Raul Bravo.

¤ Applications pour lesquelles le LiDAR remplace ou complète les caméras : ces dernières sont en effet peu à peu limitées par leurs capacités. L'avantage, c'est que ces applications sont déjà existantes. « Ce sont des marchés traditionnels qui vont être bousculés, améliorés », précise Raul Bravo. Dans cette catégorie, il y a le large marché de la surveillance-sécurité au sein duquel le LiDAR est promis à un bel avenir, notamment pour analyser les flux des personnes, des biens et des véhicules.

Cas d’application du LiDAR : une solution utilisée à l’aéroport Paris-Charles de Gaulle pour gérer le flux de voyageurs

L’entreprise Outsight a justement été sélectionnée par le groupe ADP pour mener des tests et installer de façon pérenne la technologie LiDAR sur l’aéroport Paris-Charles de Gaulle. L'objectif ? Fournir un suivi précis des flux de personnes en temps réel, tout en préservant la sécurité et la confidentialité des données privées. Voilà un premier exemple de l’application possible de cette technologie par la jeune start-up, que nous détaille Raul Bravo.

Chez ADP, la technologie fournie par Outsight permet de mesurer avec précision le nombre de personnes en salles de livraison de bagages, mais aussi leurs déplacements et leurs interactions, outre, tendance du moment, le respect de la distanciation sociale. « On traque les mouvements des personnes, on comprend comment elles se déplacent, ce qu'elles font, comment elles utilisent les ressources de l'aéroport, comme les tapis ou les chariots. Tout cela est fait pour que l'aéroport comprenne au mieux le comportement des gens, mais sans savoir qui ils sont », explique Raul Bravo.

« Sans savoir qui ils sont », nous dit-il. Ce détail est d’importance, puisque le suivi des personnes ou des marchandises n’est effectué qu’à l’aide de formes géométriques et de couleurs. La résolution du LiDAR est en effet bien trop faible, comme nous l’expliquions, pour pouvoir identifier une personne, encore moins des visages. L'avantage, c'est que ce processus garanti une vraie anonymisation des sujets.

Au-delà de ça, il est reste tout à fait possible d'analyser individuellement le déplacement de chaque personne, ce qui se révèle pratique dans bien des endroits de l’aéroport. Grâce aux dizaines de capteurs installés dans le terminal 2F de l’aéroport (qui accueillent les compagnies Air France, Air Europa et Alitalia pour des vols domestiques ou au sein de l’espace Schengen), on peut suivre, simultanément et en temps réel, plusieurs dizaines de milliers de personnes.

Que se passe-t-il ensuite pour l’aéroport ? « Les services d’ADP disposent d’un tableau de bord via lequel ils peuvent comprendre le comportement des passagers, que ce soit en temps réel ou à l’aide de graphiques et statistiques ».

Si certaines fonctionnalités sont encore en test, la plupart sont aujourd’hui installées de façon pérenne, en « mode production », confirme Raul Bravo, qui voit l’aéroport comme un formidable laboratoire pour le LiDAR, comme pourrait l’être un centre commercial, une gare, un parc d’attractions, une salle de spectacle, ou tout autre lieu pouvant accueillir un public de masse.

Une autre application de la technologie porte sur la mesure du volume des déchets, dans un centre de recyclage par exemple. « Les mètres cubes sont difficiles à mesurer à la base », rappelle Raul, qui nous informe que grâce au LiDAR, « on obtient la mesure exacte ». L’avantage : c’est que l’on peut ainsi définir la quantité exacte de déchets à insérer dans un camion, et ainsi davantage rentabiliser chaque trajet. Avec le LiDAR donc, la perte d’espace pourrait n'être qu'un lointain souvenir.

Le coût du LiDAR : mettons fin aux idées reçues

Il existe une idée reçue selon laquelle le LiDAR est cher. « C'est juste faux », s’étonne Raul Bravo. Notons tout de même que le LiDAR reste onéreux pour une application dans le secteur automobile, comme le soutient Elon Musk. Un radar ne coûte en effet que quelques dizaines d'euros par véhicule, quand le prix d'un LiDAR, atteint plusieurs milliers d’euros. Forcément, pour un usage individuel, la technologie n’est pas rentable. Du moins pas encore.

Or, la mesure de la distance est un domaine tellement important que des entreprises sont prêtes à utiliser des capteurs chers, à faible résolution, qui présentent l’avantage de ne pas être dépendants des conditions climatiques ou de lumière. On retrouve aussi ces attentes pour des marchés comme la sécurité-surveillance par exemple, là où le LiDAR est moins cher. Pourquoi ? « S’agissant de la question du traitement du passage aux frontières et de la vérification du passeport, on va se demander combien de LiDAR il faut pour une surface donnée. Il s'avère qu'avec 1 LiDAR, on peut remplacer 10 caméras. Si le LiDAR est 10 fois plus cher, il reste au même prix que les caméras, du point de vue du client », soutient le patron d’Outsight. Un argument qui peut faire mouche économiquement, et qui a visiblement su convaincre ADP.

« Il y a une idée reçue selon laquelle le LiDAR est cher, mais ce n'est plus le cas dans de nombreuses applications. Ce qui freine le LiDAR aujourd'hui, c'est la disponibilité des logiciels pour l'utiliser », explique Raul Bravo. La technologie n’est en tout cas promise qu’à progresser, et nul doute que son adoption progressive entraînera, à terme, une diminution des coûts.

Présentation d'Outsight

Fondée en 2019, Outsight a démarré ses opérations mi-2020. Une période ô combien compliquée, puisque la France affrontait le plus fort de la crise de coronavirus.

La start-up française développe des systèmes de transport intelligents (ITS ou intelligent transportation systems en anglais), qui consistent à rendre les routes et les villes plus « intelligentes » et réactives face au trafic de personnes ou au trafic de véhicules. Elle travaille aussi sur les carrefours et les feux tricolores dits intelligents. L’un de ses autres champs se situe dans la sphère industrielle, avec la mesure du volume ; mais on la retrouve aussi dans la robotique, où Outsight propose des solutions d'automatisation, notamment sur le port de Dubaï.

Les équipes de la société sont réparties entre trois bureaux : Paris, San Francisco et Helsinki (où la société travaille sur le futur et sur des technologies de rupture, plutôt liées à la technologie de base du LiDAR, le laser). Outsight compte 39 collaborateurs, mais une quarantaine de personnes devraient rejoindre très rapidement l’entreprise, qui va donc doubler de taille.