La start-up japonaise Sakana AI lève le voile sur les Continuous Time Machines (CTM), une architecture d'intelligence artificielle qui s'inspire du fonctionnement temporel continu de nos neurones. Cette approche pourrait bien redéfinir la manière dont les machines pensent et prennent des décisions en temps réel.

L'univers de l'intelligence artificielle est actuellement dominé par des modèles, tels que les grands modèles de langage (LLM), qui fonctionnent de manière séquentielle, traitant l'information par étapes discrètes. Si cette méthode a prouvé son efficacité pour de nombreuses tâches, elle présente des limites en termes de réactivité et d'efficacité énergétique. Sakana AI, une jeune pousse japonaise chapeautée par un ancien de Google propose une alternative avec ses CTM, cherchant à doter les machines d'une forme de pensée plus fluide et adaptative, plus proche de la nôtre.

CTM : une architecture calquée sur le cerveau

L'idée fondamentale derrière les CTM est de s'éloigner du traitement par lots (batch processing) qui caractérise de nombreux modèles d'IA actuels. Au lieu de traiter les données par blocs isolés, les CTM visent à intégrer l'information de manière continue, à l'instar des processus cognitifs humains où la pensée n'est pas découpée en segments distincts mais s'écoule et évolue.

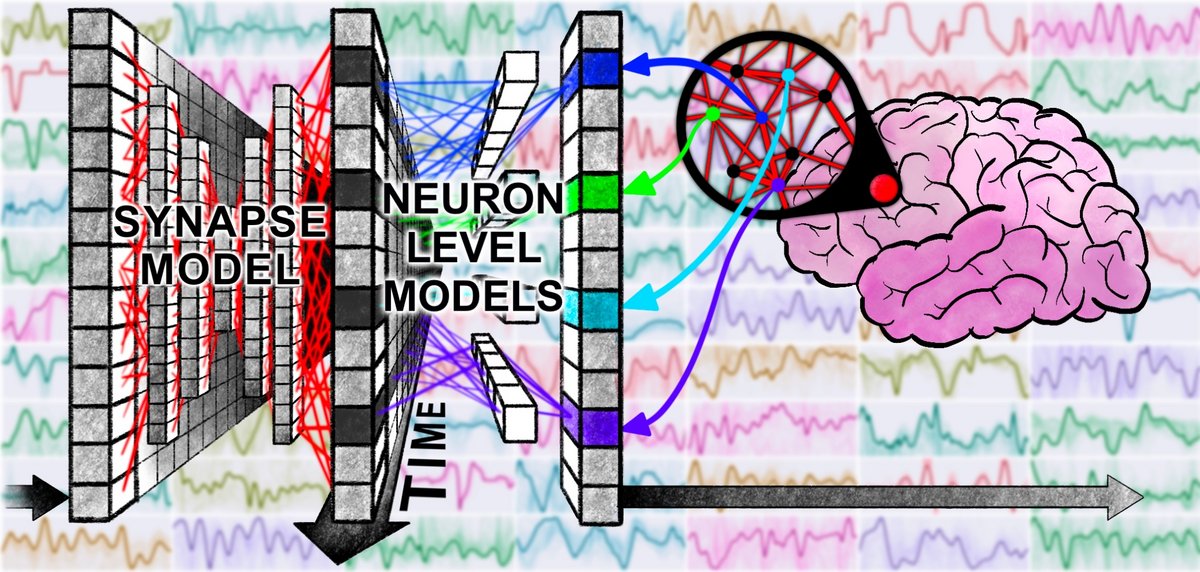

Sakana AI puise son inspiration dans la neurobiologie, et plus particulièrement dans le concept des réseaux de neurones à impulsions (spiking neural networks). Contrairement aux neurones artificiels classiques qui produisent une sortie continue, les neurones à impulsions communiquent par des signaux discrets, des « pics » ou spikes, dont la temporalité est cruciale. L'information n'est pas seulement codée dans l'activation ou non d'un neurone, mais aussi dans le moment précis où ces impulsions se produisent. Cette dynamique temporelle est au cœur de l'approche CTM, cherchant à reproduire cette richesse du codage neuronal.

Le cerveau humain ne traite pas l'information en attendant que toutes les données d'une séquence soient disponibles, comme le font souvent les Transformers avec leur mécanisme d'attention qui examine l'ensemble des tokens d'une phrase simultanément. Au contraire, il intègre les informations au fur et à mesure qu'elles arrivent, adaptant continuellement sa compréhension et ses réponses. C'est cette capacité à « penser en continu » que Sakana AI souhaite instiller dans ses modèles, leur permettant potentiellement de délibérer et d'ajuster leur « pensée » sur des périodes variables, comme un humain qui réfléchit plus ou moins longtemps à un problème.

Les architectures de type Transformer, bien que performantes, traitent les séquences en étapes discrètes et calculent des relations entre tous les éléments d'une séquence, ce qui peut être coûteux en ressources, surtout pour les longues séquences. Les CTM, en revanche, proposent une alternative où le réseau neuronal lui-même peut évoluer dynamiquement dans le temps. Les connexions entre neurones, ou leurs poids, ne seraient pas fixes mais pourraient se modifier en continu, permettant au modèle d'adapter sa structure interne et son traitement en fonction du flux d'informations et du temps disponible pour la « réflexion ».

L'efficacité énergétique et la réactivité en ligne de mire

Les travaux de Sakana AI sur les CTM en sont encore à un stade exploratoire, mais les concepts présentés ouvrent des pistes prometteuses. L'entreprise met en avant l'utilisation de réseaux neuronaux dynamiques, capables de maintenir et de faire évoluer des états internes sur la durée.

Un aspect central des CTM réside dans leur capacité à maintenir des états internes qui persistent et se transforment au fil du temps. Cela permettrait au modèle de construire une compréhension contextuelle qui n'est pas réinitialisée à chaque nouvelle entrée discrète, mais qui évolue de manière organique. Imaginez une conversation : notre compréhension se raffine mot après mot, phrase après phrase, grâce à notre mémoire et à notre capacité à lier les nouvelles informations au contexte déjà établi. Les CTM ambitionnent un fonctionnement similaire, où le « passé » influence continuellement le traitement du « présent ».

Cette persistance des états internes et la modulation temporelle du traitement pourraient conférer aux CTM une flexibilité accrue. Par exemple, face à une tâche complexe, un CTM pourrait allouer plus de « temps de calcul interne », simulant une délibération plus poussée, avant de fournir une réponse. Cette notion de « budget temporel » pour la pensée est une caractéristique intéressante, absente de la plupart des modèles actuels qui ont un temps de traitement plus ou moins fixe par étape.

Les bénéfices potentiels de cette approche sont multiples. Une meilleure gestion des flux de données continus et dynamiques, comme ceux rencontrés en robotique, dans les systèmes autonomes ou l'analyse de signaux en temps réel, pourrait être atteinte. La capacité à moduler le temps de « réflexion » pourrait aussi mener à des systèmes plus adaptatifs, capables de fournir des réponses rapides pour des problèmes simples et des analyses plus approfondies pour des questions complexes. Sur le plan de l'efficacité énergétique, l'inspiration des réseaux de neurones à impulsions, connus pour leur frugalité, pourrait également ouvrir la voie à des IA moins gourmandes en ressources.

Les applications envisagées couvrent un large spectre, allant de l'amélioration des agents conversationnels à la création de robots capables de naviguer et d'interagir de manière plus naturelle et adaptative dans des environnements changeants. La gestion de tâches nécessitant une conscience contextuelle étendue et une prise de décision évolutive pourrait particulièrement bénéficier de cette architecture.

Source : Sakana