Des documents émanant d'Intel en fuite sur les réseaux sociaux chinois nous informent sur ce que pourrait être la feuille de route du groupe fin 2020. Les informations dévoilées par ces documents méritent néanmoins d'être prises avec des pincettes.

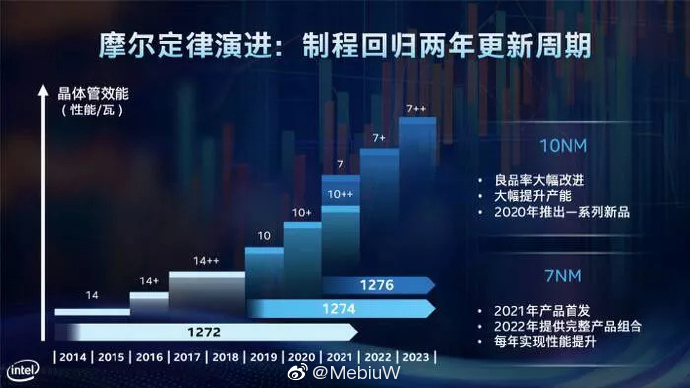

Revenir à la loi de Moore et exploiter une nouvelle finesse de gravure tous les deux ans. C'était le but affiché l'année dernière par Intel lors d'un meeting dédié à ses investisseurs, en mai. Si l'on en croit un plan de route en fuite sur la plateforme chinoise Weibo, Intel s'en tiendrait à ses déclarations. La firme prévoirait ainsi de commencer à exploiter un protocole de gravure en 7 nm courant 2021 et en 2022, tandis que la seconde moitié de l'année 2020 serait sous le signe du 10 nm avec les lancements successifs de cinq produits gravés en 10 nm.

Alder Lake, la génération de puces de bureau hybride en 10 nm prévue cette année

Cette possibilité rejoint en tout cas de précédentes déclarations de Bob Swan, le PDG d'Intel. En l'état, la firme miserait sur les lancements de processeurs basse consommation Tiger Lake (pour PC portables), de puces pour serveurs Xeon Scalable sous architecture Ice Lake, de SoCs Snow Ridge (pensés pour les relais 5G et déjà lancés en partie sur le premier trimestre 2020), de ses premières cartes graphiques dédiées DG1 et enfin de processeurs de bureau Alder Lake, eux aussi gravés en 10 nm.Pour rappel, ces processeurs de bureau Alder Lake seront vraisemblablement conçus selon une architecture BIG.little, à la manière des puces Lakefield annoncées l'année dernière par les Bleus. En clair, cette nouvelle génération de processeurs serait équipée d'une part de huit cœurs haute performance, de type Willow Cove ou Golden Cove ; et d'autre part de huit cœurs Tremont ou Gracemont, moins performants et pensés avant tout pour l'économie d'énergie.

Une fin d'année à deux vitesses pour Intel ?

Reste que la fin d'année pourrait être chargée pour Intel sur le secteur du processeur pour ordinateur de bureau. Selon les rumeurs, la firme préparerait également le lancement, sur cette période, de CPUs Rocket Lake. Toujours gravés en 14 nm, ces derniers prendraient le relais des processeurs Comet Lake-S attendus dans les prochaines semaines et apporteraient notamment le support du PCI-Express 4.0... tout en intégrant des iGPU Xe Graphics, à la manière des SoCs Tiger Lake.Nous irions alors vers une offre à deux vitesses, avec la cohabitation de puces de bureau 14 nm et 10 nm... un peu comme ce que l'on trouve actuellement sur laptop avec les gammes Comet Lake-U (14 nm) et Ice Lake-U (10 nm).

Sauf clarification et/ou changement de plan entre temps, les lancements d'Intel pour les prochains mois pourraient donc perdre un peu plus encore le consommateur, et ce tandis qu'AMD, au contraire, réussit depuis deux ans à clarifier son offre avec des gammes relativement bien définies d'un point de vue technologique.

Source : Tom's Hardware