Les pronoms sont désormais retirés des suggestions intelligentes de Gmail. Google veut éviter de confondre le genre de la personne à qui l'utilisateur répond.

Les algorithmes sont encore perfectibles face à la définition du genre

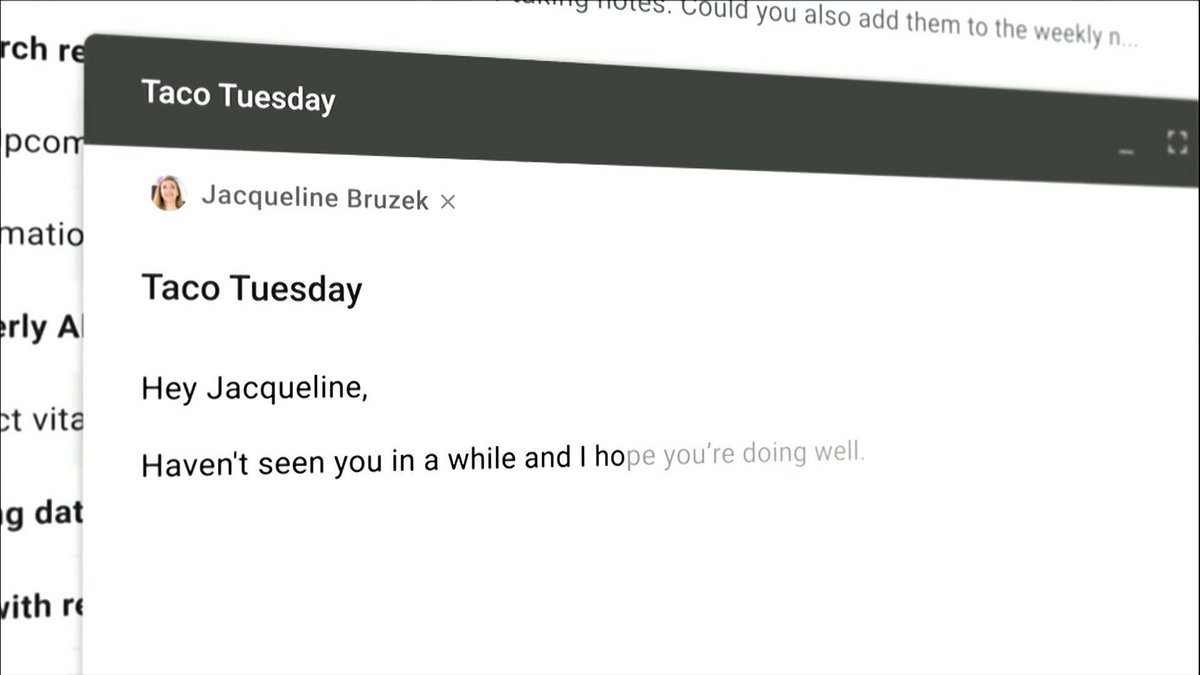

Google fait un nouveau pas dans la lutte contre la discrimination liée au genre. Le moteur de recherche va retirer les pronoms genrés de son outil de suggestion automatique intégré dans Gmail. Les propositions seront neutres pour éviter toute erreur sur le genre supposé de la personne à qui l'utilisateur composer un e-mail.L'entreprise a essayé de trouver des solutions en se basant sur ses techniques d'apprentissage automatique, avant d'arriver à la conclusion qu'aucun dispositif ne pouvait prédire le genre d'un individu. Google a préféré jouer la sécurité, en raison de ses efforts de représentation des personnes LGBTQ et abandonner les algorithmes pour ce cas précis.

Source : Reuters