Portée par des promesses de sécurité renforcée, la reconnaissance faciale automatique se déploie progressivement outre-Manche. Mais où sont les garde-fous quand l'IA hallucine ?

Au Royaume-Uni, des algorithmes d'intelligence artificielle inventent tout simplement des criminels en alimentant une base de données faisant office de liste noire. Pourtant, après vérification, plusieurs dizaines de personnes cataloguées s'avèrent innocentes.

Quand l'IA s'empare de la sécurité….

La BBC rapporte l'histoire de Danielle Horan, une femme expulsée à deux reprises des magasins de l'enseigne Home Bargains dans la ville de Manchester. Dans l'un d'entre eux, elle a été accusée à tort de vol par à un système de reconnaissance faciale. Elle a donc été placée sur une liste noire qui ne semble pas être passée en revue par des agents de sécurité humains.

En souhaitant se rendre dans un autre magasin de l'enseigne, elle s'est toute simplement faite refouler à l'entrée. « Dès que j’ai franchi le seuil de la porte, ils se sont mis à communiquer par radio entre eux, ils m’ont tous entourée et m’ont dit : “Vous devez quitter le magasin” », a-t-elle déclaré.

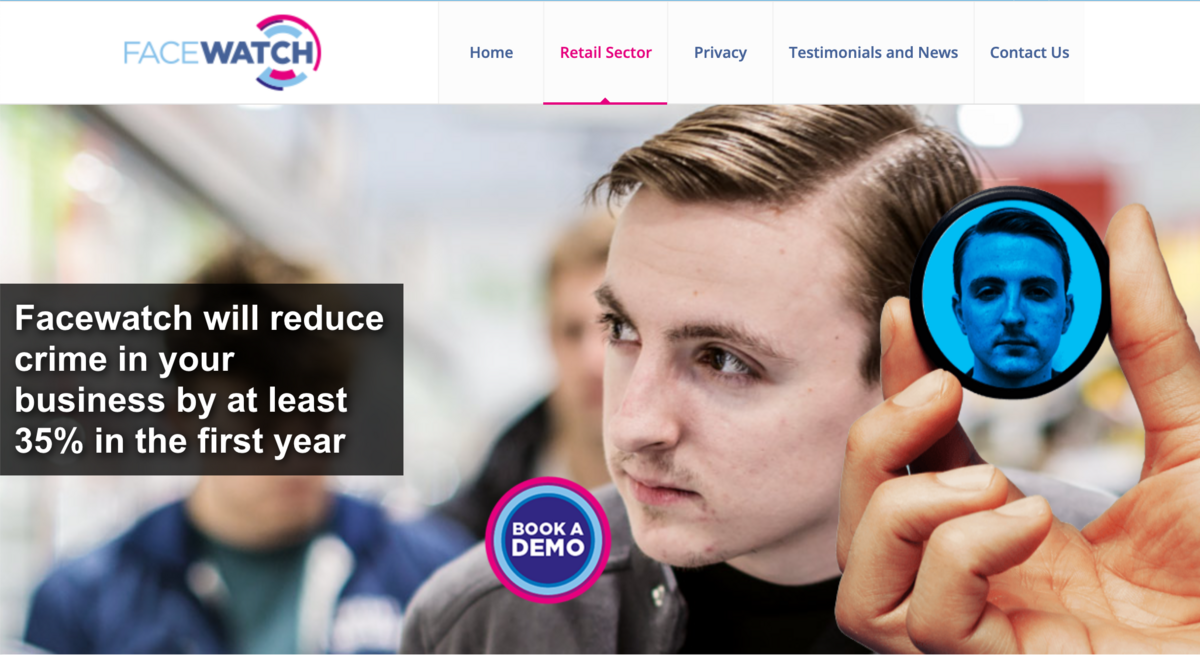

Le logiciel utilisé a été fourni par l'entreprise Facewatch. L'algorithme avait inscrit cette britannique au sein d'une base de données en indiquant que cette dernière avait volé... du papier toilette.

…pas de présomption d'innocence

Au-delà d'une erreur d'algorithme, c'est surtout la manière dont ce logiciel est utilisé qui laisse perplexe. Malgré la vérification de ses paiements, l’erreur a persisté plusieurs jours, obligeant la victime à justifier sa bonne foi, non seulement auprès du personnel de l'enseigne, mais également auprès du fournisseur de l'algorithme de reconnaissance faciale. D'emblée, l'IA efface alors toute présomption d'innocence.

Or, selon Madeleine Stone, responsable principale du plaidoyer au sein du groupe de défense des libertés civiles Big Brother Watch, ce ne serait pas le premier cas du genre. L'organisme aurait déjà été contacté par plus de 35 personnes ayant vécu des situation similaires

Facewatch a reconnu l’erreur et suspendu temporairement l’accès à ses services dans les magasins impliqués, tout en rappelant que la fiabilité du système dépend des informations initiales.

Ce n'est pas la première fois que la reconnaissance faciale fait débat suite à des erreurs d'identification, notamment lorsque celle-ci est utilisée par des forces de l'ordre. Déjà en 2020, des activistes avaient décidé d’utiliser la technologie pour identifier à leur tour les policiers qui, eux, restent anonymes lorsqu'ils procèdent à des arrestations lors de manifestations.