Le géant américain sort du bois avec Nighthawk et Loon, deux processeurs quantiques aux tempéraments opposés. L'un vise l'efficacité immédiate, l'autre prépare l'avenir. Un pari double pour rattraper son retard dans une compétition où chaque qubit compte.

IBM a choisi sa conférence annuelle pour sortir l'artillerie lourde. Deux nouvelles puces quantiques, deux philosophies distinctes, mais un seul objectif : prouver que le calcul quantique peut enfin servir à quelque chose de concret. Le rendez-vous est pris pour fin 2026, date à laquelle le groupe espère atteindre ce fameux avantage quantique qui fait saliver toute l'industrie. En attendant, ces annonces témoignent d'une stratégie bien ficelée pour ne plus se laisser distancer par la concurrence.

Nighthawk, le sprinter qui vise juste

La première puce, baptisée Nighthawk, joue la carte du pragmatisme. Avec ses 120 qubits et 218 coupleurs accordables, elle promet d'exécuter des circuits 30% plus complexes que son prédécesseur Heron. Concrètement, ce processeur peut gérer jusqu'à 5 000 portes à deux qubits, ces opérations d'enchevêtrement qui donnent aux ordinateurs quantiques leur superpuissance.

IBM ne se contente pas de promesses vagues : la feuille de route prévoit 7 500 portes en 2026, puis 10 000 en 2027. L'année 2028 devrait même voir des systèmes multi-puces grimper à 15 000 portes grâce à des coupleurs longue portée. Cette approche progressive, presque timide, détonne avec les annonces fracassantes habituelles du secteur. Mais elle a le mérite d'être mesurable et vérifiable.

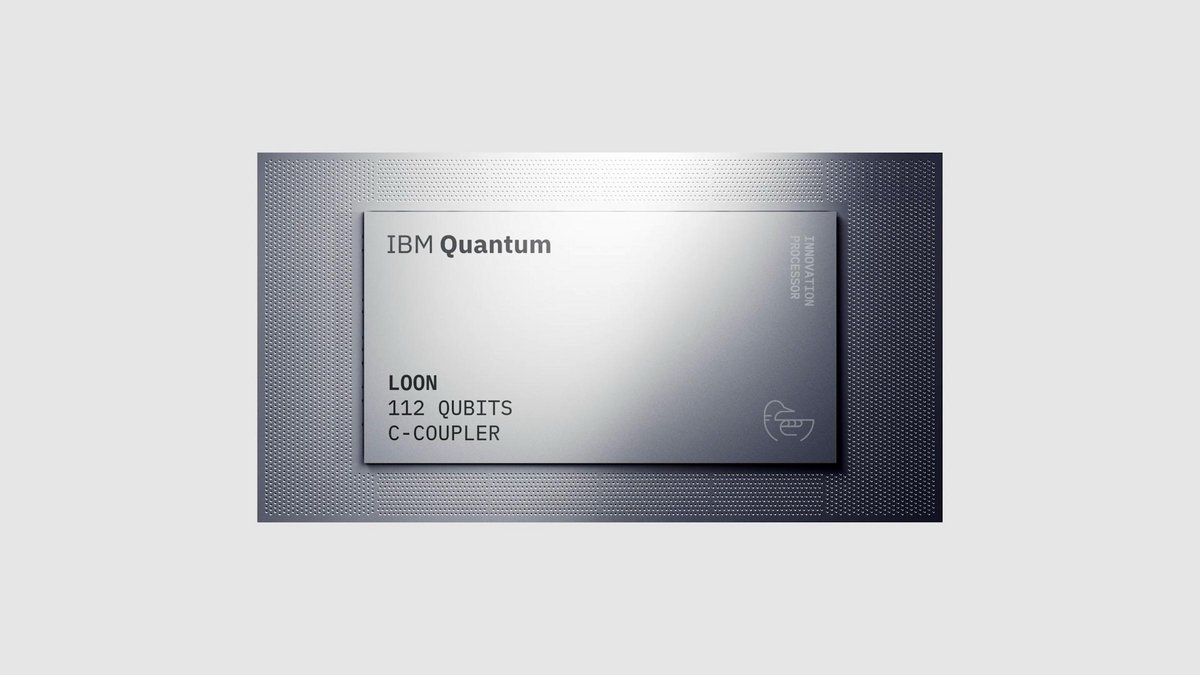

Loon, l'architecte du futur lointain

Si Nighthawk vise l'efficacité à court terme, Loon explore un horizon plus ambitieux : la correction d'erreurs quantiques à grande échelle. Cette puce expérimentale rassemble pour la première fois tous les ingrédients nécessaires à une correction d'erreurs tolérante aux défauts. Autrement dit, elle teste les fondations d'un système capable de détecter et réparer ses propres erreurs en temps réel.

L'architecture de Loon intègre des coupleurs longue portée pour relier des qubits éloignés, des dispositifs de réinitialisation individuels, et surtout une implémentation pratique des codes LDPC. Ces derniers encodent l'information de manière redondante, permettant d'identifier et corriger les erreurs à la volée. IBM a même validé une correction d'erreurs en 480 nanosecondes avec du matériel classique, dépassant ses propres prévisions d'une année entière.

Pour supporter ces architectures ambitieuses, IBM a transféré sa production au centre NanoTech d'Albany. Résultat : les délais de fabrication divisés par deux et la complexité des designs multipliée par dix. Un changement d'échelle qui permet de tester plusieurs variantes en parallèle et d'accélérer les itérations.

Une course où personne ne lâche rien

IBM ne joue pas seul dans cette partie de poker menteur technologique. Fujitsu annonçait en avril un système de 256 qubits avec des plans pour 1 000 qubits en 2026. Google peaufine ses capacités en correction d'erreurs, Microsoft explore les qubits topologiques. Chacun sa recette, chacun son pari.

Cette diversité d'approches reflète une vérité simple : personne ne sait encore quelle voie mènera au Graal. L'avantage quantique véritable ne se résume pas à battre un ordinateur classique sur un problème abstrait. Il faudra démontrer une utilité concrète pour des applications réelles. Un seuil que l'industrie espère franchir d'ici 2026, promis juré.

Avec Nighthawk et Loon, IBM joue sur deux tableaux : l'optimisation du présent et la validation du futur. Pas si mal pour un acteur qu'on disait distancé.

Source : Engadget