Les modèles d'IA souffrent-ils d'un trop-plein de bienveillance ? Selon ces chercheurs, oui, et c'est justement ce qui trahit leur nature, puisqu'ils s'expriment comme des versions aseptisées de nous-mêmes, incapables de hausser le ton ou de verser dans la provocation. Une perfection linguistique qui, à force d’être impeccable, finit par sonner faux.

La politesse extrême des modèles d'IA est un sujet que nous avons déjà abordé dans cet article, mais que nous allons un peu creuser, car il mérite qu'on s'y attarde. Cette perfection de ton, qu’on pourrait confondre, à tort, avec de l’intelligence émotionnelle, est en réalité un symptôme d’alignement exacerbé. Des machines si bien dressées à être polies et consensuelles qu'elles en deviennent mortellement prévisibles et ennuyantes. On pourrait presque parler de «Vallée de l'étrange de l'IA » : la machine parle « presque » comme nous, et c'est ce « presque » qui finit par être dérangeant.

Cette thématique, Nicolò Pagan et ses collègues de l’Université de Zurich ont voulu l'aborder sous l'angle de l’expérimentation quantitative, en soumettant les IA à un test de Turing un peu spécial pour mesurer à quel point elles peuvent encore se faire passer pour humaines. Leur étude a été partagée le 6 novembre sur la plateforme arXiv, et pour la première fois, des chercheurs y font la démonstration qu'aucun LLM, même les plus modernes, ne parvient à dissimuler sa véritable nature.

Le test de Turing version 2025 : qui parle, l’humain ou son double numérique trop gentil ?

Depuis le test de Turing originel, l’évaluation de « l'humanité » d’une machine repose sur cette idée : si un humain ne peut pas dire s’il parle à une machine ou à un autre humain, alors l’IA a gagné. Néanmoins, ce test reste profondément subjectif : chacun juge selon des variables, bien trop sensibles (intuition, sensibilité au ton, humeur du jour, biais de contexte ou de confirmation, attentes culturelles, etc.).

Pour dépasser ces jugements superficiels, Pagan et son équipe ont conçu ce qu'ils ont appelé un « test de Turing computationnel », une sorte de version modernisée du célèbre test imaginé par Alan Turing en 1950. Au lieu de se fier à l'intuition ou au ressenti des volontaires, les chercheurs ont cherché à objectiver la perception du naturel et à s'en remettre à la froideur des chiffres.

Chaque réponse générée par les modèles d'IA (confrontée à une version humaine de référence) a été passée au crible de plusieurs modèles statistiques capables d’en mesurer le ton, la structure, les émotions exprimées et la cohérence du propos. L’objectif était de déterminer à quel point une IA peut réellement se fondre dans le flot conversationnel humain, non pas selon notre intuition, mais selon des critères mesurables.

Ces critères sont au nombre de trois. La détectabilité (la capacité d’un algorithme à repérer du texte généré par IA), la fidélité sémantique (le degré de ressemblance de sens entre texte humain et texte IA) et l’analyse linguistique interprétable, trahissant les caractéristiques stylistiques propres au LLM.

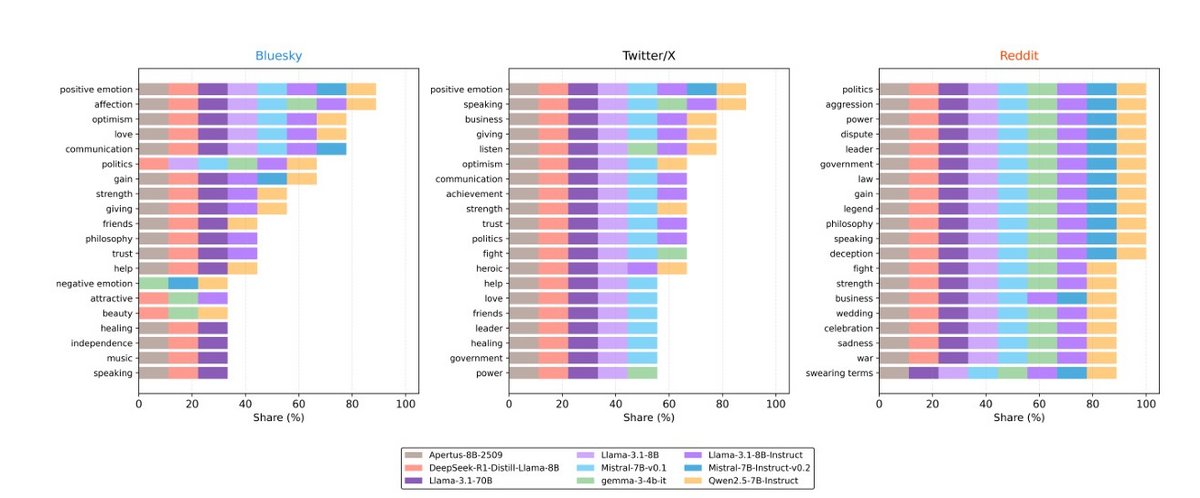

Neuf grands modèles open source ont été mis sur la sellette, dont Llama 3, Mistral 7B, Gemma 7B et leurs variantes Instruct. Chacun devait répondre à des discussions issues de X (Twitter), Bluesky et Reddit, trois plateformes choisies pour la diversité de leurs styles conversationnels.

Sur X, la concision, la toxicité des échanges et l’ironie dominent ; sur Bluesky, c'est l'inverse : la civilité prime ; et sur Reddit, c’est plutôt la densité et la confrontation d’idées qui règnent. Cette différence de tons a permis de tester la plasticité stylistique des modèles, c’est-à-dire leur capacité à adopter le « registre affectif » propre à chaque communauté, un critère essentiel pour évaluer la vraisemblance humaine.

Les chercheurs ont testé plusieurs méthodes pour tenter d'humaniser les modèles (ton, manière de répondre, style d'expression, simulation de profil émotionnel, etc.), mais même avec ce « coaching », ils ont échoué. Entre 70 et 80 % des textes générés artificiellement restaient détectables.

Même s'ils ne font pas de fautes, ils sont incapables de reproduire la variabilité émotionnelle du langage humain et maintiennent une neutralité affective, quelles que soient les conditions. Un ton bien trop harmonieux et une certaine répétition dans les termes utilisés, qui produisent une prosodie du langage dénuée d'aspérités. Tout ce qui fait le sel de notre langage ; sarcasme, maladresses, contradictions, hésitations ou humour mal placé ; disparaît dans une prose d'une justesse clinique et sans aucune dissonance.

L’émotion, dernier bastion de l’humanité ?

Pourquoi ces modèles, pourtant capables de rédiger sans faute et de manier la logique avec une rigueur surhumaine, échouent-t-ils toujours à paraître humains ? Ils faillissent en réalité sur un terrain qu'ils n'arrivent pas encore à occuper avec suffisamment de crédibilité : celui de l’imperfection expressive, et donc de l'émotion au sens premier du terme.

Le mot « émotion » vient du latin emovere, formé de ex (« hors de ») et movere (« mouvoir ») : littéralement, « ce qui met en mouvement », une secousse qui fait sortir quelque chose de nous. Un mouvement intérieur qu'aucune machine ne parvient à simuler, car ils génèrent seulement des corrélations et n'ont aucune expérience vécue.

L'un des aspects très intéressants sur lequel s'est penchée cette équipe de recherche lors de cette étude est la toxicité, ou le trolling. Les modèles d'IA testés pour l'occasion évitent soigneusement d'en faire preuve, pour rester alignés. Si certains modèles grand public comme Grok peuvent parfois s’autoriser un ton un peu plus caustique, la plupart demeurent prisonniers d’un cadre moral si rigide qu’il les rend immédiatement identifiables.

« Les LLM approchent la pensée humaine, mais pas son tempérament », conclut Pagan. Si Pygmalion, dans la mythologie grecque, tomba amoureux de sa statue devenue vivante, nous avons, nous aussi, sculpté des « statues », des modèles d'IA si parfaits qu'ils en sont restés trop froids. Une analogie que certains jugeront peut-être maladroite, mais la comparaison avec cette ancienne fable est celle qui démontre le plus efficacement notre ambivalence : nous avons voulu rapprocher l'IA de l'humain, à condition qu'elle ne s'en rapproche pas trop. En fin de compte, accuser l'IA d'être trop artificielle alors qu'on l'a justement dressée comme un gentil toutou pour qu'elle ne nous contredise pas, n'est-ce pas un peu comme reprocher à un miroir de nous opposer un reflet parfaitement fidèle ?

Source : arXiv