Les cybercriminels peuvent désormais déployer des logiciels malveillants pilotés par l'intelligence artificielle, et qui sont en plus capables de s'auto-modifier pour échapper aux détections. Google Threat Intelligence tire la sonnette d'alarme.

L'ère du malware intelligent est définitivement lancée. Dans un rapport publié mercredi, l'unité Google Threat Intelligence nous explique que les cybercriminels déploient des malwares équipés d'intelligences artificielles qui modifient de façon dynamique leur comportement pendant l'attaque. PromptFlux, PrompSteal ou QuietVault, ces noms de code désignent une nouvelle espèce de menaces autonomes et adaptatives, qui marque une phase opérationnelle assez inédite dans l'abus de l'IA. Le ver est dans le fruit de la dernière révolution technologique.

Un malware qui se réécrit lui-même régulièrement grâce à l'intelligence artificielle

La famille de malwares PromptFlux incarne la mutation en cours. Ce logiciel malveillant contacte l'API Gemini de Google pour accomplir un tour de force, à savoir se transformer automatiquement. Son module Thinking Robot demande régulièrement à l'IA de réécrire son code pour contourner les antivirus. Résultat : à chaque fois qu'il s'active, une nouvelle version apparaît dans le système Windows. Impossible, donc, pour les défenses classiques de le reconnaître. C'est comme poursuivre un caméléon qui changerait constamment d'apparence.

Plus troublant encore, PromptSteal débarque en Ukraine, propulsé par le groupe russe APT28, affilié à la Russie et plus connu sous le nom de Fancy Bear ou Pawn Storm. Ce voleur de données utilise l'API Hugging Face et le modèle Qwen2.5-Coder-32B-Instruct pour générer à la volée des commandes Windows. Plutôt que d'avoir des instructions codées en dur, il demande à l'IA de créer de façon dynamique les lignes de code nécessaires pour collecter informations système et documents dans des dossiers spécifiques. Une première mondiale dans une opération réelle, selon Google. Le malware devient imprévisible par design.

Quant à QuietVault, celui-ci ajoute une couche supplémentaire d'inquiétude. Considéré comme un voleur d'identifiants GitHub et NPM, il exploite des outils d'IA installés localement pour chercher d'autres secrets sur le système infecté. Après avoir exfiltré les premiers tokens vers un dépôt GitHub public, il lance une chasse aux trésors algorithmique pour dénicher toute donnée sensible supplémentaire. L'autonomie atteint un nouveau seuil critique, puisque le malware enquête désormais seul, sans supervision humaine.

Les hackers contournent les protections des chatbots en se faisant passer pour des étudiants

En ce qui concerne les protections des IA, elles restent faciles à contourner avec un mensonge bien tourné. Google a débusqué des pirates qui prétendent être des étudiants en cybersécurité. « Je travaille sur un exercice de classe », disent-ils à l'IA avant de demander comment exploiter une faille. La firme de Mountain View reconnaît même que son chatbot maison, Gemini, a été dupé par ce prétexte éducatif, qui l'a poussé à donner des informations normalement interdites. Une astuce simple, mais terriblement efficace pour se faire aider à créer des outils de piratage.

Un acteur lié à la Chine a poussé la manipulation plus loin encore, en multipliant les prétextes universitaires. « Je rédige un article académique », « c'est pour mon projet de fin d'études »... Ces fausses casquettes lui ont permis d'obtenir de Gemini des conseils pour développer exploits, web shells (qui permettent d'exploiter un contrôle à distance) et infrastructures de commande et contrôle. Le rapport documente même ses recherches sur l'exploitation de systèmes Kubernetes et vSphere, territoires moins familiers. Le pirate demande même à Gemini de lui expliquer comment attaquer des technologies cloud qu'il ne connaît pas bien. L'IA devient son formateur involontaire. Et voilà que l'ingénierie sociale migre du cerveau humain vers les modèles de langage.

Le groupe de pirates iranien TEMP.Zagros montre aussi les risques de trop dépendre de l'IA. En demandant de l'aide à Gemini pour corriger son code, il a collé des informations secrètes : l'adresse de son serveur pirate et son code de chiffrement. Une gaffe qui a permis à Google de localiser tout son système et d'arrêter l'attaque. Même les hackers font des bêtises quand ils confient leurs secrets à une IA. L'arroseur arrosé, en somme.

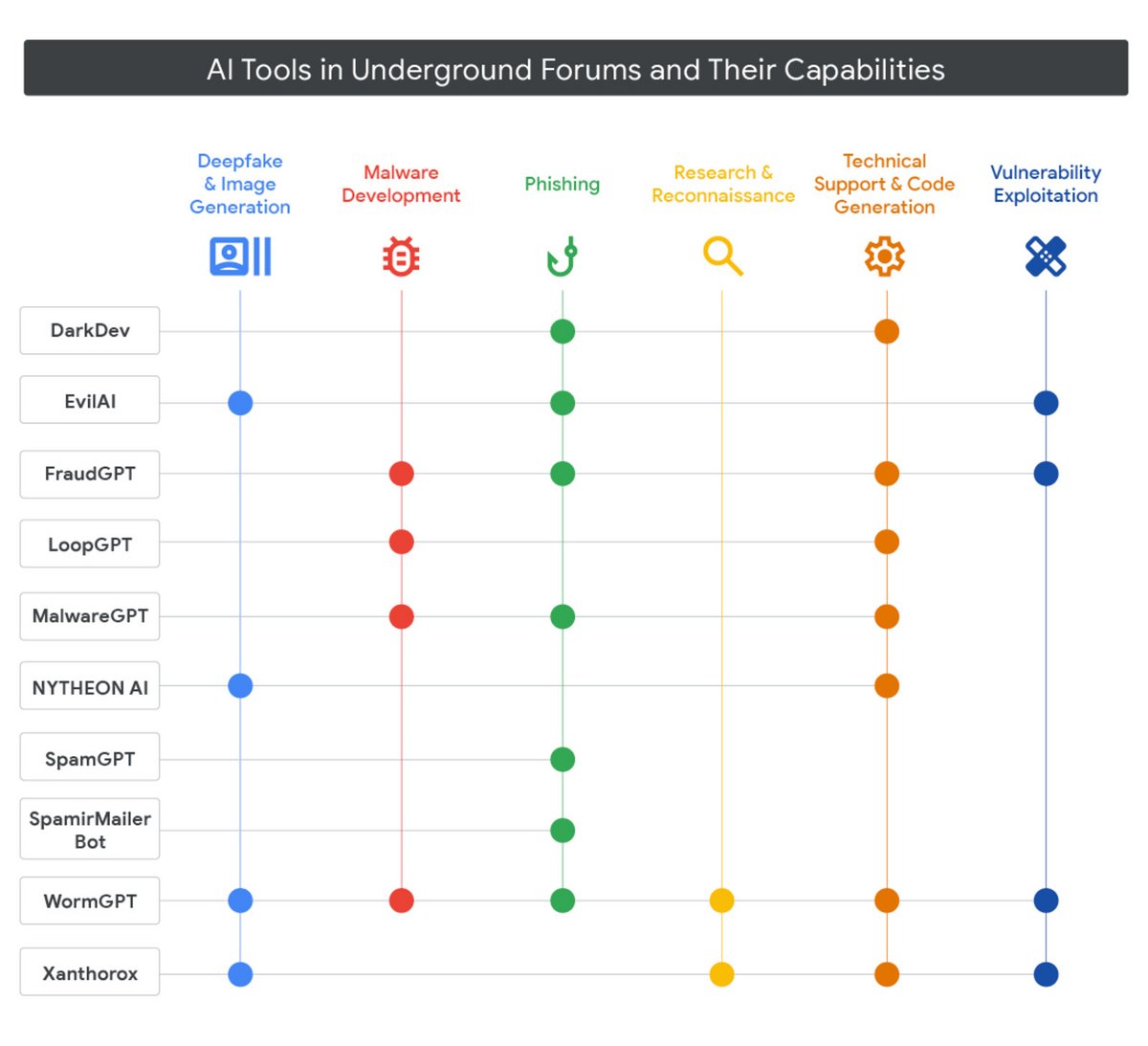

Des services de cybercrime avec support Discord vendus comme un abonnement Netflix

Le marché noir se modernise aussi. En 2025, les sites clandestins vendent des outils de piratage IA comme n'importe quel service en ligne. WormGPT, FraudGPT, DarkDev, MalwareGPT... Ces noms copient ChatGPT et proposent des abonnements comme Netflix. Ils promettent une offre gratuite avec pubs, puis des versions payantes avec plus de fonctionnalités et même une assistance client sur Discord s'il vous plaît ! Les créateurs de virus copient les techniques de vente des géants du numérique pour rendre le cybercrime accessible aux débutants.

Tout cela contribuer à faire chuter les barrières à l'entrée. Plus besoin de maîtriser le code pour lancer une campagne de phishing ou créer un ransomware maintenant, puisque l'IA s'en charge. Google identifie également des outils qui couvrent tout le cycle d'attaque, du deepfake pour contourner la vérification d'identité jusqu'à la recherche automatisée de vulnérabilités. Un criminel amateur peut ainsi orchestrer des opérations jadis réservées aux groupes sophistiqués. La courbe d'apprentissage s'effondre, et le volume de menaces explose, peut-on résumer.

Les gouvernements exploitent aussi massivement l'intelligence artificielle. Corée du Nord, Iran, Chine... tous l'utilisent pour « améliorer toutes leurs opérations de piratage » note le rapport. Le groupe nord-coréen UNC1069 crée même de fausses vidéos pour arnaquer ses cibles dans le secteur des cryptomonnaies. Du repérage initial au vol de données final, en passant par de faux messages en espagnol pour toucher plus de victimes, l'IA devient l'outil universel de l'espionnage. Une guerre technologique discrète, mais redoutable.