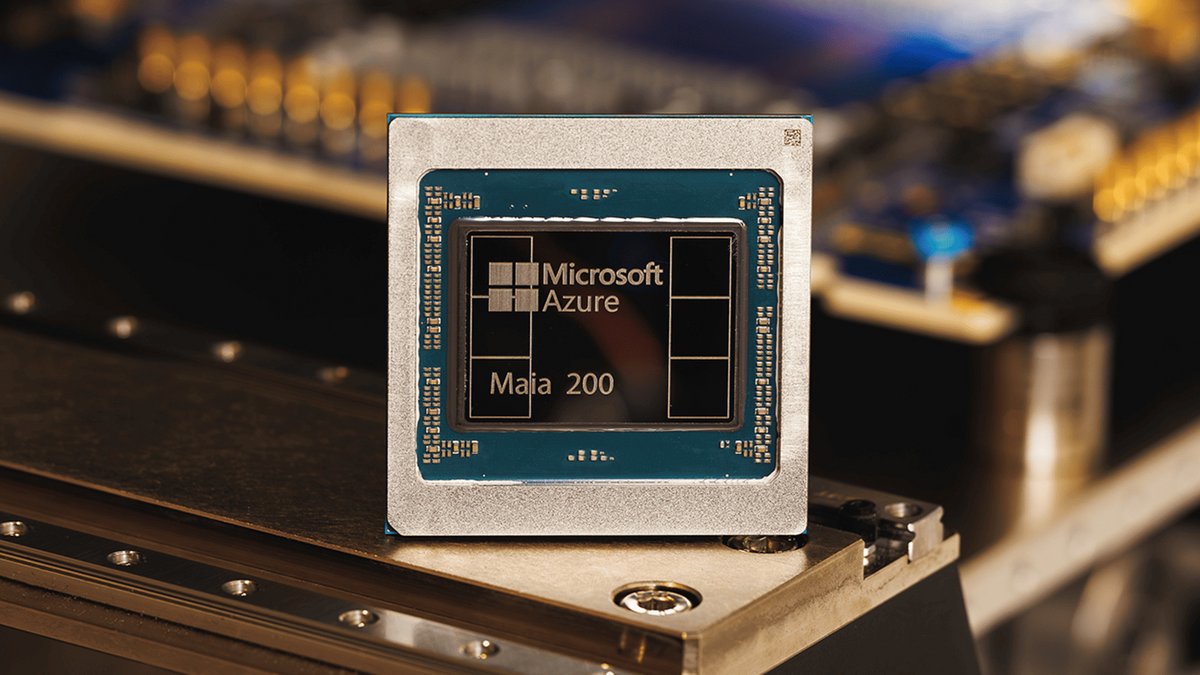

Microsoft a dévoilé lundi son premier accélérateur IA maison, taillé pour l'inférence. Baptisée Maia 200 et gravée en 3 nm, la puce promet des performances record et bouscule Amazon comme Google.

Dans la course aux puces dédiées à l'intelligence artificielle, Microsoft vient de frapper fort. La firme de Redmond a présenté lundi Maia 200, un accélérateur spécialement conçu pour faire tourner les grands modèles d'IA plus rapidement et surtout, de façon plus économique. Déjà déployé dans l'Iowa et bientôt en Arizona aux États-Unis, ce processeur maison affiche des spécifications qui placent Microsoft devant ses rivaux directs du cloud. Une sacrée performance, sur le papier.

Le Maia 200 affiche des performances IA nettement supérieures à celles de ses concurrents

La puce Maia 200 est plutôt… piquante ! Avec plus de 140 milliards de transistors gravés en 3 nanomètres chez TSMC, elle délivre plus de 10 pétaFLOPS en précision 4 bits (FP4) et dépasse les 5 pétaFLOPS en 8 bits (FP8). Concrètement, cela permet de faire tourner sans effort les plus gros modèles actuels, avec encore de la marge pour les générations futures.

Les performances brutes ne font pas tout. Microsoft l'a bien compris en repensant complètement le sous-système mémoire. Le Maia 200 embarque ainsi 216 Go de mémoire HBM3e offrant une bande passante de 7 To/s, complétés par 272 Mo de SRAM sur puce. Des moteurs spécialisés de transfert de données assurent l'alimentation constante des modèles massifs. Microsoft promet ainsi 30% de performances supplémentaires par dollar investi comparé à sa précédente génération.

Les comparaisons avec la concurrence parlent d'elles-mêmes. Le géant américain nous explique que le Maia 200 affiche des performances FP4 trois fois supérieures à celles du Trainium 3 d'Amazon (troisième génération), et surpasse en FP8 le TPU v7 de Google (septième génération). De quoi faire du Maia 200 l'accélérateur propriétaire le plus puissant parmi tous les hyperscalers. Le tout dans une enveloppe thermique de 750 watts, un chiffre maîtrisé pour ce niveau de performance.

Du silicium aux applications, Microsoft contrôle toute la chaîne IA

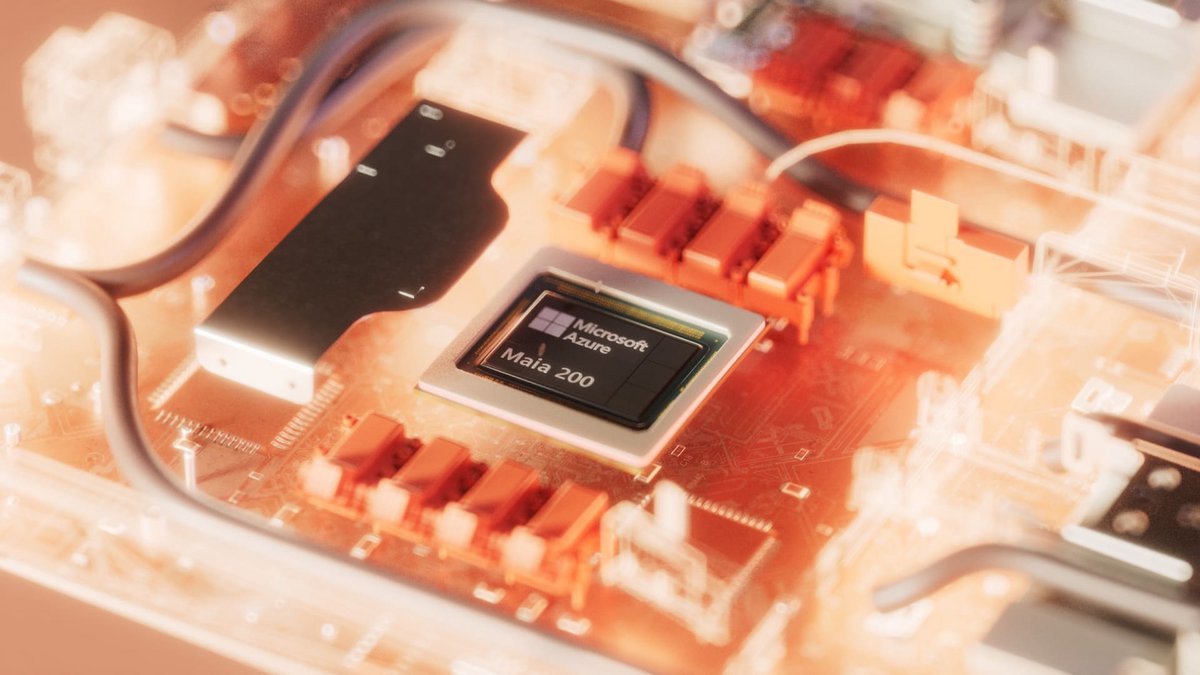

Le Maia 200 n'est pas une annonce en l'air, puisqu'il est opérationnel dès aujourd'hui dans la région US Central de Microsoft près de la ville Des Moines, dans l'Iowa. Les premiers systèmes alimentent déjà les derniers modèles GPT-5.2 d'OpenAI, notamment via Microsoft Foundry et Microsoft 365 Copilot. L'équipe Microsoft Superintelligence exploite quant à elle la puce pour générer des données synthétiques et entraîner ses propres modèles par apprentissage renforcé.

L'architecture réseau est l'autre point fort de l'accélérateur Maia 200. Microsoft a opté pour une conception à deux niveaux basée sur Ethernet standard. Chaque accélérateur dispose de 2,8 To/s de bande passante bidirectionnelle dédiée, qui permettent de créer des clusters allant jusqu'à 6 144 accélérateurs. Cela devrait éviter de coûteuses infrastructures propriétaires, tout en garantissant des performances prévisibles. L'intégration native avec Azure simplifie aussi la gestion, maximise la fiabilité et réduit les temps d'indisponibilité.

Pour accompagner les développeurs, Microsoft met à leur disposition un kit de développement complet. Celui-ci comprend une intégration PyTorch, un compilateur Triton, une bibliothèque de kernels optimisés, un accès au langage de programmation bas niveau du Maia, ainsi qu'un simulateur et un calculateur de coûts. L'approche vertically integrated (silicium, modèles et applications pensés ensemble) permet à Microsoft d'affiner chaque maillon de la chaîne, de la puce jusqu'aux applications finales. Un avantage sur lequel l'entreprise entend bien capitaliser, face à une concurrence de plus en plus féroce.