Un chouia en « retard » par rapport à la date de sortie de la génération de cartes graphiques précédente, NVIDIA met aujourd’hui le cap sur les GeForce RTX 4000, dites « Ada Lovelace ». Les choses débutent de manière sérieuse avec le modèle le plus musclé de la gamme : à présent disponible, la RTX 4090 est un monstre, dans tous les sens du terme.

- Performances affolantes !

- DLSS 3 très convaincant

- Ventilation plutôt discrète

- Échauffement contenu

- Design encore très réussi

- Connecteur 12VHPWR

- Est-ce bien raisonnable ?

- Pas de sortie USB-C

- Prix et taille, forcément

La gamme Ada Lovelace, comme les Turing ou Ampere avant elle, est prévue pour nous arriver en plusieurs salves. Une fois n’est toutefois pas coutume, NVIDIA démarre fort et alors que les séries 1000, 2000 ou 3000 avait été lancées par le modèle x080, c’est donc la RTX 4090 qui ouvre le bal. Un aveu de faiblesse sur le reste du catalogue ou une manière de faire trembler son concurrent direct alors qu’AMD prévoit de présenter RDNA 3 dans un tout petit mois ?

MàJ 15/11/2022 : notre test de la GeForce RTX 4080 est disponible.

Fiche technique NVIDIA GeForce RTX 4090

Résumé

Performances

Affichage

Connectivité

Caractéristiques physiques

76,3 milliards de transistors

Mathématicienne du XIXe siècle, Ada Lovelace est passée à la postérité pour avoir écrit le premier programme informatique conçu pour être exécuté par une machine. En dehors de son enthousiasme pour les calculateurs universels, on cherchera en vain un lien entre Augusta Ada King, comtesse de Lovelace et la société NVIDIA qui s’approprie donc le nom de l’Anglaise pour sa troisième génération de GPU RTX.

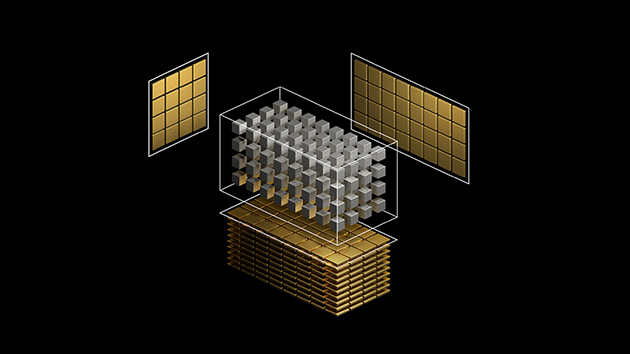

De prime abord, on est un peu déçu de voir que finalement NVIDIA a décidé de repousser l'utilisation d’une architecture multichip – à base de chiplets – comme c’est le cas sur les Ryzen. Il faudra vraisemblablement attendre la sortie de la génération Hopper, architecture datacenter prévue par NVIDIA en parallèle de Lovelace. Nos GeForce RTX 4000 se fonderont sur un GPU « vieille école » que l’on qualifie de monolithique pour signifier qu’il se repose sur un die unique.

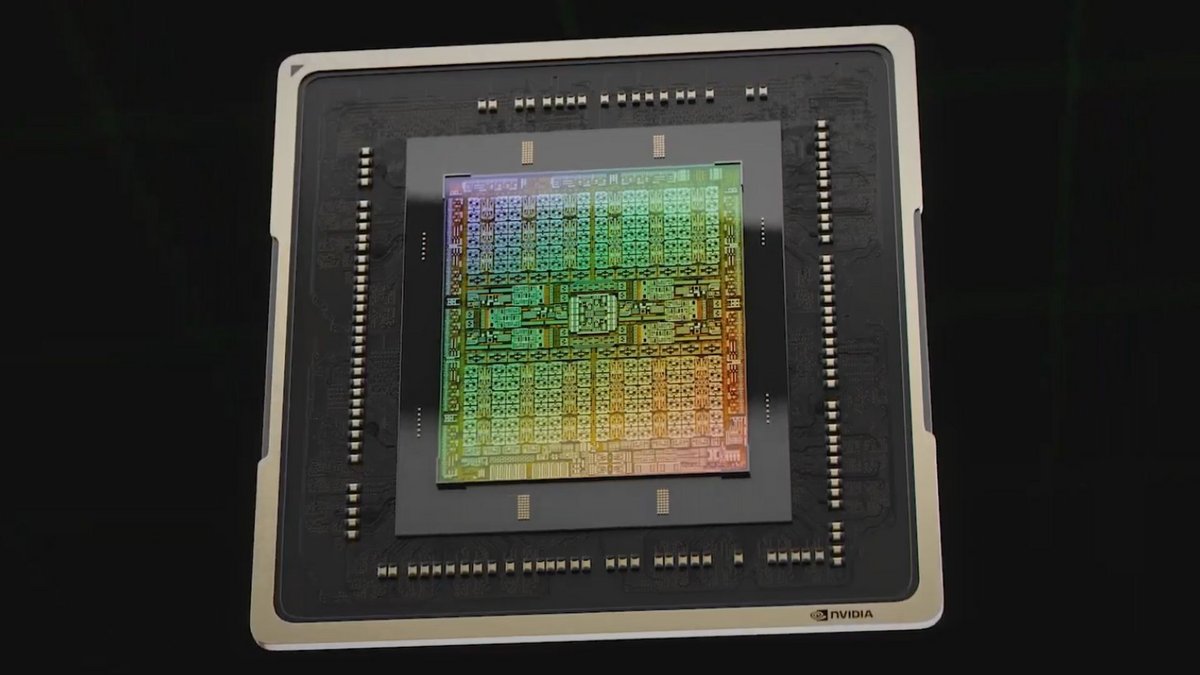

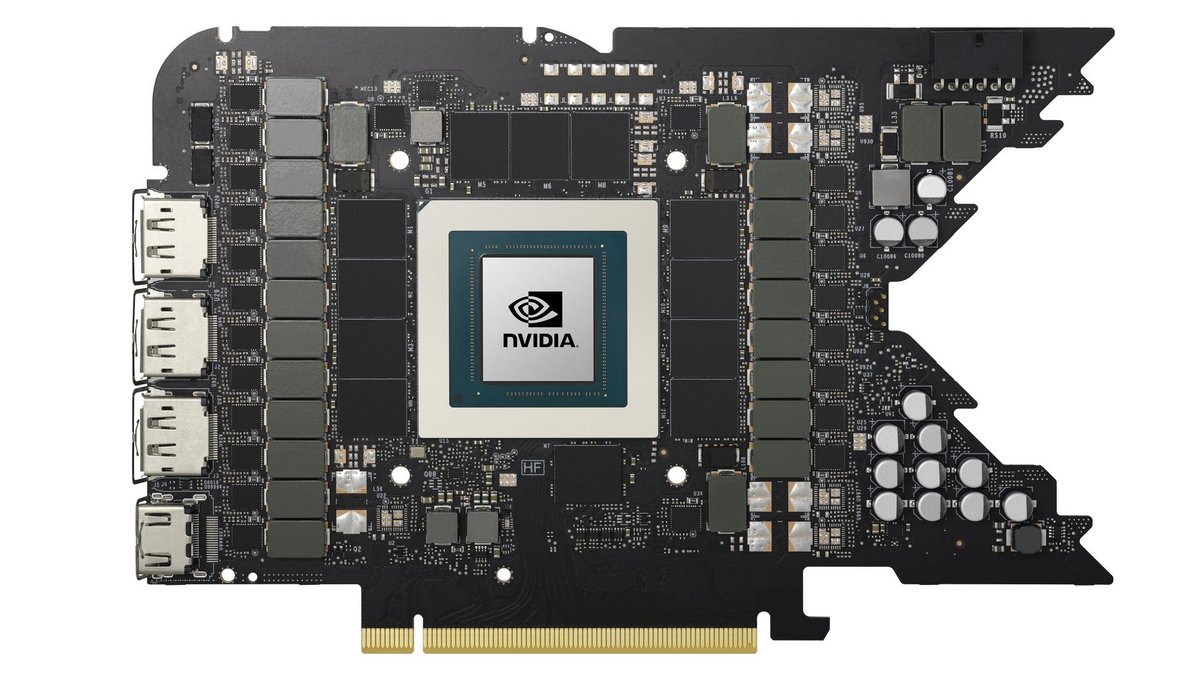

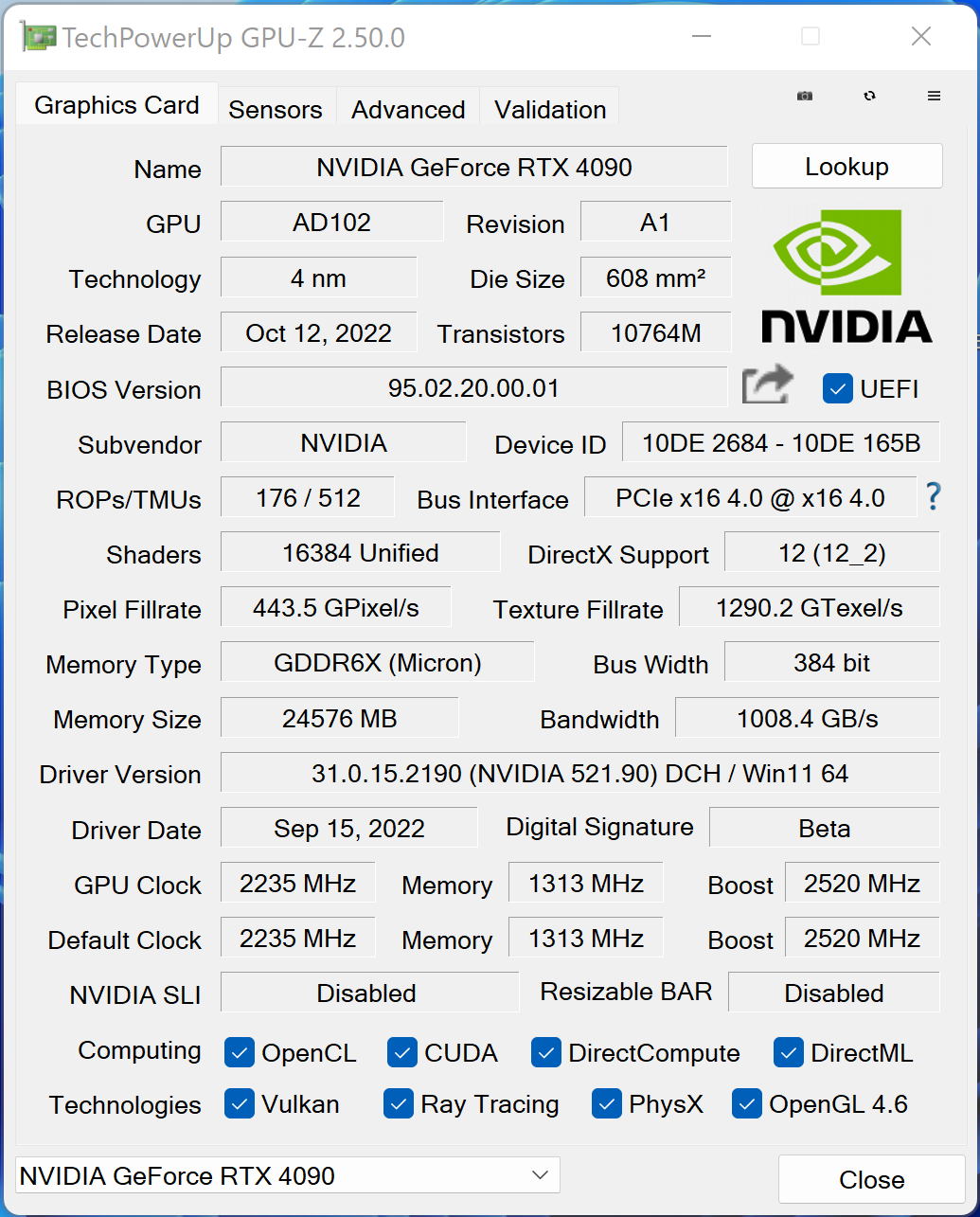

Pour autant, NVIDIA ne semble pas avoir lésiné sur les nouveautés. Au cœur de l’architecture se trouve donc le GPU AD102 lequel se repose sur le processus de gravure 4N du Taïwanais TSMC. Une finesse de gravure plus importante (5 nm) qui a permis à NVIDIA de « tasser » davantage de transistors comme le rappelle notre intertitre : l’AD102 agrège la bagatelle de 76,3 milliards de transistors dans sa version complète alors que le GA102 de l’architecture Ampere se contentait de 28,3 milliards !

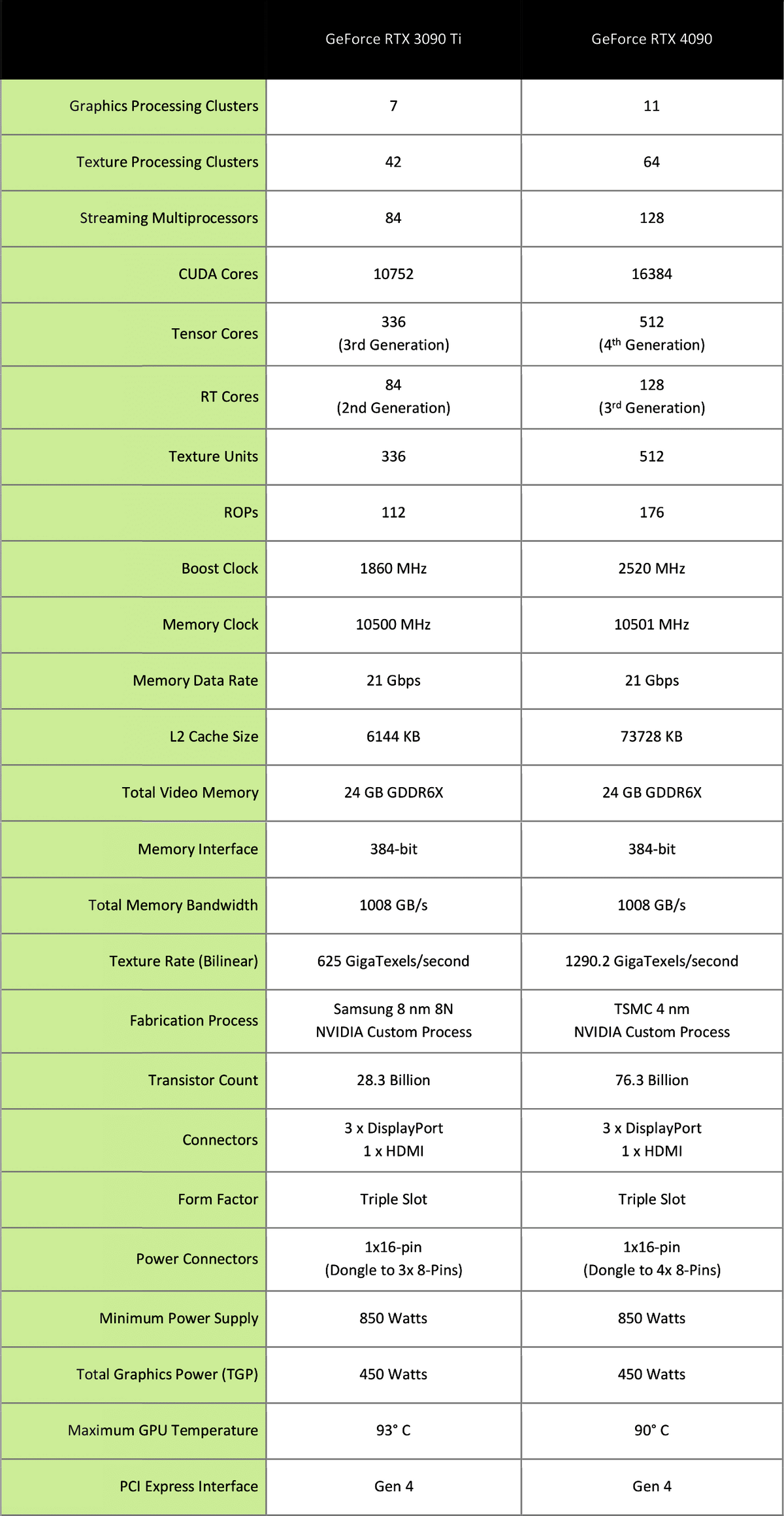

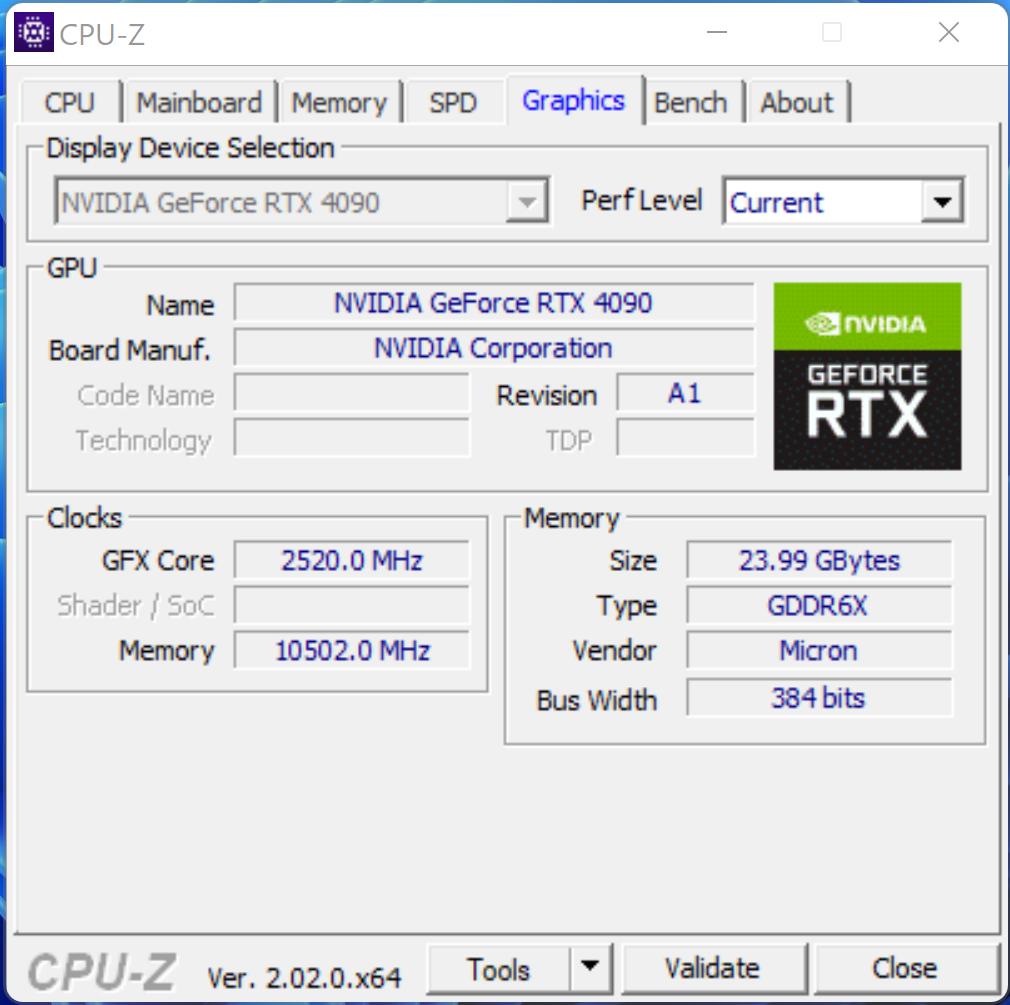

Nous aimons autant que vous les comparaisons alors continuons. Toujours dans sa version complète, l’AD102 totalise 18 432 cœurs CUDA contre seulement 10 752 sur le GA102. Il est aussi question de 144 streaming multiprocessors contre 84, de 144 cœurs RT contre 84 et de 576 cœurs Tensor contre 336. Si la capacité, l’interface et la fréquence mémoire sont identiques (24 Go, 384-bit, GDDR6X), le GPU profite d’une fréquence de boost largement améliorée, 2,5 GHz contre 1,9 GHz.

3e gen de cœurs RT, 4e gen de cœurs Tensor

Depuis tout à l’heure, nous parlons de « version complète » du GPU AD102 car sur la GeForce RTX 4090, NVIDIA a opté pour une mouture légèrement amoindrie. Sans doute une façon de se laisser une marge de manœuvre pour une future RTX 4090 Ti. Toujours est-il que la RTX 4090 se limite à 16 384 cœurs CUDA, 128 cœurs RT et 512 cœurs Tensor. Côté fréquence GPU ou mémoire vidéo en revanche, rien ne change.

Comme vous pouvez en juger sur le tableau un peu plus haut, même avec un GPU amoindri, la GeForce RTX 4090 dispose d’une fiche technique largement supérieure à celle de la GeForce RTX 3090 Ti, pourtant déjà une belle bête. Au-delà des chiffres, NVIDIA tient toutefois à transmettre un message : toutes les technologies mises en œuvre ont évolué. Il est maintenant question de cœurs RT de 3e génération et même de 4e génération pour les cœurs Tensor.

Les cœurs Tensor sont des spécialistes de l’intelligence artificielle (IA) et du « calcul haute performance » (HPC). NVIDIA insiste sur l’introduction d’un nouveau format de données (FP8) qui vient « réduire de moitié les besoins en stockage tout en doublant les performances d’IA ». Avec une puissance de traitement de 1,3 PetaFLOPS, cette 4e génération permet à la RTX 4090 de doubler celle des cœurs Tensor de la RTX 3090 Ti.

Comme leur nom l'indique, les cœurs RT sont conçus pour accélérer le traitement du rendu ray tracing. Sur sa 3e génération de cœurs, NVIDIA introduit deux nouveautés essentielles, les moteurs Box Intersection et Triangle Intersection : leur objectif est l'augmentation du niveau de détails en doublant le débit d'intersections rayon-triangle. Par ailleurs, le moteur Opacity Micromap rend plus rapide la création d'objets translucides tandis que le Displaced Micro-Mesh dope la création de volumes complexes. L'un dans l'autre, NVIDIA annonce un traitement ray tracing 2,8x plus efficace sur Lovelace par rapport à Ampere.

Optimisation des shaders

Parallèlement à cette remise à niveau des cœurs RT et Tensor, NVIDIA a largement augmenté le nombre de multiprocesseurs de streaming (SM). On parle de 128 unités contre 84 sur la RTX 3090 Ti. Non content d’être plus nombreux, ces SM sont déchargés d’une partie de leur travail par les cœurs RT. Ils peuvent dès lors déployer toute leur puissance : NVIDIA évoque 83 shader-TFLOPS, deux fois plus que ce qu’offrait Ampere.

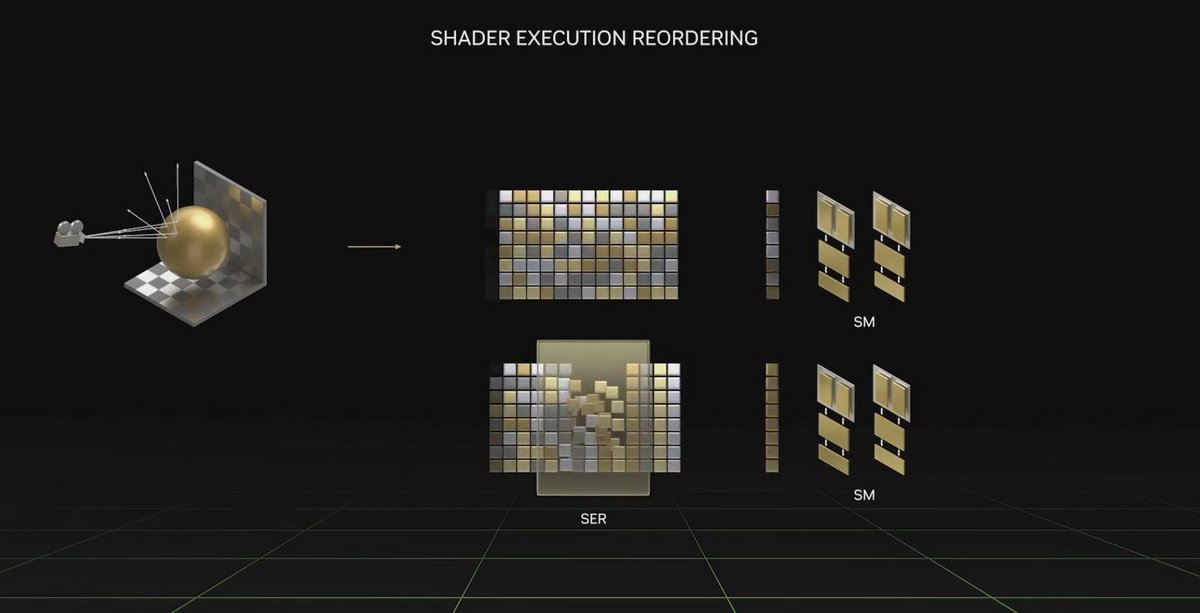

Pour ne rien gâcher, une nouvelle technologie a été mise en place, le Shader Execution Reordering (SER). Il s'agit de réorganiser à la volée les tâches de gestion des shaders. Les SM ne sont plus contraints d’attendre les bonnes données pour avancer, elles sont dynamiquement réorganisées afin d’améliorer l’efficacité de toute la procédure de shading. NVIDIA parle de performances en hausse de 44% sur Cyberpunk 2077.

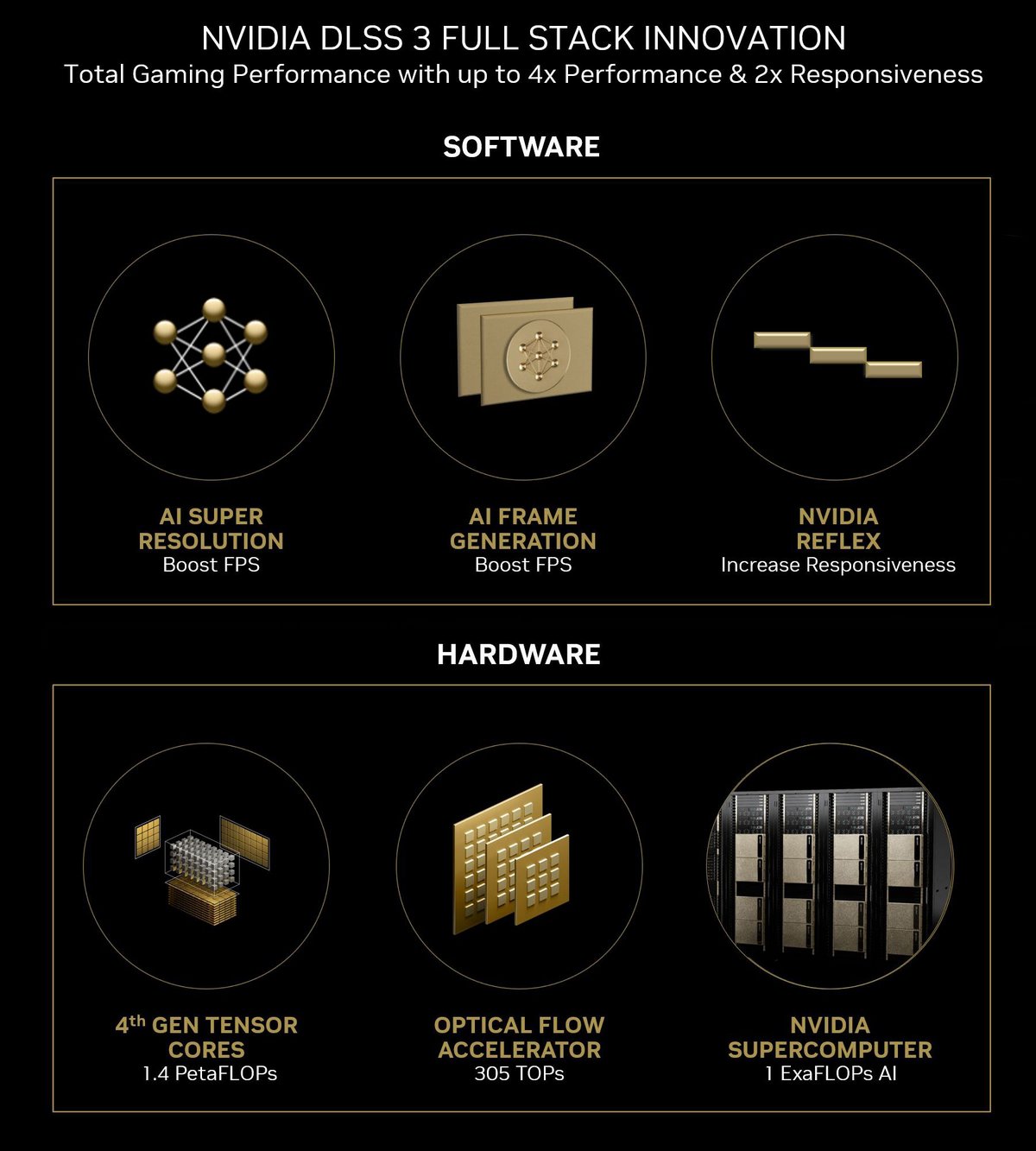

DLSS 3 : une percée « révolutionnaire » ?

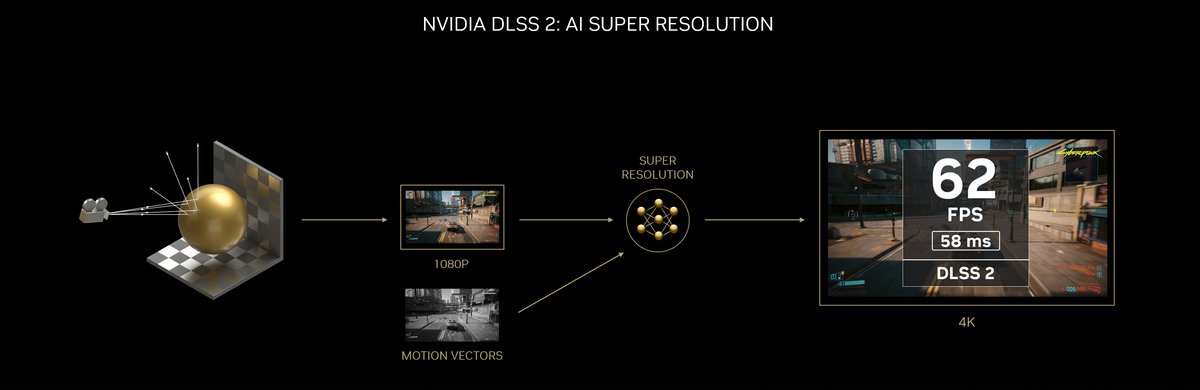

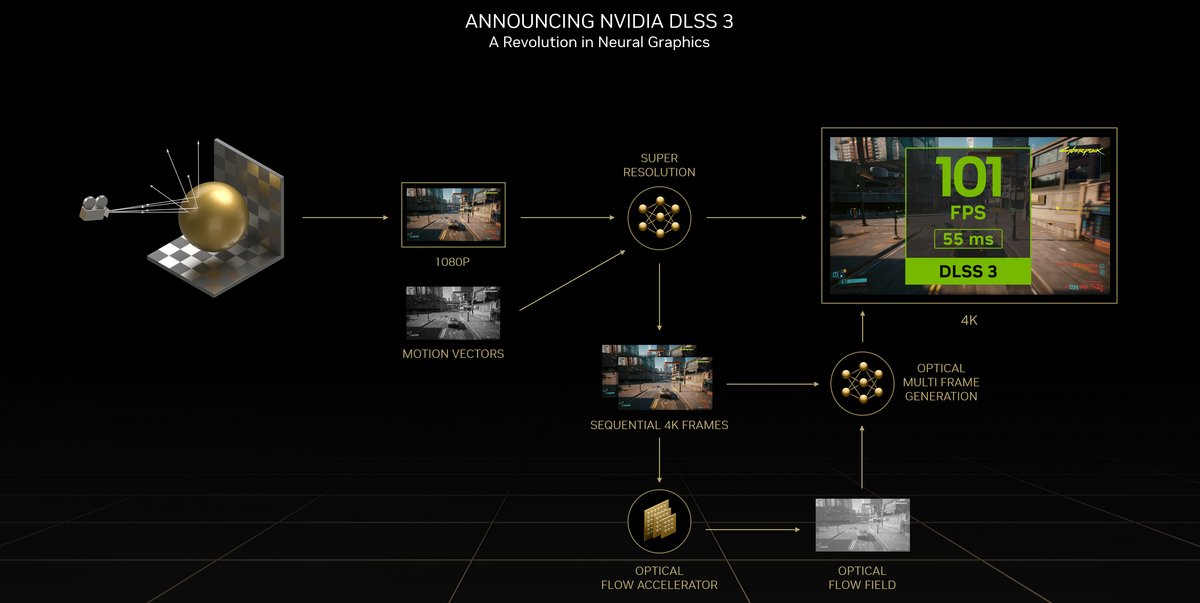

Multiprocesseurs de streaming, cœurs RT et cœurs Tensor sont les trois composantes essentielles de l’architecture Lovelace laquelle est entièrement tournée vers le DLSS 3. NVIDIA ne mâche pas ses mots pour évoquer la troisième version de sa technique de super-échantillonnage qu’il juge tout bonnement « révolutionnaire ». Pour justifier ce superlatif, le fabricant évoque un « rendu neuronal » qui se base tout d’abord sur les progrès du DLSS 2.

Fonctionnements comparés de DLSS 2 et DLSS 3 © NVIDIA

Sur le principe, on part donc toujours d’une image rendue en 1 080p par exemple, et de vecteurs de mouvement pour en travailler l’échantillonnage dans une définition plus élevée. Toutefois, le DLSS 3 ne se contente pas de cette étape et NVIDIA introduit ce qu’il nomme l’Optical Flow Accelerator. Ce dernier analyse deux images séquentielles du jeu et en tire un « champ de flux optique » qui permet de prendre des informations sur la direction et la vitesse des pixels.

Au travers de ces deux images retenues, l’accélérateur de flux optique analyse les particules, les ombres, les reflets et les éclairages. Le DLSS 3 ajoute une analyse des vecteurs de mouvement dans le but de suivre les « déplacements géométriques » dans la scène et combine ces multiples informations. Pour chaque pixel, le moteur de génération des images de DLSS 3 est alors capable de décider comment utiliser ces éléments pour créer des images intermédiaires, les imaginer avant même leur rendu.

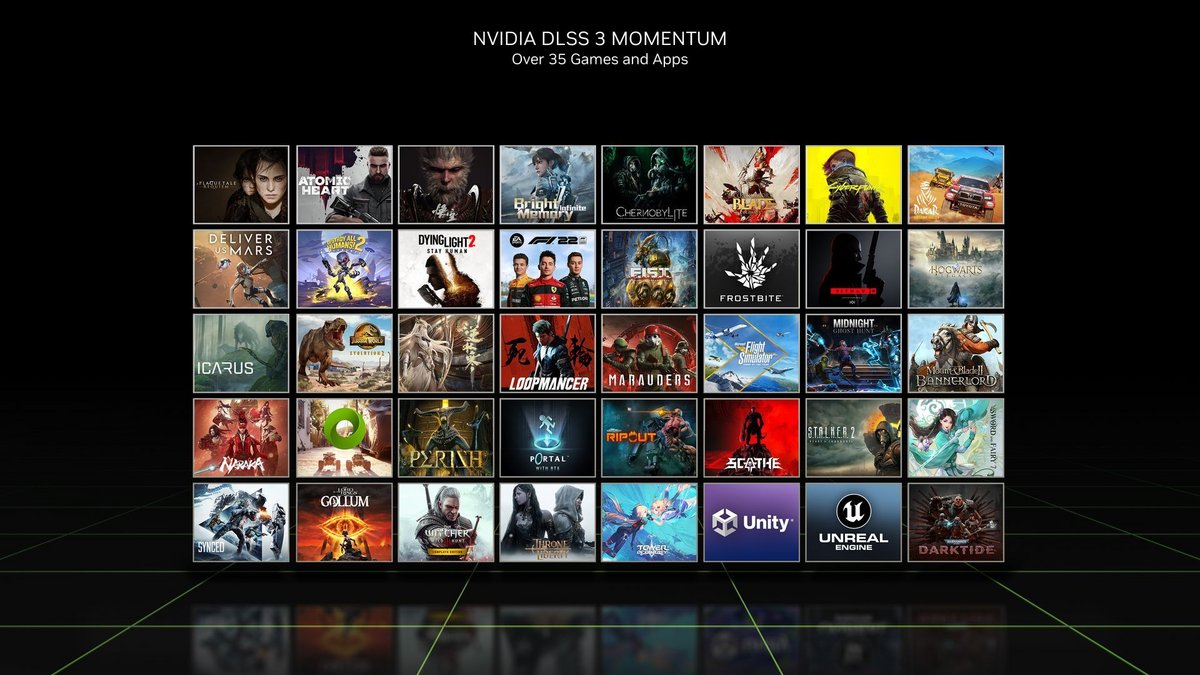

Sachez qu'à la sortie de la GeForce RTX 4090 – le 12 octobre – il est prévu que plus de 35 jeux et outils soient compatibles avec le DLSS 3 parmi lesquels A Plague Tale: Requiem, Cyberpunk 2077, F1 22, Hitman 3, Microsoft Flight Simulator, Portal with RTX, S.T.A.L.K.E.R. 2: Heart of Chernobyl, The Lord of the Rings: Gollum, The Witcher 3: Wild Hunt, Warhammer 40,000: Darktide…

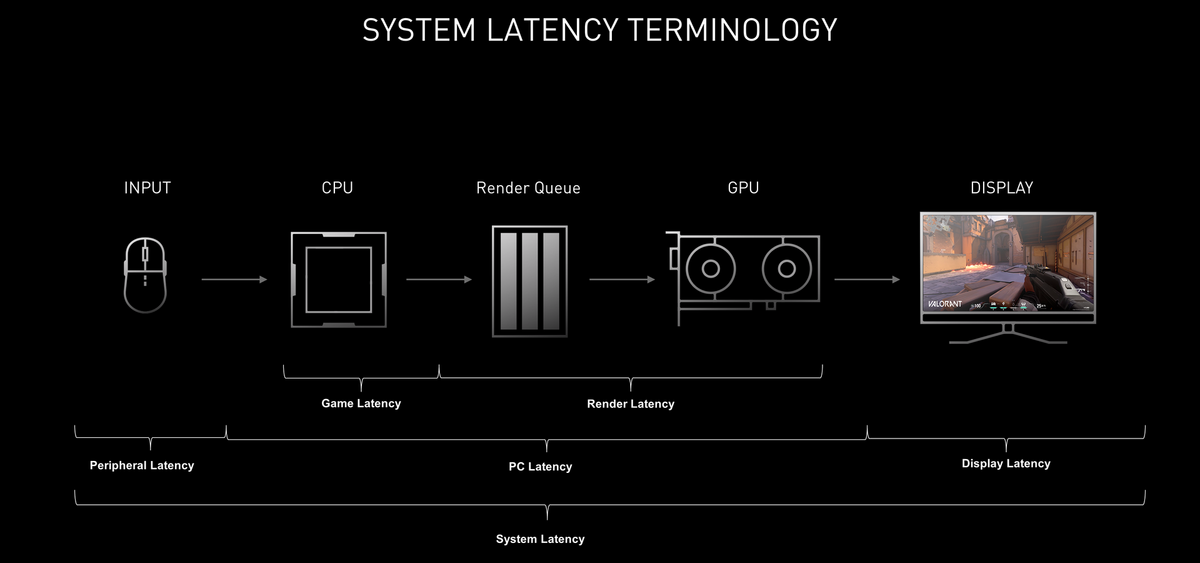

Prendre le bon Reflex

En utilisant aussi bien les vecteurs de mouvement du moteur graphique déjà exploités par DLSS 2 et en y ajoutant le flux optique pour suivre le mouvement, DLSS 3 est capable de reconstruire avec précision à la fois la géométrie et les effets graphiques. Ce processus est géré par ce que NVIDIA baptisé le DLSS Frame Generation. Problème, l’opération ne se fait pas en claquant des doigts et elle entraîne nécessairement une certaine latence. C’est là que Reflex entre en jeu.

Déjà présenté par NVIDIA dans le cadre du développement de l’eSport. Reflex s’offre ici un nouveau débouché. Il n’est plus nécessairement question de se plier aux besoins des amateurs de jeux compétitifs, mais plutôt de compenser la latence induite par DLSS 3. De fait, Reflex est partie intégrante de DLSS 3 : en synchronisant le travail du CPU et du GPU, Reflex s’assure qu’aucun de deux ne prenne l’ascendant sur l’autre, réduit la latence et rend l’ensemble plus réactif.

Duo d’encodeurs AV1

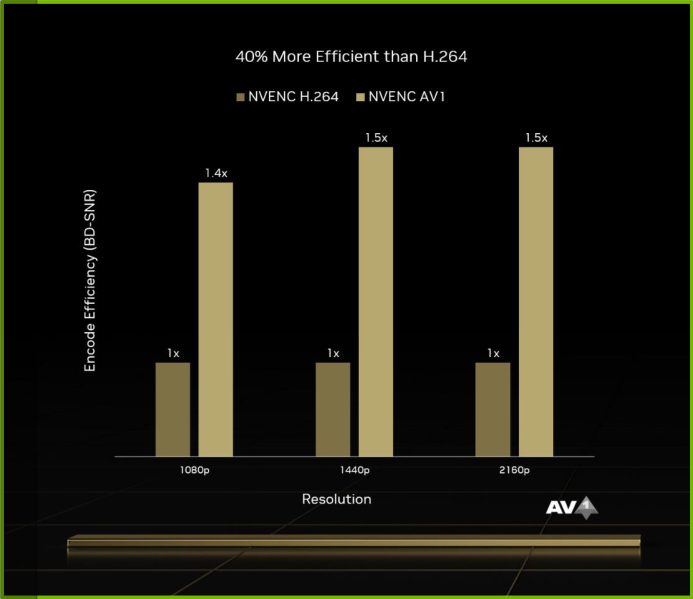

Sans doute plus anecdotique pour de nombreux lecteurs, mais pas pour les futurs acheteurs de la gamme RTX 4000, l’architecture Lovelace assure, de manière matérielle, l’encodage AV1. Celui-ci vient bien sûr en plus des H.264/H.265 des RTX 3000, mais se montre plus efficace : au choix, on peut conserver le bitrate pour améliorer la qualité d'encodage ou opter pour un bitrate plus faible tout en gardant une image identique. Ce second cas permet alors de réduire nettement la taille des vidéos.

NVIDIA estime que l’encodeur AV1 de Lovelace est 40 % plus efficace que l’encodeur H.264 d’Ampere et précise que les GPU RTX 4000 n’intègrent plus un, mais deux moteurs d’encodage. Le but est de les faire travailler en parallèle : Lovelace est à même de scinder les images en moitiés qu’il envoie simultanément aux encodeurs pour, ensuite, recomposer une scène unique à expédier pour finaliser la vidéo. L’encodage est ainsi deux fois plus rapide que sur un GPU RTX 3000.

La RTX 4090 FE à côté de la RTX 3080 Ti FE © Nerces

RTX 4090 : la Founders Edition dans le détail

Vous n’êtes pas sans savoir que NVIDIA compte sur de nombreux partenaires pour produire des cartes graphiques RTX 4090 en plus du modèle Founders Edition que nous testons. Ces modèles « partenaires » présentent un design nettement différent et souvent plus volumineux que la carte NVIDIA avec une triple ventilation qui doit permettre de pousser un peu les fréquences de fonctionnement du GPU.

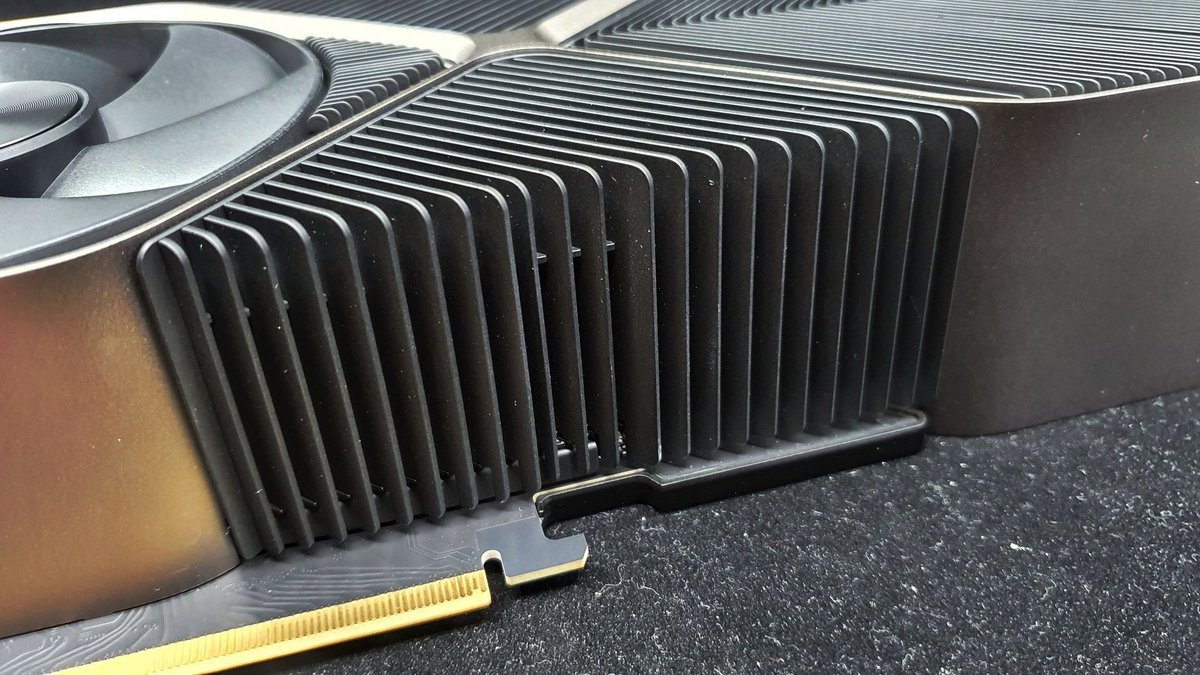

NVIDIA et Gamers Nexus détaillent le refroidisseur de la RTX 4090… avec violence !

Dans le cas de la Founders Edition, on se trouve en présence d’un design très proche de celui des GeForce RTX 3090 FE et RTX 3090 Ti FE. Un carénage au style très épuré vient masquer l’imposant dissipateur, lequel est conçu autour d’un assemblage de caloducs et d’une chambre de vapeur. Ces deux éléments viennent « extraire » la chaleur émise par le GPU pour la conduire vers les multiples ailettes du bloc de dissipation. Ensuite, des ventilateurs se chargent de l’expulser comme nous vous l'avions expliqué lorsque nous avons fait l'unboxing de la carte.

Notre GeForce RTX 4090 Founders Edition sous toutes les coutures © Nerces

NVIDIA souligne que malgré la proximité apparente du design, son dissipateur a été retravaillé afin d’accentuer son efficacité. Il précise surtout que de nouveaux ventilateurs ont été mis en place : plus grands, exploitant des roulements dits « fluid dynamic » et placés en rotation inversée, ils doivent produire un flux plus important tout en réduisant les nuisances sonores. Pour le même niveau de bruit, NVIDIA évoque un flux 15% plus efficace.

Protocole de test

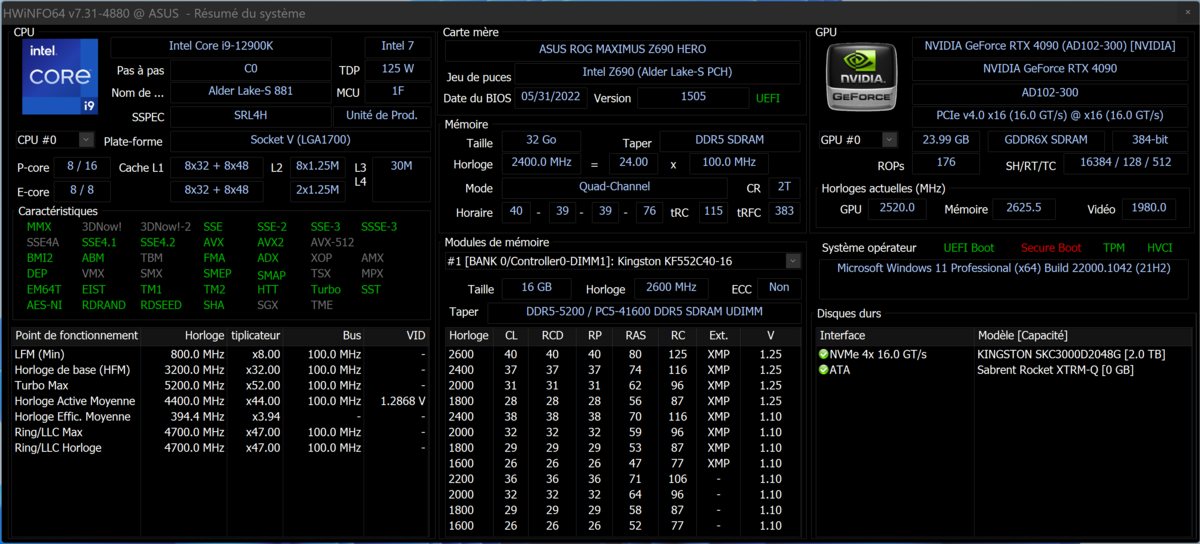

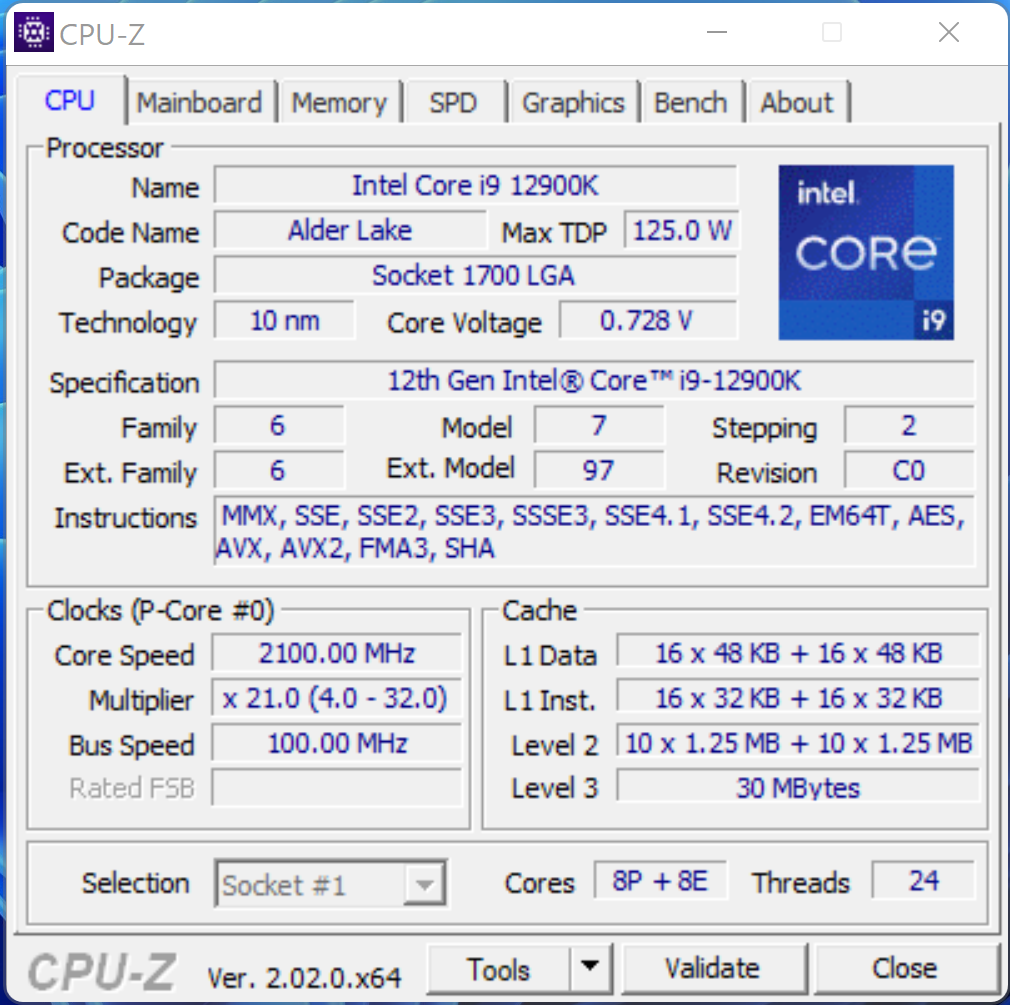

Afin de faire honneur aux cartes graphiques de nouvelle génération, nous avons largement revu notre protocole de test. Bien sûr, la base reste la même en ce sens qu’il ne nous semblait pas utile de refondre la configuration mise en place.

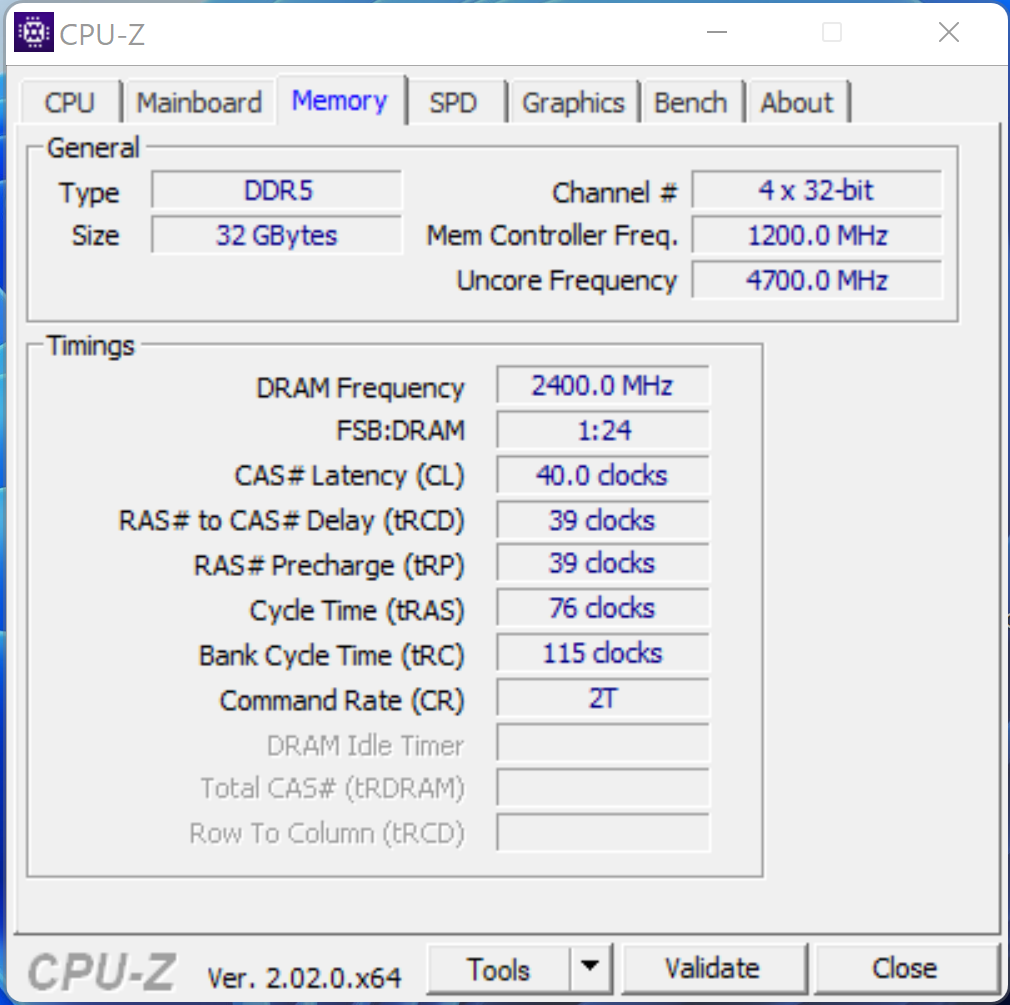

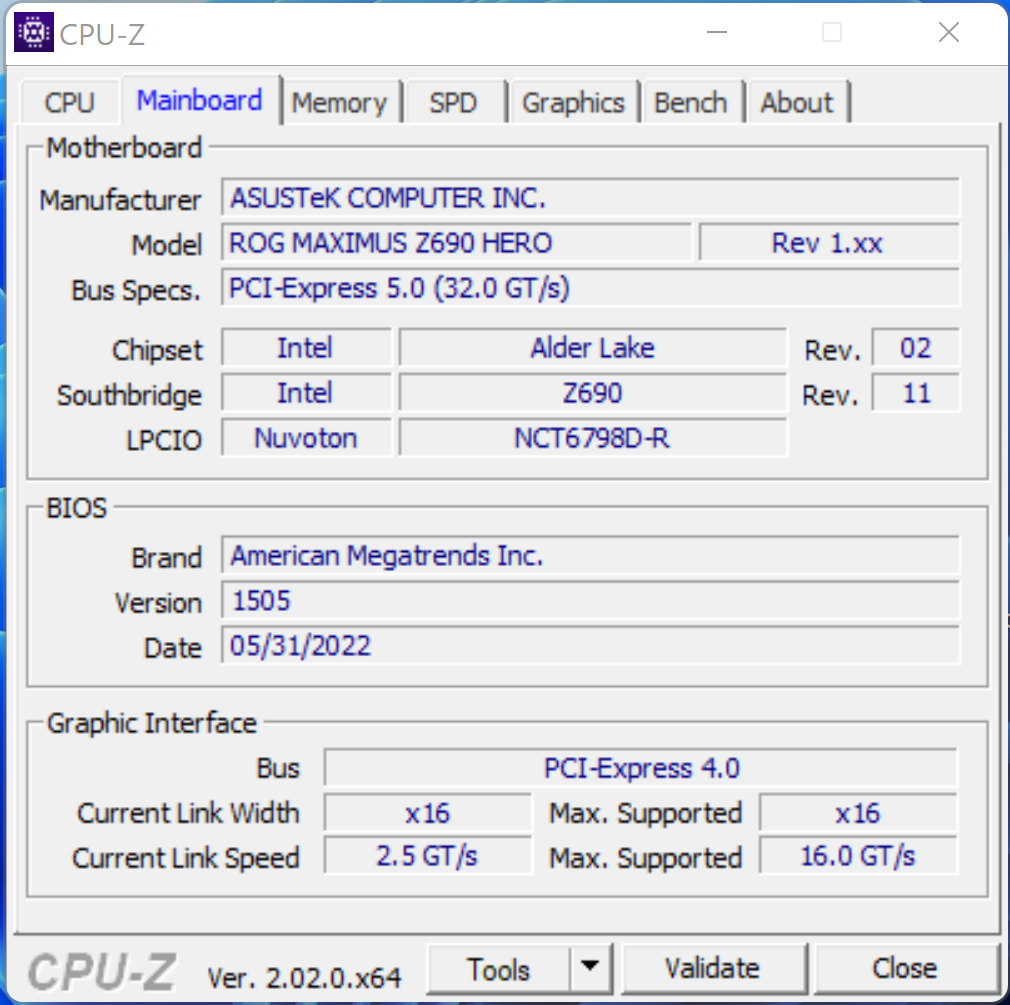

Nous enchaînons ensuite avec les multiples onglets de CPU-Z © Nerces

Configuration de test

- Carte mère : ASUS ROG Maximus Z690 Hero

- Processeur : Intel Core i9-12900K

- Mémoire : Kingston Fury DDR5-4800 CL38 (2x 16 Go)

- SSD « système » : Kingston KC3000 2 To

- Refroidissement : ASUS ROG Ryujin II 360

- Alimentation : be quiet! Straight Power 11

Les logiciels mis en œuvre ont évolué. Nous sommes sur Windows 11 en version Professionnel 64-bit 22H2 22621.607. NVIDIA nous a fourni la dernière mouture de ses pilotes (521.90) afin que la RTX 4090 FE soit reconnue et notre plateforme Z690 exploitait les pilotes chipset Intel 10.1.18838.8284. Pour la Radeon RX 6900XT, ce sont les pilotes AMD 22.20.29.01 RC6 qui ont été employés.

Tout est en place, même l'adaptateur et les câbles 8 broches ! © Nerces

Qu’en est-il des performances ?

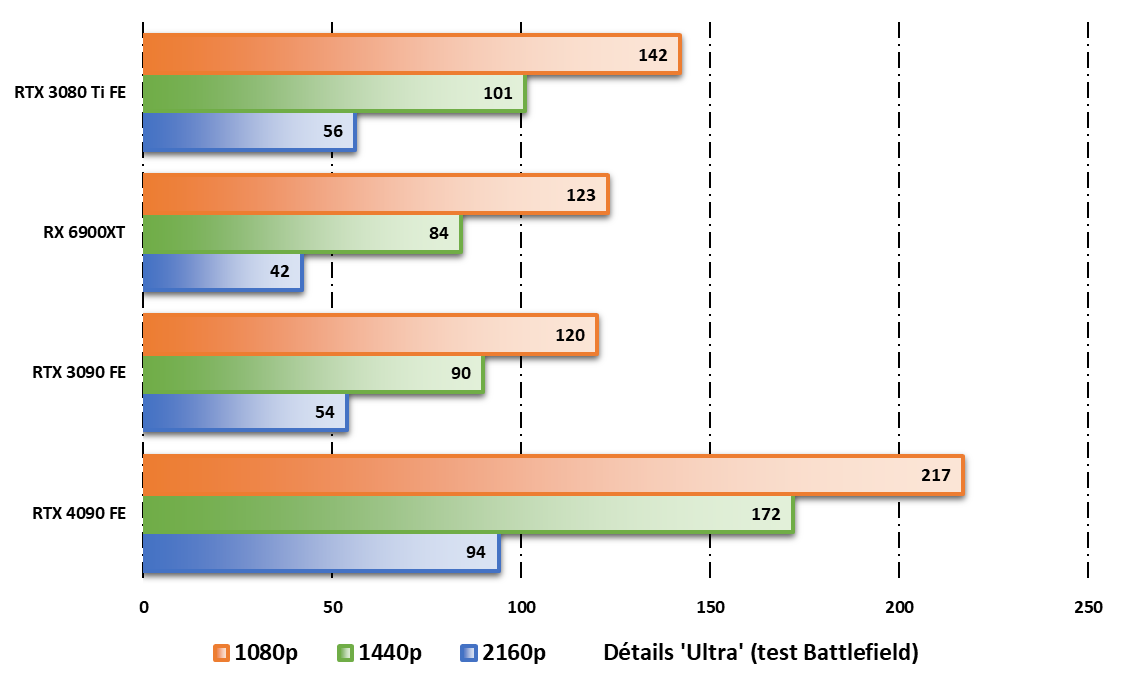

Inutile de vous faire un dessin, la GeForce RTX 4090 est une carte puissante, très puissante même, qu’il n’est pas utile de comparer à une GTX 1650 par exemple. Nous avons décidé de réduire considérablement les graphiques et de ne comparer notre cobaye du jour qu’aux GeForce RTX 3080 Ti, RTX 3090 et Radeon RX 6900XT.

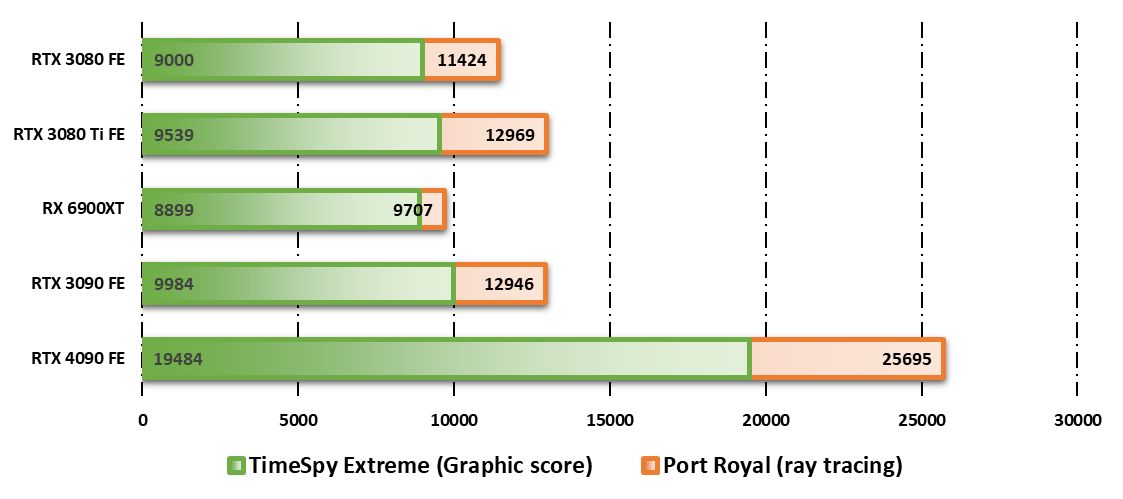

3DMark

Utilisé depuis la nuit des temps, 3DMark est un outil pratique pour évaluer rapidement une configuration. Il ne saurait toutefois se substituer à des tests « réels », ce n’est qu’un indicateur. De manière générale, les Radeon RX se comportent bien avec ce soft, mais la RTX 4090 est intouchable.

Les écarts sont stupéfiants et sur TimeSpy Extreme, la RTX 4090 vient plus que doubler les résultats de la RTX 3090. En toute logique, une RTX 3090 Ti – que nous n’avions pas sous la main – aurait permis à Ampere de limiter les dégâts, mais pas de modifier l’impression de facilité qui émane de la RTX 4090 laquelle domine de la même manière sur la scène Port Royal favorisant le ray tracing.

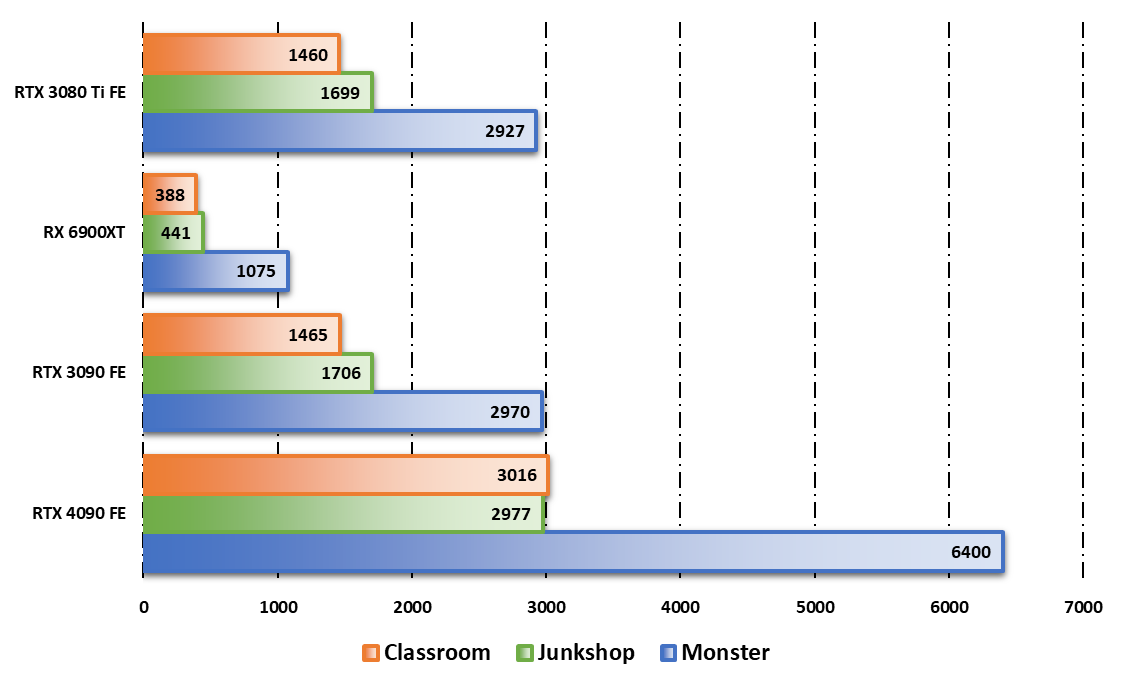

Blender Benchmark

Alors que nous sommes en pleine refonte de notre protocole de test, nous avons décidé d’intégrer un outil plus « professionnel » afin de rendre compte d’un usage moins ludique. Par son moteur de rendu 3D, Blender Benchmark met davantage à contribution les GPU puissants et exploite pleinement les 24 Go de GDDR6X de la RTX 4090.

De manière encore plus nette que sur 3DMark, la petite dernière de NVIDIA s’assure une première place méritée. Aucune contestation n’est possible et si les Radeon RX 6000 ne brillent pas sur cet exercice, même les plus puissantes cartes Ampere sont largement distancées : on parle tout de même de doubler les performances d’une RTX 3080 Ti.

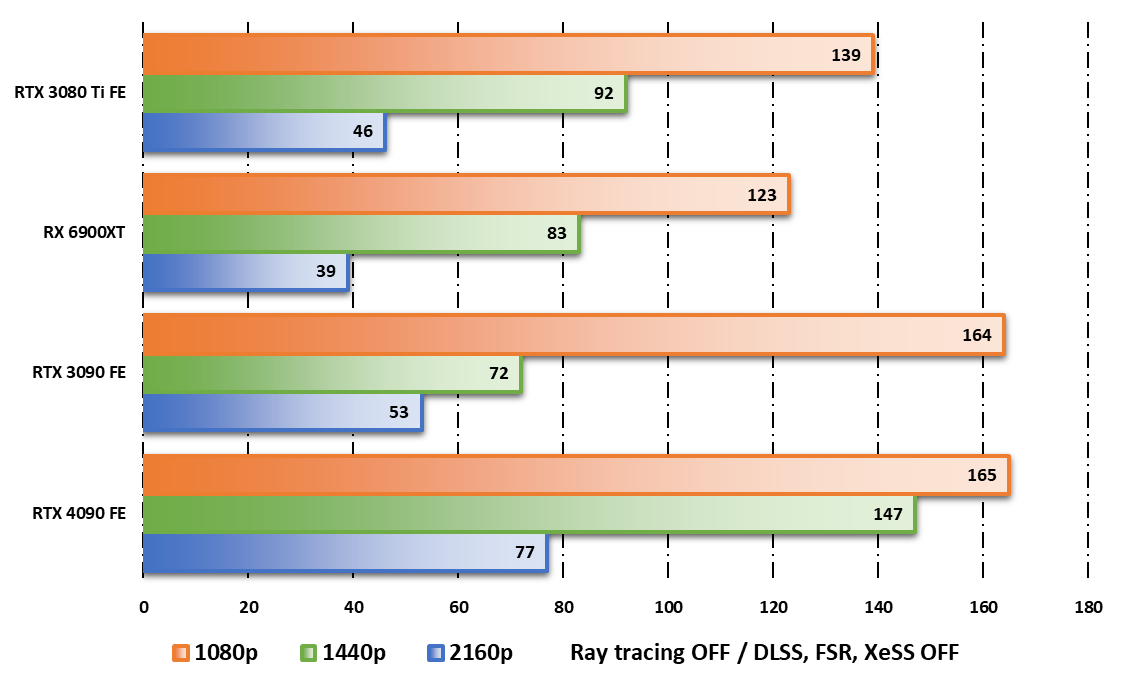

Cyberpunk 2077

S'il est toujours difficile de parler de « plus beau jeu du monde », il est certain que Cyberpunk 2077 est une merveilleuse vitrine technologique du monde PC. Pourtant, notre premier test ne cherche pas à mettre genoux les cartes graphiques en se focalisant sur le seul rendu « ultra ». La RTX 4090 s’impose tout de même largement, notamment en 4K où l'on note un progrès de plus de 50 % par rapport à la RTX 3090.

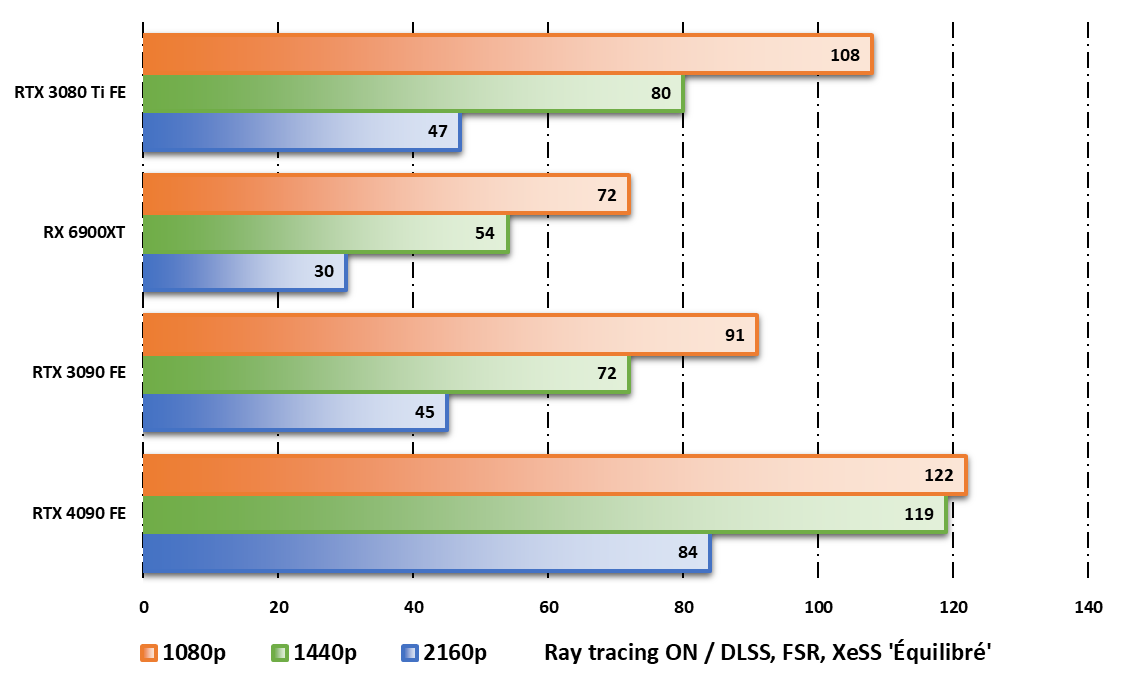

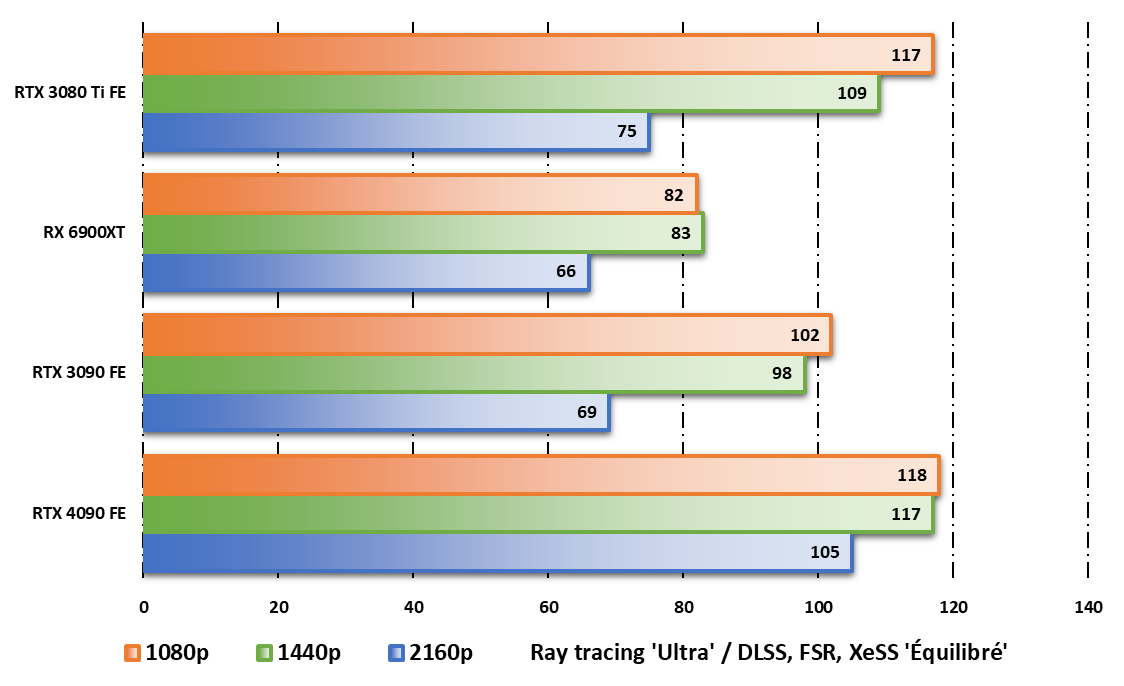

Cyberpunk 2077 et le ray tracing

Afin d'enfoncer le clou et, surtout, de se tourner vers l’avenir, nous faisons un second test Cyberpunk 2077 en activant cette fois le ray tracing en mode « ultra ». Nous optons aussi pour le mode de super-échantillonnage le plus indiqué de chaque carte, en réglage « équilibré ». Une configuration qui sied à merveille à la RTX 4090.

Les valeurs en 1 080p et 1 440p n’ont pas grand intérêt, mais en 4K, la carte écrase la concurrence avec des performances en progrès d’environ 80 % sur les RTX 3080 Ti et RTX 3090. Ray tracing oblige, la Radeon RX 6900XT n’est pas à son aise et les progrès sont ici de 180 % en se tournant vers la carte Lovelace. Impressionnant.

Far Cry 6

Sur le jeu d’Ubisoft Montréal, la RTX 4090 est moins à son aise. D’emblée, on note qu’il n’est pas question de jouer en 1 080p ou en 1 440p sur une telle carte : elle ne fait pas réellement mieux que les RTX 3080 Ti / RTX 3090, elle est comme on dit dans le jargon CPU bound, limitée par le CPU.

En 4K, elle l’emporte sans difficulté sur toutes ses concurrentes, mais les écarts sont moins nets que sur Cyberpunk 2077. Par rapport à la RTX 3080 Ti, sa poursuivante la plus performante, la RTX 4090 assure des progrès d’exactement 40 % sur Far Cry 6 avec le ray tracing activé.

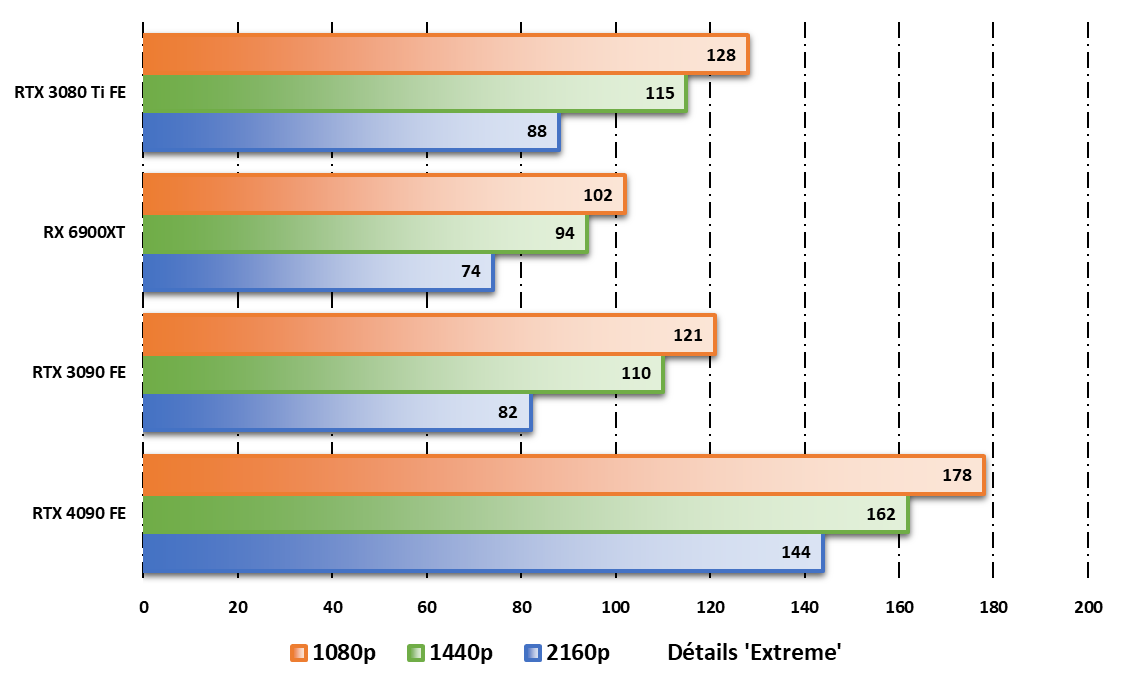

Forza Horizon 5

Sur notre nouveau protocole, la course automobile est représentée par le magnifique Forza Horizon 5 qui ne souffre que d’un défaut : la prise en charge du ray tracing se limite au seul garage. En jeu, les écarts sont malgré tout très importants et la dauphine de notre cobaye du jour est de nouveau la RTX 3080 Ti, laquelle ne peut toutefois rien faire et le gain est cette fois de presque 64 %.

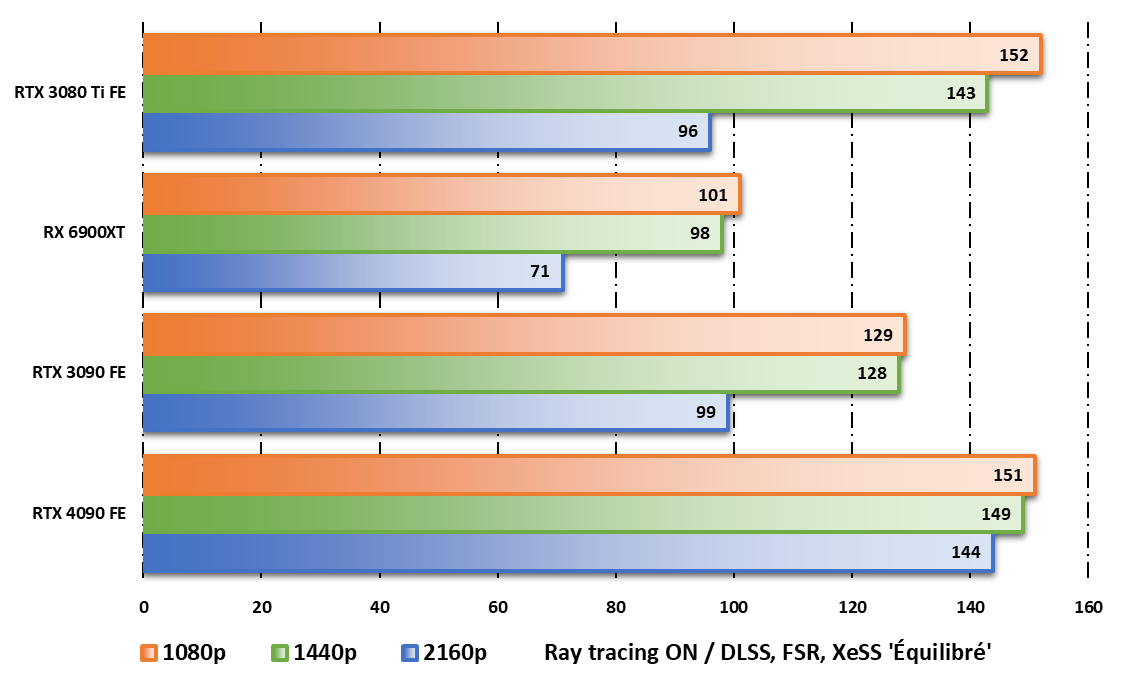

Marvel’s Guardians of the Galaxy

Encore un peu moins d’écarts avec Marvel’s Guardians of the Galaxy qui permet à la RTX 3090 de mieux figurer. Option ray tracing activée et super-échantillonnage sur équilibré, la carte Ampere signe 99 images par seconde : la RTX 4090 ne fait « que » 46 % de mieux pour atteindre un flatteur 144 ips.

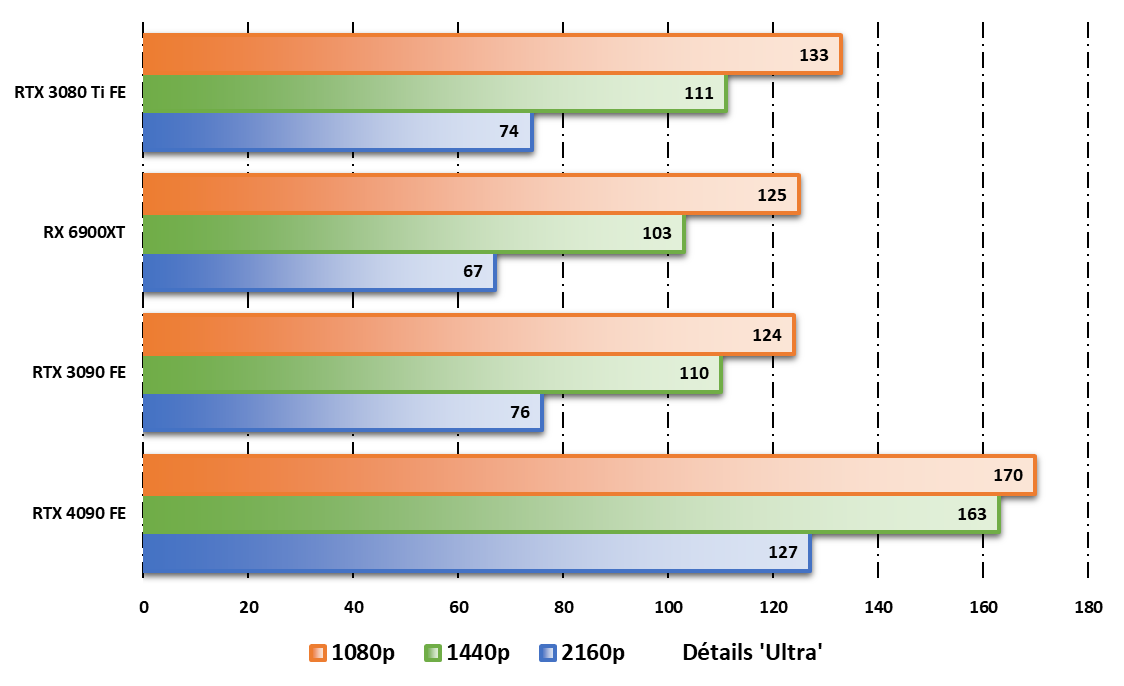

Red Dead Redemption 2

Les années passent et le jeu de Rockstar Games reste une merveille graphique qui nous permet, en plus, d’ajouter un jeu Vulkan à notre sélection. Une fois encore, nous nous focalisons sur le jeu en 4K avec les détails en ultra et, une fois encore, la RTX 4090 écrase la concurrence.

Par rapport à la Radeon RX 6900XT d’AMD (67 ips), la carte NVIDIA signe des performances 90 % plus élevées. Notre duo de RTX 3080 Ti/RTX 3090 fait un peu mieux bien sûr. Pourtant, la RTX 4090 fait encore 67 % de mieux pour assurer une moyenne de 127 images par seconde.

Total War Warhammer 3

Le dernier jeu de notre sélection n’est autre que le Total War Warhammer 3 de The Creative Assembly. Plusieurs scènes étant disponibles, nous avons retenu celle du champ de bataille, théâtre de nouveaux exploits pour la RTX 4090.

Notons qu’il s’agit du seul jeu de notre sélection où les cartes graphiques ne sont pas limitées par le processeur et, même en 1 080p, la hiérarchie s’installe aisément avec une RTX 4090 supérieure de 53 % à sa dauphine, la RTX 3080 Ti.

Logiquement, le classement reste le même en 4K avec une RTX 3090 en troisième position, une RTX 3080 TI sur la seconde marche du podium et une RTX 4090 qui caracole en tête assurant des performances 68 % supérieures à celles de sa poursuivante.

Coup de projecteur sur DLSS3 / Reflex

Soucieux de mettre en avant certaines de ses nouveautés technologiques, NVIDIA a conçu des outils qui, il faut le reconnaître, simplifient grandement notre travail de testeur.

- Grâce à FrameView, il est simple de mesurer la moyenne du nombre d’images par seconde, mais également des pires 1 % ou du temps de latence de la machine.

- De son côté, ICAT simplifie la juxtaposition de deux vidéos afin de comparer le niveau de détail ou, dans le cas présent, le résultat du traitement DLSS.

Notez bien que sur les graphiques ci-dessous, la notion de latence (exprimée en millisecondes, ms) doit être lue « à l'envers » : plus le score est faible, plus le PC est réactif et plus le jeu est agréable.

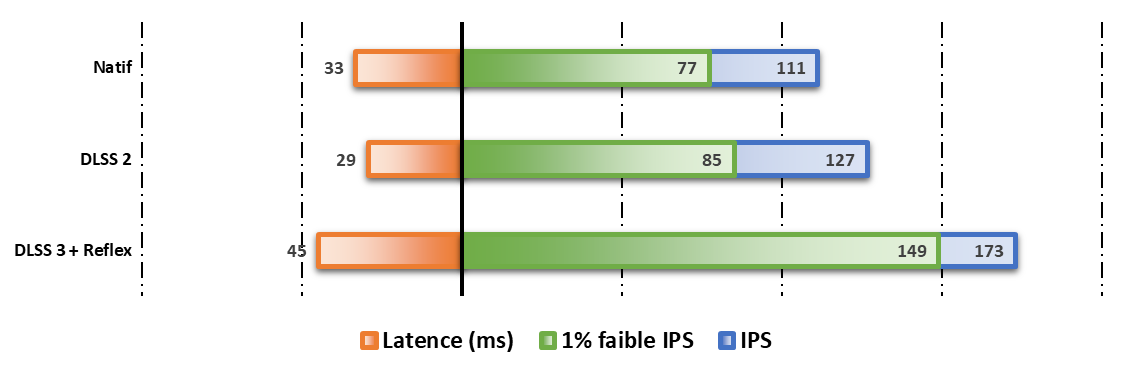

A Plague Tale: Requiem

Sur le jeu d’Asobo Studios, on note le boost de performances offert par l'activation du DLSS 3. Au-delà de la seule moyenne du nombre d’images par seconde, c’est d’ailleurs le 1 % faible qui impressionne.

Rappelons qu’il s’agit de nous dire que sur les 1 % du temps où la fluidité est la plus mauvaise, A Plague Tale: Requiem tourne encore à 149 images par seconde grâce au DLSS 3 alors qu’en DLSS 2, il faut se contenter de 85 ips, en 4K. Notons que DLSS 2 a toutefois pour lui une meilleure latence et que Reflex ne suffit pas à ramener le DLSS 3 au même niveau.

La chose est extrêmement subjective, mais afin que vous puissiez vous faire une petite idée du rendu proposé par DLSS 3, nous avons mis côte-à-côte, deux images du jeu d’abord à 100 % puis à 400 % : sur la gauche, vous avez le rendu en mode natif 4K et, à droite, la version DLSS 3 calée sur le réglage équilibré.

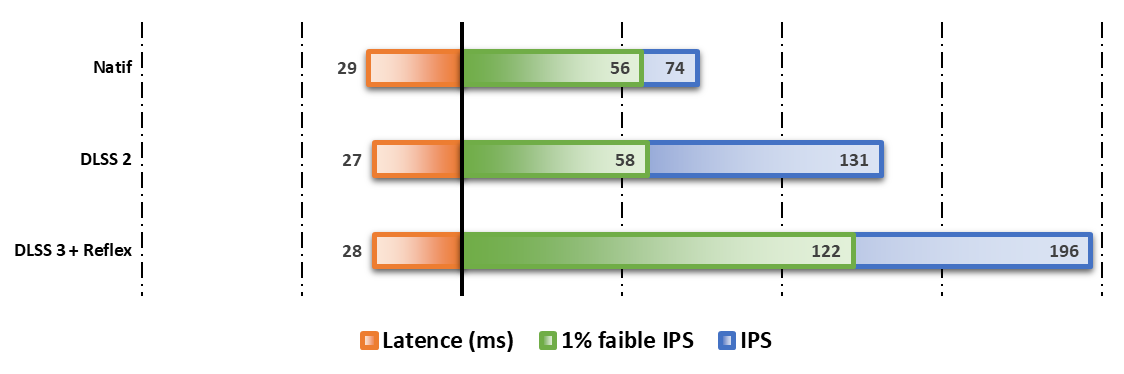

F1 22

Sans doute quelques optimisations sont encore à réaliser sur A Plague Tale: Requiem car F1 22 est plus en phase avec les ambitions de NVIDIA. D’abord, le DLSS 3 assure une fois encore une fluidité exemplaire même en 4K et même en considérant le 1 % faible.

Mais là où les choses deviennent très intéressantes c’est que ce gain de fluidité ne se fait pas au détriment de la réactivité. Le frame generator du DLSS 3 entraîne bien un accroissement de la latence, mais il est presque entièrement compensé par Reflex : on est à 28 ms quand on poussait à 27 ms sur DLSS 2, autant dire la même chose.

Comme pour A Plague : Requiem, nous vous offrons maintenant la possibilité de comparer le rendu visuel de DLSS 3 à la version 4K native d’abord en 100 % puis en 300 % : sur la droite, le super-échantillonnage de NVIDIA est à l’œuvre alors qu’à gauche, nous sommes en natif…

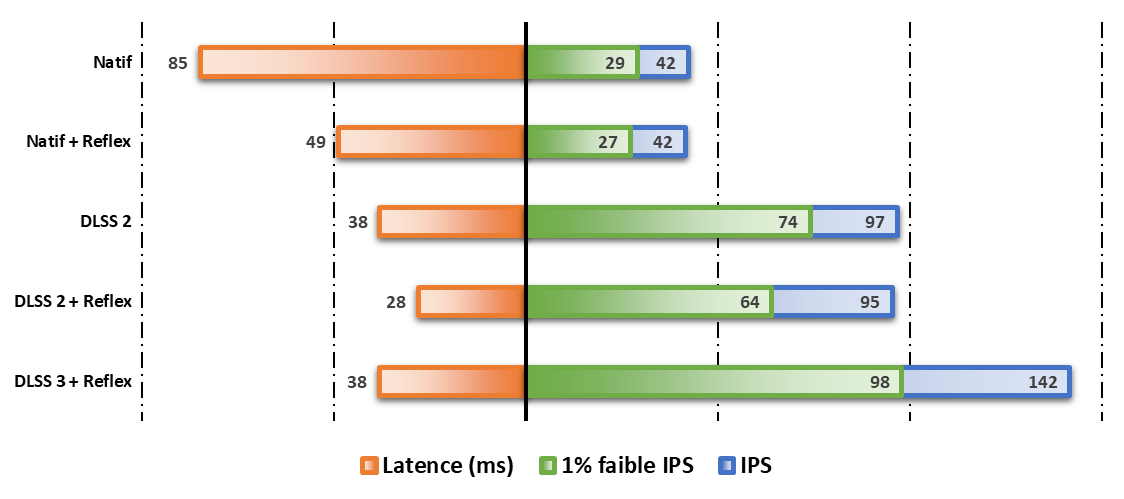

Cyberpunk 2077

Enfin, pour obtenir un tableau encore un peu plus complet de la situation, nous revenons vers l’inévitable Cyberpunk 2077. Comme les précédents titres, il est parmi les premiers à prendre en charge le DLSS 3, mais nous avons pu ici davantage jouer avec les réglages.

Sans surprise, le DLSS 3 permet d’atteindre les plus hauts niveaux de fluidité et, grâce à Reflex, il peut le faire sans ajouter de latence au réglage DLSS 2 seul. En revanche, Reflex peut aussi être activé sur DLSS 2 et l'on voit alors que la « vieille » solution l’emporte côté réactivité.

NVIDIA ne s’en cache pas : DLSS 3 n’a pas vocation à faire disparaître DLSS 2. Il s’agit d’une solution complémentaire qui arrive pour améliorer le rendu graphique. Dès lors que l’on parle de jeux ultra-compétitifs, la légère latence induite incitera les joueurs à garder DLSS 2.

Nous terminons par le face-à-face que vous avez déjà pu découvrir sur les deux précédents jeux. Cyberpunk 2077 en mode DLSS 3 est sur la droite alors que la version 4K native est sur la gauche. Nous vous proposons d’abord une image en 100 % puis en 200 %.

De l’efficacité d’Ada : à cheval sur la conso ?

Nous avons peu évoqué la chose, mais en optant pour le processus 4N (ou 5 nanomètres) de TSMC, NVIDIA insiste autant sur la densité de transistors que sur la remarquable efficacité énergétique. Sans trop entrer dans les détails, NVIDIA précise qu’il est peut délivrer « les plus hauts niveaux de performance par watt ». Voyons cela.

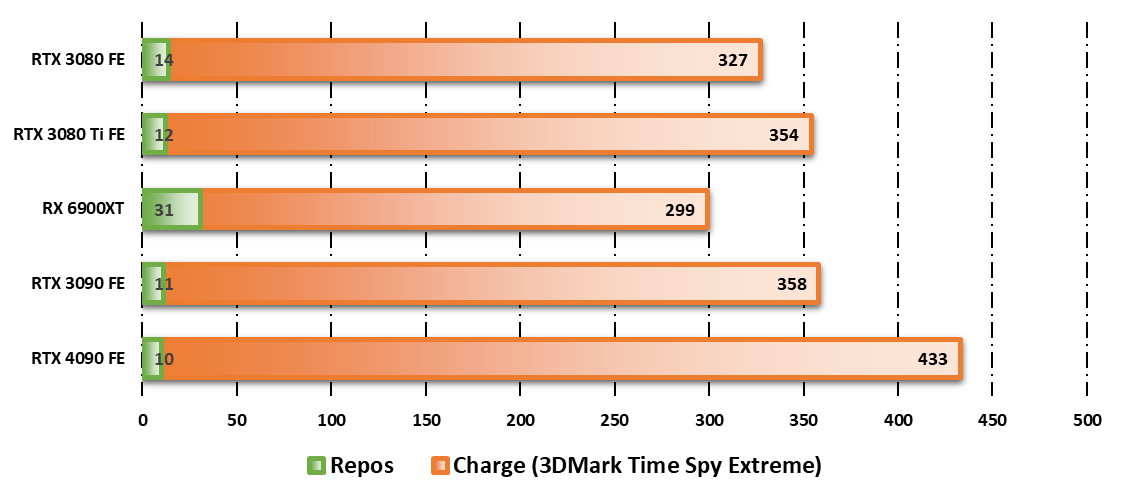

Consommation électrique

Sur le strict plan de la consommation électrique, le GPU AD102-300 de la RTX 4090 est évidemment gourmand : il s'agit d'une vitrine technologie pour NVIDIA et ses 433 watts enregistrés au plus fort d'une session de TimeSpy Extreme sur 3DMark n'ont rien d'anormal.

Tentons de rassurer les usagers : sur aucun jeu, sur aucune définition d'images et à aucun niveau de détail, nous n'avons atteint les 400 watts. Dans l'immense majorité des situations ou des logiciels, la moyenne haute s'établit plutôt autour des 370 watts. La RTX 4090 est gourmande, ce n'est pas une surprise. En revanche, cela dépend des usages et il convient tout de même d'insister sur le fait que le jeu vidéo n'est évidemment pas la vocation première d'une telle carte.

C’est aussi la plus puissante, donc – en dehors de toute considération écologique – cette poussée n’a rien de surprenant. Notons en revanche qu’au repos la carte est plus sobre et que, comme toutes les RTX 3000, elle a l’avantage de couper sa ventilation quand elle le peut.

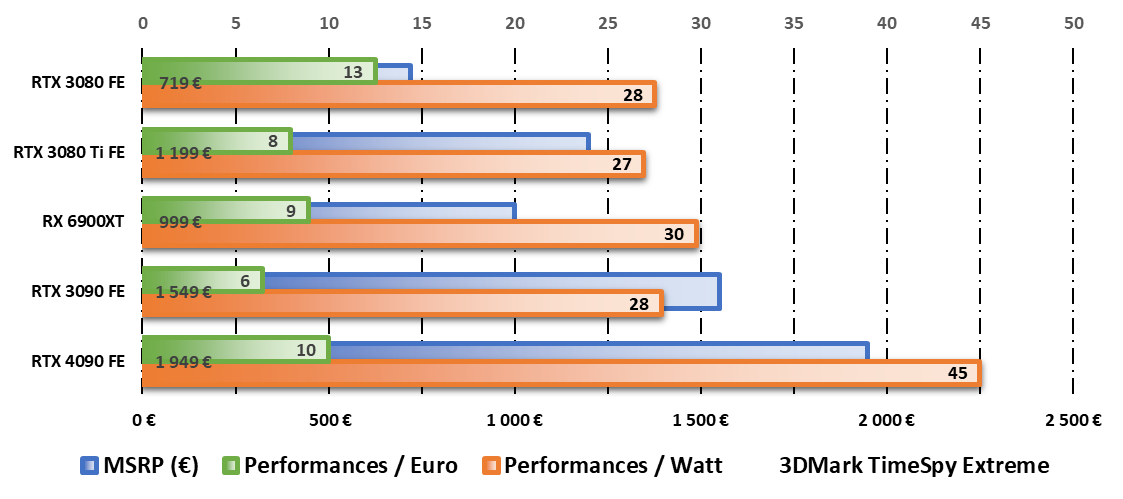

Efficacité et « rentabilité »

Exprimé en euros, le prix public conseillé (MSRP) est représenté sur le graphique ci-dessus par les barres bleues. La valeur chiffrée est précisée à côté de chaque carte.

Entre les sorties des RTX 3000 et 4000, le taux de change euro/dollar a fortement changé affaiblissant le ratio performances/prix de la RTX 4090. En dollars, ce ratio est à 12,2 contre 12,9 pour la RTX 3080.

Au-delà de sa consommation, il nous semblait utile d’évoquer deux indicateurs de l’efficacité de la carte : les performances par Watt et les performances par Euro en prenant à chaque fois le résultat 3DMark TimeSpy Extreme. D’abord en le divisant par la consommation enregistrée et, ensuite, en le divisant par le MSRP au lancement de la carte.

Sur le plan énergétique, il est réconfortant de voir que NVIDIA ne pense pas qu’aux performances : sa RTX 4090 est loin devant les autres cartes graphiques haut de gamme testées sur Clubic et nous sommes impatients d'observer ce que cela peut donner sur des modèles plus modestes.

Du côté des performances par Euro, la RTX 4090 est moins à son aise et se fait damer le pion par la RTX 3080 confirmant l’exceptionnel rapport qualité/prix de la pionnière de la gamme Ampere. Handicapé par la conversion Euro/Dollar défavorable, Lovelace n’a toutefois pas à rougir et, là encore, nous attendons la suite.

NVIDIA GeForce RTX 4090 FE, l’avis de Clubic

Lire la charte de confiance