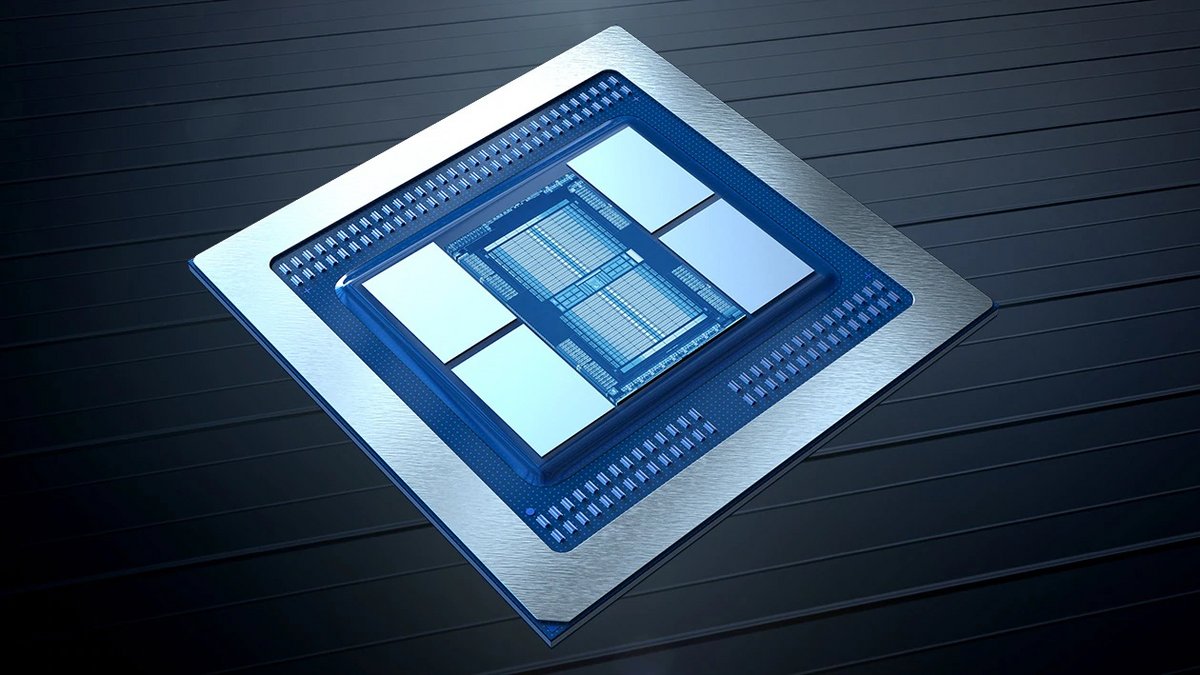

Le coréen SK Hynix a annoncé sa nouvelle génération de mémoire vive HBM3. Étudiés pour délivrer des vitesses de transferts toujours plus élevées, tout en profitant d'une efficacité énergétique sérieusement peaufinée, ces modules serviront notamment de mémoire vidéo pour de futures cartes graphiques hautes performances.

Prendre la relève de l’actuelle mémoire HBM2E en améliorant à peu près tout. C'est la raison de vivre de la mémoire HBM3 que SK Hynix a présenté.

Speeeeeed and power

Cette nouvelle génération de modules DRAM promet des vitesses de transfert ébouriffantes, pouvant monter à 5,2 Gbps en entrée et sortie. Soit une hausse de 44 % par rapport à la mémoire HBM2E. Même dynamique pour la bande passante qui pourra monter à un maximum de 665 Go/s de données transférées contre 460 Go/s actuellement. Là aussi nous sommes face à 44 % d'amélioration note WCCFTech, qui nous propose une mise à l'échelle intéressante.

En faisant le calcul, un seul module HBM3 devrait pouvoir offrir plus de bande passante que celle proposée au total par les Radeon RX 6900XT et GeForce RTX 3070 Ti réunies. Quatre modules de cette nouvelle DRAM suffiront aussi à développer 2 To/s de bande passante tandis que les six modules de VRAM de la NVIDIA A100 (vouée aux supercalculateurs) se limitent à 3 To/s.

Lancement prévu l'année prochaine

Mais la vitesse ne fait pas tout et SK Hynx le sait. La marque promet donc une amélioration des technologies de dissipation introduites avec sa mémoire HBM2E. Résultat : 14 degrés en moins sur les modules et une dissipation de chaleur améliorée de 36%, promet le groupe sud-coréen.

La capacité maximale de ces nouveaux modules de DRAM ne devrait, par contre, pas évoluer beaucoup par rapport à la mémoire HBM2E — en tout cas pour la première génération attendue l'année prochaine. Dans un premier temps, on y retrouvera donc des dies de 16 Gb pour une capacité de 16 Go. Il est en revanche possible que la densité des modules augmente lorsque les spécifications de la HBM3 seront finalisées par le JEDEC (Joint Electron Device Engineering Council). Il n'est donc pas exclu que cette capacité soit revue à la hausse à moyen terme.

Quant aux premières cartes graphiques éligibles à cette nouvelle mémoire DRAM HBM3 ? Il faut aller chercher du côté des futurs GPU pour serveurs et supercalculateurs de chez AMD, NVIDIA et Intel. WCCFTech cite notamment les designs AMD Instinct, NVIDIA Hopper et Intel Xe-HPC, qui seront parmi les premiers servis.

Source : WCCFTech