Ne nous leurrons pas, ATI et NVIDIA ne sont pas des œuvres caritatives et leur but n'est pas de proposer les cartes les plus performantes au prix le plus bas. Non, leur véritable but est bel et bien dicté par les constructeurs, comme nous le soulignions plus haut, qui en allouant un budget strict pour la partie graphique d'un PC obligent les deux géants de la 3D à trouver un compromis pas toujours heureux entre performances, coût de revient et marge. À l'arrivée du PCI-Express, le retard accumulé par NVIDIA sur la mise au point de son fameux bridge HSI et le surcoût qu'il occasionnait ont ainsi fait pencher la balance en faveur d'ATI qui a pu équiper en X300 des quantités phénoménales de PC Dell... Alors que le PCI-Express est aujourd'hui clairement en phase d'expansion, les ingénieurs d'ATI et de NVIDIA lui ont récemment découvert une nouvelle utilité pour faire baisser encore le prix de leurs puces graphiques. À les écouter, la mémoire représenterait une part trop importante du budget consacré à des puces graphiques commercialisées autour des 20 dollars, d'où l'idée de la supprimer au moins en partie. C'est ce principe qui a donné naissance au TurboCache de NVIDIA et à l'HyperMemory d'ATI que nous confrontons aujourd'hui.

ATI Radeon X300 SE HyperMemory

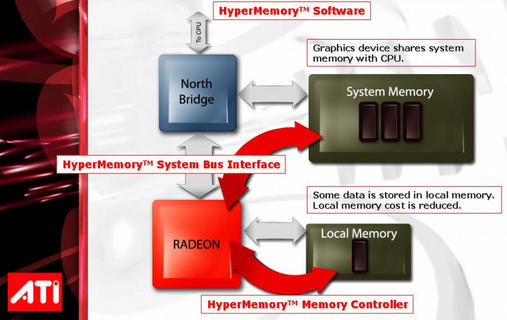

ATI reste assez peu disert sur le mode opératoire de l'HyperMemory. Tout au plus sait-on que cette technologie s'avère être une combinaison matérielle et logicielle, le canadien ayant apporté quelques changements à sa puce et à ses Drivers, pour l'implémenter. Par rapport à une carte graphique conventionnelle, la puce Radeon X300 SE munie de l'HyperMemory peut stocker en parallèle des données dans le petit espace de mémoire qui l'accompagne, mais aussi dans la mémoire système. Les requêtes sont ici priorisées et la technologie HyperMemory est censée répartir au mieux le stockage des données entre mémoire système et mémoire embarquée. ATI indique par ailleurs que la bande passante maximale de son contrôleur mémoire HyperMemory atteint les 12,8 Go/s. La mémoire locale, qui équipe le Radeon X300 SE HyperMemory, s'avère être interfacée sur 64 bits et sa quantité s'élève à 32 Mo. Dans cette configuration, ATI peut puiser jusqu'à 96 Mo de mémoire afin d'offrir un frame buffer de 128 Mo. L'utilisation de la mémoire système se fait de manière dynamique et les pilotes CATALYST se chargent de libérer l'espace dévolu au stockage des textures dès que l'application 3D n'en a plus besoin. Ainsi, à l'inverse de chipsets comme le i915G, la mémoire système reste pleinement disponible lorsque vous utilisez des applications bureautiques. Enfin et contrairement à la technologie TurboCache de NVIDIA, HyperMemory ne semble pas capable d'effectuer un rendu vers la mémoire système.

Diagramme technologie ATI HyperMemory

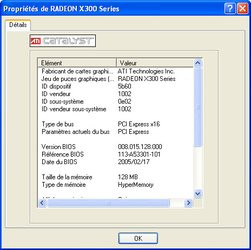

Connu sous le nom de code RV370 SE, le Radeon X300 SE HyperMemory est décliné en deux versions distinctes où seule la quantité de mémoire embarquée varie. Le Radeon X300 SE 128MB HyperMemory en dispose de 32 Mo alors que son grand frère, le Radeon X300 256MB HyperMemory, profite d'une quantité double avec 64 Mo (toujours interfacée en 64 bits). Gravée en 0,11 µ, le Radeon X300 SE est une puce de classe DirectX 9 qui dispose de quatre pixels pipelines et de deux vertex engines. Du côté des fréquences de fonctionnement, le VPU opère ici à 325 MHz alors que les 32 Mo de mémoire au format BGA tournent à 300 MHz.

Propriétés drivers du Radeon X300 SE HyperMemory (32/128)

La carte Radeon X300 SE HyperMemory 128 MB

Pour ce test, ATI nous a fait parvenir un design de référence de son Radeon X300 SE HyperMemory 128 MB. La carte au PCB rouge est dite « low profile » (rapport à sa taille) et embarque un système de refroidissement passif donc totalement silencieux. Interfacé en PCI-Express 16x, le VPU est ici accompagné de 32 Mo de mémoire DDR sous la forme de deux puces BGA signées Samsung dont le temps d'accès est de 3,3ns. La connectique offerte par la carte est on ne peut plus réduite avec simplement un connecteur VGA DB15 et une sortie vidéo... Exit donc le DVI.

Carte ATI Radeon X300 SE HyperMemory 32/128

La technologie TurboCache de NVIDIA

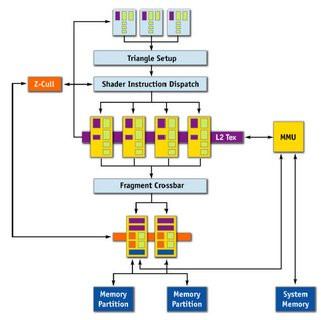

Architecture du pipeline du GeForce 6200 TurboCache

TurboCache, tout comme HyperMemory, ne rime pas (encore) avec une disparition totale de la mémoire vidéo embarquée. Ainsi, les GeForce 6200 TurboCache disposent toutes d'une petite quantité de mémoire qui permet à la carte d'offrir selon s'il s'agit d'un interfaçage 32 ou 64 bits, une bande passante de 10,8 Go/s ou 13,6 Go/s. La technologie TurboCache permet au système d'exploiter en parallèle la mémoire du système et celle de la carte graphique afin de mutualiser les ressources et d'accroître les performances. Pour les cartes équipées de 16 ou 32 Mo de mémoire embarquée, TurboCache simule une quantité de mémoire vidéo de 128 Mo et il faut un modèle muni de 64 Mo de mémoire embarquée pour recréer 256 Mo.

GeForce 6200 TurboCache : Gare aux gorilles !

Le NV44, qui a donné naissance au GeForce 6200 TurboCache, est une puce DirectX 9.0 gravée en 0,11 µ. Comportant quelques 80 millions de transistors, elle dispose de quatre pixels pipelines et de deux vertex engines, tout comme le Radeon X300 SE HyperMemory. NVIDIA précise que comme les GeForce 6800 et 6600, sa puce gère le Shader Model 3.0 ce qui est vrai dans l'absolu, mais totalement inexploitable en pratique vu la faible puissance du GeForce 6200. Du côté des fréquences de fonctionnement, le processeur opère à 350 MHz alors que la mémoire DDR est la véritable arlésienne...En effet on distingue trois types de cartes : la GeForce 6200 TurboCache 16/128 dont la mémoire interfacée en 32 bits opère à 350 MHz, la GeForce 6200 TurboCache 32/128 dont la mémoire est théoriquement interfacée en 64 bits et fonctionne à 350 MHz et enfin la GeForce 6200 TurboCache 64/256 qui a recours à de la mémoire TSOP cadencée à 275 MHz ! Voilà, si vous pensiez que tout était aussi « simple », vous vous trompez cependant très lourdement puisque certains constructeurs comme eVGA et Chaintech proposent des GeForce 6200 TurboCache 32/128 dont la mémoire reste en 32 bits et est cadencée à 275 MHz d'où des performances largement inférieures à celles que l'on est en droit d'attendre du produit...

| Radeon X300 SE | Radeon X300 SE HM | GeForce 6200 AGP | GeForce 6200 TC 16/128 | GeForce 6200 TC 32/128 | GeForce 6200 TC 64/256 | GeForce 6200 | |

| Interface | PCI-Express 16x | PCI-Express 16x | AGP 8x | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x | PCI-Express 16x |

| Gravure | 0,11µ | 0,11µ | 0,11µ | 0,11µ | 0,11µ | 0,11µ | 0,11µ |

| Transistors | 75 Millions | 75 Millions | 75 Millions | 75 Millions | 75 Millions | 75 Millions | 75 Millions |

| T&L | DirectX 9.0 | DirectX 9.0 | DirectX 9.0c | DirectX 9.0c | DirectX 9.0c | DirectX 9.0c | DirectX 9.0c |

| Pixel pipelines | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| Vertex engines | 2 | 2 | 3 | 3 | 3 | 3 | 3 |

| Mémoire réelle | 128 Mo | 32 Mo | 128 Mo | 16 Mo | 32 Mo | 64 Mo | 128 Mo |

| Mémoire émulée | - | 128 Mo | - | 128 Mo | 128 Mo | 256 Mo | - |

| Interface mémoire | 64 bit | 64 bit | 64 bit | 32 bit | 64 bit | 64 bit | 128 bit |

| Fréquence mémoire | 200 MHz | 300 MHz | 250 MHz | 350 MHz | 350 MHz | 275 MHz | 275 MHz |

| Fréquence GPU | 325 MHz | 325 MHz | 350 MHz | 350 MHz | 350 MHz | 350 MHz | 300 MHz |

Une nouvelle variante du GeForce 6200 : le NV44A pour AGP

Alors que TurboCache est une technologie exclusivement dédiée au bus PCI-Express, NVIDIA vient tout juste de lancer une version AGP de sa puce graphique d'entrée de gamme avec le GeForce 6200 AGP. Il s'agit pour la société de ne pas laisser de côté le marché AGP encore florissant et de proposer aux détenteurs de telles machines une solution de mise à jour à moindre coût. Contrairement au NV43V, le NV44A dispose d'une interface AGP native et ne nécessite aucun bridge. Le GeForce 6200 AGP que nous avons reçu est ici signé PNY et il s'agit d'une carte disposant de sa propre mémoire vidéo embarquée, à hauteur de 128 Mo, TurboCache ne pouvant techniquement pas fonctionner sur une carte interfacée en AGP. Ici le processeur opère à 350 MHz et sa mémoire tourne à 250 MHz. PNY a sélectionné quatre puces de mémoire DDR TSOP signées Infineon. Courte et arborant un PCB bleu, la carte adopte un système de refroidissement passif, donc totalement silencieux, et offre un connecteur DVI, un port VGA DB15 ainsi qu'une sortie S-Vidéo.

Le GeForce 6200 AGP de PNY

Impact de la configuration mémoire sur les performances graphiques

Durant ce test nous avons cherché à savoir quel pouvait être l'impact de la configuration mémoire du système sur les performances graphiques. Alors que tous les tests de performance que vous pourrez consulter plus loin ont été effectués avec 512 Mo de mémoire (2x256 Mo) nous avons voulu étudier le comportement des X300 SE HyperMemory et 6200 TurboCache avec seulement 256 Mo de mémoire (une seule barrette mémoire sur un seul canal) mais aussi avec 512 Mo de mémoire répartis sur une seule barrette. Voici le fruit de nos observations :3DMark 2005

Doom 3

Half-Life 2

Unreal Tournament 2003

Les résultats obtenus sont plutôt intéressants et montrent qu'en fonction du jeu c'est plus la quantité totale de mémoire qui compte que son interface (double canal ou non). Ainsi, avec le Radeon X300 SE HyperMemory et certains jeux bien précis (Doom 3 et Unreal Tournament 2003), les résultats restent quasiment inchangés entre une configuration 512 Mo simple barrette et son équivalent double canal. À l'inverse face à la configuration munie de seulement 256 Mo de mémoire, le passage à 512 Mo permet de voir une hausse jusqu'à 25 % des performances selon les résolutions et les applications. Si Half-Life 2, 3D Mark 2005 et Doom 3 profitent de l'augmentation de la quantité mémoire, Unreal Tournament 2003 n'en a vraisemblablement que faire... Chez NVIDIA la technologie TurboCache qui équipe le GeForce 6200 du même nom affiche un comportement semblable.

Au-delà de la simple 3D...

Au-delà du framerate à tout prix, les cartes qui nous préoccupent aujourd'hui proposent toutes des fonctions d'accélération vidéo. C'est ainsi que le Radeon X300 SE dispose d'un moteur vidéo censé décharger le processeur central lors des décodages de flux MPEG 2, DivX et WMV9. Si le décodage MPEG2 est 100 % matériel, il n'en va pas de même pour le fameux format WMV9. Ici ATI et NVIDIA se contentent de proposer quelques optimisations. Nous avons voulu vérifier lors de nos tests l'efficacité des différents moteurs de décompression ce qui nous a valu quelques surprises. Nous nous sommes tout d'abord penchés sur le MPEG 2 avec notre DVD de référence, Danse Avec Les Loups, et le décodeur PowerDVD 6.0 de Cyberlink. Ici, le Radeon X300 SE HyperMemory fait des merveilles et l'occupation CPU ne dépasse pas les 5 %. À l'inverse chez NVIDIA, le GeForce 6200 TurboCache 128Mo monopolise près de 12 % du CPU. En installant le décodeur vidéo conseillé et commercialisé par NVIDIA, le fameux PureVideo, l'occupation CPU grimpe encore et oscille entre 13 et 21 %. Voilà qui n'est pas très brillant même si NVIDIA mettra en avant quelques-uns de ses filtres qui sont censés améliorer la qualité visuelle. En pratique et dans des cas bien précis, les filtres NVIDIA ont une certaine efficacité. Il faut hélas faire une pause sur l'image pour réellement se rendre compte du changement obtenu : en lecture avec un débit de 25 images par seconde l'effet des filtres est imperceptible. D'autant que ceux-ci ne fonctionnent qu'avec les fichiers MPEG2 et WMV9 : inutile donc d'attendre un quelconque changement dans le rendu de vos DivX préférés, alors même qu'ATI propose des fonctions de deblocking pour le DivX notamment...Au sujet du décodage des fichiers WMV9, ATI fait là encore mieux que NVIDIA même si l'avantage du Canadien est dans ce domaine un peu plus modeste. On notera tout d'abord que le moteur PureVideo est tout simplement inefficace avec la dernière version du Windows Media Player 10 (3802) et aucune optimisation spécifique NVIDIA ne vient en aide au processeur central de notre système. Du coup et alors que le X300 SE HyperMemory monopolisera un maximum de 32 % des ressources CPU, le GeForce 6200 TurboCache 32/128 se montre plus gourmand et accapare jusqu'à 38 % des ressources Processeurs. « Pas glop » pour NVIDIA dont le PureVideo semble toujours être bien davantage un argument marketing qu'une véritable fonctionnalité... Interrogé à ce sujet, NVIDIA nous indique être au courant de la situation et travailler avec Microsoft à l'activation des fonctions de décodage dans le Windows Media Player 10 par l'intermédiaire d'un prochain patch.

- Carte mère Asus A8N SLI Deluxe (BIOS 1006),

- AMD Athlon 64 3200+ (939),

- 2x256 Mo Kingston,

- Disque dur Western Digital Raptor 36 Go

- Carte mère Epox EP-9NDA3+ (nForce 3 Ultra),

- AMD Athlon 64 3200+ (939),

- 2x256 Mo Kingston,

- Disque dur Western Digital Raptor 36 Go

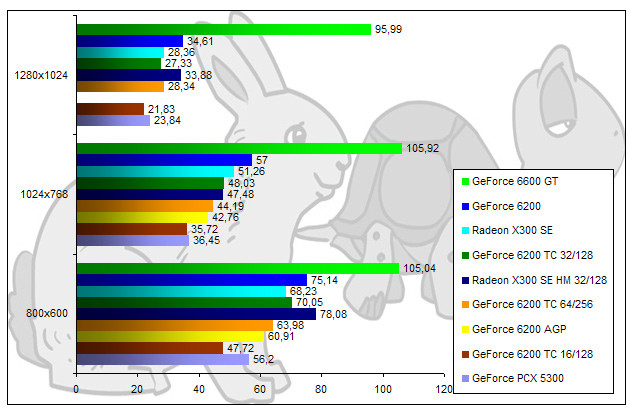

3DMark 2005

Commençons par 3DMark 2005. Ici, le GeForce PCV 5300 est tout simplement largué et le GeForce 6200 AGP s'avère deux fois plus rapide. De son côté, le Radeon X300 SE HyperMemory fait un peu moins bien que le Radeon X300 SE alors que les GeForce 6200 TurboCache sont en tête. Un bémol toutefois pour la version 16/128 qui est aussi rapide (ou lente à vous de voir) que le Radeon X300 SE. On constate sans grande surprise que les performances du GeForce 6200 64/256 sont très similaires à celles du GeForce 32/128 ce qui s'explique par sa fréquence mémoire inférieure. Enfin, le GeForce 6200 PCI-Express domine la mêlée alors que le GeForce 6600 GT fait bien sûr figure d'OVNI.

AquaMark 3

AquaMark montre bien les faiblesses du GeForce PCX 5300 qui s'adjuge ici le bonnet d'âne. Le Radeon X300 SE se montre quasiment deux fois plus rapide que l'ancienne référence entrée de gamme de NVIDIA, mais est devancé par les GeForce 6200 TurboCache ainsi que par le Radeon X300 SE HyperMemory. Ici, ce dernier est jusqu'à 22 % plus rapide. Dans la hiérarchie des GeForce 6200 TurboCache, le modèle 16 Mo est toujours aussi peu séduisant, ses performances égalant celles d'un Radeon X300SE alors que la version 32 Mo est plus rapide que la 64 Mo : logique vu que sur cette dernière la mémoire embarquée est plus lente.

Doom 3

Enchaînons avec Doom 3 qui ne met met curieusement pas la claque qu'on aurait pu attendre aux X300. En effet, on constate que les performances des GeForce PCX 5300, GeForce 6200 TurboCache 16/128, Radeon X300 SE et GeForce 6200 AGP sont ici identiques. La version HyperMemory du X300 SE s'octroie même un petit avantage sur le X300 SE standard. Avantage somme toute logique du fait de ses fréquences supérieures. Enfin, si les GeForce 6200 TC 32/128 et 64/256 dominent, ils sont loin d'offrir une expérience de jeu fluide...

Far Cry v1.3

Far Cry nous apprend que le GeForce 6200 AGP est un peu plus véloce que la version PCX 5300, mais hélas affiche dans le même temps des performances largement inférieures aux GeForce 6200 TurboCache. Le GeForce 6200 32/128 est ici tout simplement deux fois plus véloce ! Les Radeon X300 SE sont dans tous les cas plus rapides que la version du GeForce 6200 TurboCache munie de 16 Mo et, une fois de plus, le modèle 64 Mo n'apporte rien face à la carte équipée de 32 Mo... On notera enfin que le GeForce 6200 PCI-Express est le seul à offrir une expérience de jeu convenable grâce à son interface mémoire 128 bits.

Unreal Tournament 2003

Unreal Tournament montre que les cartes graphiques d'entrée de gamme d'aujourd'hui sont capables de faire fonctionner dans de bonnes conditions des jeux plus anciens. Là encore, le Radeon X300 SE est à égalité avec le GeForce 6200 TurboCache 16/128, alors que le GeForce 6200 AGP déçoit une fois de plus en étant plus lent que le GeForce 6200 TurboCache 32/128. Comme d'habitude, la version 64 Mo est plus lente que le modèle 32 Mo et le Radeon X300 SE HyperMemory est ici 34 % plus rapide que le Radeon X300 SE standard. On notera enfin que le GeForce 6200 TurboCache affiche ici, et c'est bien la première fois, des performances similaires au GeForce 6200 que nous qualifierons de standard.

Half-Life 2

Terminons par Half-Life 2 et notez tout de suite que le GeForce PCX 5300 fonctionne ici en mode de rendu DirectX 8.1 alors que toutes les autres cartes sont en DirectX 9.0. Ceci explique évidemment ses performances supérieures au GeForce 6200 16/128. Ce dernier est d'ailleurs bon dernier, le modèle 32 Mo étant jusqu'à 35% plus véloce. Une fois encore, le modèle muni de 64 Mo de mémoire n'apporte rien en terme de performances sauf en 1280x1024 où il devance la version 32 Mo. Du côté des Radeon X300, le modèle SE affiche de très bonnes performances et si en 1280x1024 il est devancé par son compère HyperMemory, la donne est inversée dans les résolutions inférieures. Un mot sur le GeForce 6200 AGP qui à cause d'un bug ne fonctionne pas en 1280x1024 et dont les performances sont une fois de plus décevantes, jugez plutôt : il est 12 % plus lent que le GeForce 6200 32/128.

Conclusion

Il y a quelques mois, lors de notre test du GeForce 6200 TurboCache nous n'avions pas mâché nos mots envers NVIDIA que nous accusions pêle-mêle de se contenter du minimum syndical pour tirer le marché vers le bas avec une solution qui ne semblait au final vouée qu'à un seul but, celui d'augmenter les marges de la firme au caméléon. Aujourd'hui si la version 16 Mo du GeForce 6200 TurboCache est tout simplement à bannir et si nous ne pouvons toujours pas vous recommander chaudement le GeForce 6200 TurboCache, le jugement que nous avions pu formuler semble, avec le recul, un brin sévère... Force est de reconnaître en effet que la solution de NVIDIA, dans sa version 32 Mo en 64 bits, offre de meilleures performances que le Radeon X300 SE HyperMemory d'ATI. NVIDIA l'emporte donc sans trop se forcer sur son rival canadien sur le terrain des performances, mais pour autant le vrai problème demeure. Ce type de carte ne permet pas véritablement de jouer sauf à faire de lourdes concessions notamment au niveau de la résolution... et jouer en 800x600 avec un LCD, ne constitue pas vraiment une expérience mémorable.Alors que dire du Radeon X300 SE HyperMemory ou même du GeForce 6200 TurboCache ? Clairement, ces deux produits sont loin d'être enthousiasmants, pourtant ils répondent à une demande du marché. Si l'on ne peut que regretter la tendance qui fait que les constructeurs considèrent le système graphique d'une machine comme une simple variable d'ajustement de son prix nous n'avons pas les moyens de nous y opposer. De plus, il faut admettre que pour un budget serré les deux cartes permettent tout de même de jouer, modestement certes, mais incontestablement dans de meilleures conditions qu'avec un i915G. D'un strict point de vue financier, le Radeon X300 SE HyperMemory 128 Mo l'emporte sur le GeForce 6200 TurboCache 32 Mo supportant 128 Mo, même si la puce de NVIDIA est sans doute la plus rapide.

Dans tous les cas ce genre de chips semble se destiner avant tout aux configurations d'entrée de gamme ou de type MediaCenter (DivX box, etc.) plus qu'à satisfaire les besoins des joueurs, même occasionnels. NVIDIA a d'ailleurs un avantage supplémentaire sur ATI dans le domaine du multi-écrans, ses GeForce 6200 TurboCache embarquant une double sortie DVI/VGA.

L'une des cartes de cet article vous intéresse ? Retrouvez la dans le comparateur de prix de Clubic.com