La nouvelle génération de cartes graphiques NVIDIA n'est toutefois pas attendue avant, au mieux, septembre 2022.

Souvenez-vous, il y a quelques semaines, NVIDIA était victime d'une attaque ayant permis le vol de nombreuses données. Aujourd'hui, ces données remontent à la surface, au grand dam du fabricant.

96 Mo de cache L2 sur le GPU AD102 ?

En effet, et même s'il convient de prendre le recul nécessaire face à toutes ces « informations », le vol de données organisé par le groupe Lapsus$ permet aujourd'hui de décrypter de multiples informations liées à la future gamme de cartes graphiques de NVIDIA, les fameuses Lovelace.

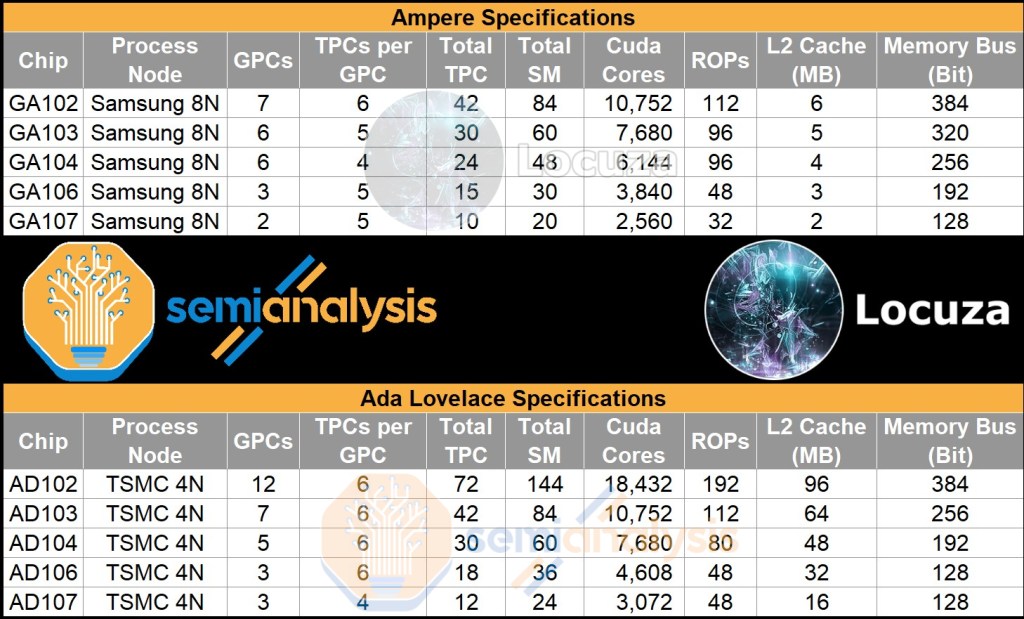

Les cinq références supposées de cette nouvelle gamme sont à mettre en face des cinq références de la gamme Ampere. D'emblée, c'est bien sûr le processus de fabrication qui distingue les deux générations : du Samsung 8N sur Ampere et du TSMC 4N pour la future Lovelace.

Au-delà de ça, on note surtout une très large augmentation de la quantité de cache L2 embarqué : on passe de 6 Mo à 96 Mo sur les modèles les plus musclés… comme pour contrer l'Infinity Cache d'AMD. Le nombre de cœurs Cuda augmente aussi nettement et il en va en réalité de même pour tous les compartiments du GPU.

Il y a toutefois une exception notable, dans la mesure où NVIDIA semble reconduire les mêmes bus d'interface mémoire d'une génération à l'autre. Le 128-bit des modèles d'entrée de gamme aura encore un peu plus de difficulté à nous convaincre.

Source : Semi Analysis