Le GPU H100 de NVIDIA n'aura pas tardé à se dévoiler plus en détails et, surtout, de manière officielle.

Pas plus tard que ce matin, nous évoquions une ultime fuite concernant Hopper, la nouvelle génération de GPU imaginée par NVIDIA pour équiper les centres de données.

L'ouverture de la GTC 2022 et la keynote présentée par Jensen Huang, fondateur et P.-D.G. de NVIDIA, aura été l'occasion de clarifier les choses.

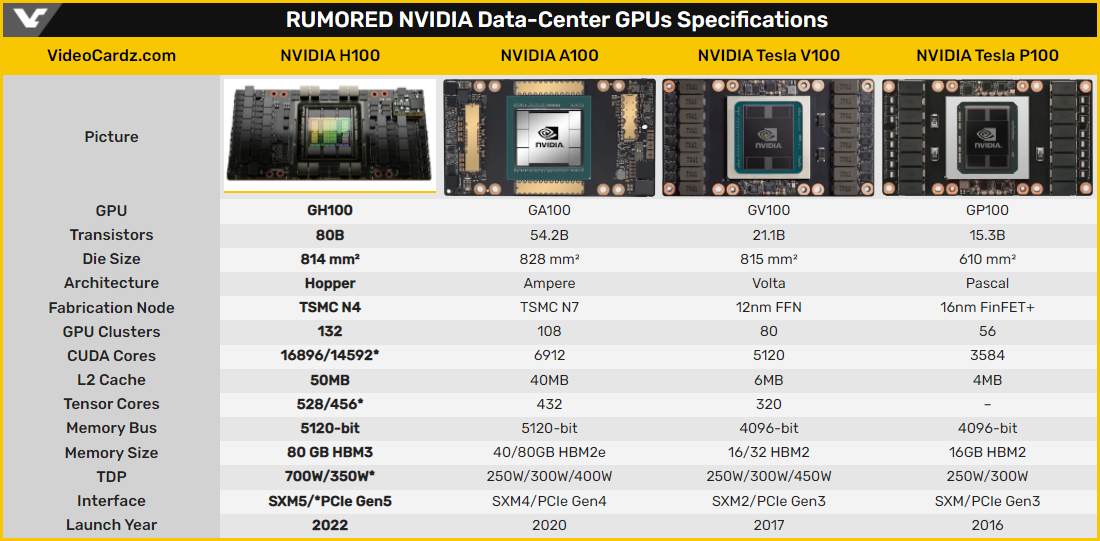

TSMC N4 pour 80 milliards de transistors

Contrairement à ce que les rumeurs annonçaient ce nouveau GPU n'est pas doté de 140 milliards de transistors, en tout cas pas pour cette puce H100 de la génération Hopper. NVIDIA a effectivement indiqué qu'il est question de « seulement » 80 milliards de transistors.

L'Américain a en revanche souligné l'utilisation d'un processus de gravure très avancé puisqu'il est question du N4 de TSMC. Autre grande nouvelle, NVIDIA emploie sur cette génération de la mémoire HBM3 : pas moins de 80 Go pour être tout à fait exact.

Deux versions du H100 ayant été évoquées par NVIDIA, les spécifications varient. Ainsi, le H100 SXM affiche une puissance FP64 de 30 teraFLOPS quand le H100 PCIe doit se « contenter » de 24 teraFLOPS. De fait, le TDP du premier est à 700 W contre 350 W pour le second.

Enfin, histoire de parfaire le tableau, NVIDIA a parlé de l'intégration de plusieurs GPU H100 au sein du système HGX H100 : il intègre huit GPU qui communiquent via des NVLink de quatrième génération pour un maximum de puissance.

Dans le parcours d'un joueur ou d'un créateur, le choix d'une carte graphique n'est pas de ceux qu'il faut prendre à la légère. C'est pourquoi nous avons testé pour vous les différents modèles disponibles et retenus la crème de la crème.

Lire la suite

Source : NVIDIA