La prochaine génération de cartes graphiques NVIDIA devrait passer sur un nouveau processus de gravure… entre autres changements.

Sauf accident majeur, le futur des cartes graphiques NVIDIA s'écrira tout au long de l'année 2024 avec les sorties des modèles GeForce RTX série 40 SUPER et il faudra attendre 2025 pour une vraie nouvelle génération.

En effet, la série 50 également connue sous le nom de code Blackwell n'est pas attendue avant au moins dix-huit mois, mais cela ne doit pas empêcher la collecte des premières informations.

Gravure TSMC 3N

En septembre dernier, le magazine DigiTimes expliquait ainsi que NVIDIA avait négocié un contrat de fabrication avec TSMC. La société taïwanaise aura donc à sa charge la production des puces NVIDIA de prochaine génération comme elle le fait déjà avec les composants AMD.

Plus intéressant, DigiTimes expliquait que NVIDIA pourrait compter – en 2025 – sur le meilleur de la technologie TSMC, à savoir le processus de gravure baptisé 3N pour indiquer une finesse de 3 nm. Il s'agit actuellement du nœud de production le plus évolué de TSMC, celui qui est déjà employé sur les puces gravées pour le compte d'Apple.

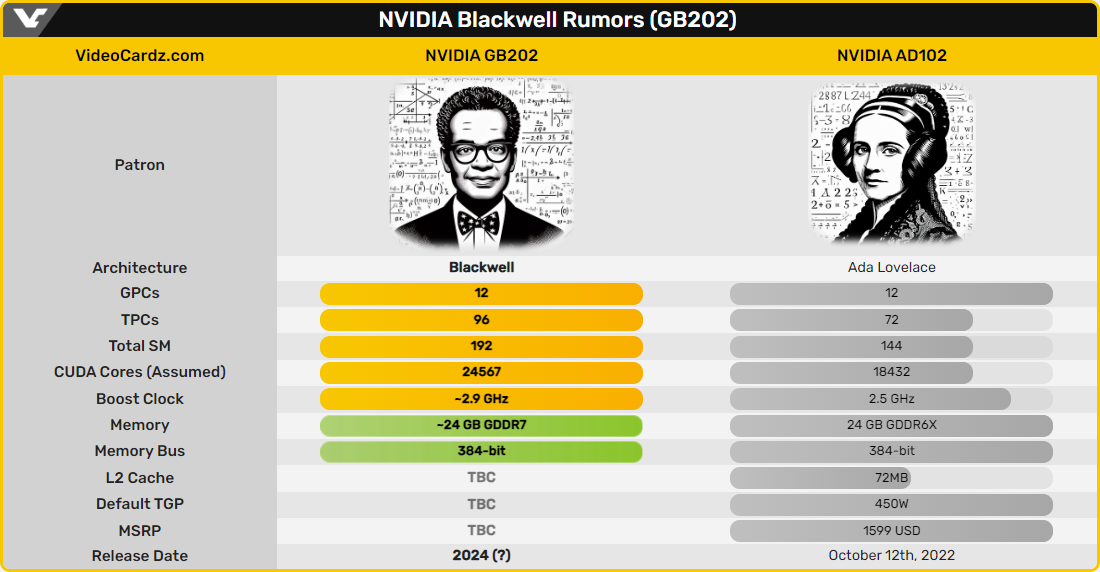

Une information confirmée par VideoCardz qui en profite pour ajouter une précision utile directement issue des indiscrétions d'un des spécialistes du monde NVIDIA, Kopite7kimi. Alors que l'on avait évoqué la possibilité d'utiliser un bus mémoire 512-bit sur les RTX série 50, on parle aujourd'hui de 384-bit.

Une bande passante de 1,5 To/s

Parmi les autres spécifications techniques évoquées tout récemment, on retiendra le nom du GPU « principal » de la série 50, le GB202 qui fera donc suite à l'AD102 de la gamme Ada Lovelace.

Aux dernières nouvelles, il serait question d'un total d'une configuration avec 192 multiprocesseurs de flux (à ne pas confondre avec les processeurs de flux d'AMD) pour un total de 24 567 cœurs CUDA à son plein potentiel. NVIDIA profiterait de ce changement de génération pour intégrer de la GDDR7, peut-être à 32 Gbps quand la GDDR6X actuellement employée est en 21 Gbps.

Il résulterait de ce changement une bande passante 50 % supérieure à celle de la GeForce RTX 4090, à 1,5 To/s. Parfois critiqué pour son manque d'ambition dans la prise en charge des spécifications DisplayPort, NVIDIA aurait aussi dans l'idée de proposer le DP2.1 sur ses futurs GeForce RTX série 50, comme peut le faire aujourd'hui AMD avec ses Radeon RX 7000.

Des précisions intéressantes même si elles restent sujettes à caution. Nous aurons de toute façon largement le temps de revenir sur le cas de cette série 50 alors que NVIDIA va d'abord mettre l'accent sur les modèles SUPER de la génération actuelle.

La carte graphique est le composant informatique qui produit les images affichées par un écran. Avec le processeur (CPU), c'est un élément essentiel à votre ordinateur. C'est pourquoi nous avons testé pour vous les meilleurs modèles de GPU disponibles et retenus la crème de la crème de chez NVIDIA, AMD et Intel. Que vous soyez accro au gaming, graphiste 3D, streamer ou vidéaste, nous avons la carte graphique qu'il vous faut.

Lire la suite

Source : VideoCardz #1, VideoCardz #2