Ils font rire, énervent ou inquiètent. Certains y trouvent une nouvelle forme de créativité, d’autres veulent les interdire, y voyant un vecteur d’instrumentalisation et de manipulation. Mais, au delà des memes et des risques, les deepfakes peuvent-ils vraiment être utiles ?

Depuis l’apparition du mot « deepfake » sur Reddit en 2017, les deepfakes sont irrémédiablement associés à des vidéos dont les visages ont été changés, soit pour amuser (dans une logique de culture meme), soit pour ternir l'image d'une personnalité en lui faisant dire ou faire quelque chose qu'elle n’a jamais fait ou dit, soit pour influencer l’opinion publique dans une logique de fake news. Pour beaucoup de gens, le deepfake est donc synonyme d’une vidéo fun, nuisible ou sulfureuse… donc forcément virale.

Le sujet est pourtant bien plus riche et sérieux qu’il ne le paraît. D’abord, car le terme deepfake tend à se généraliser pour englober tout ce qu’il est possible de reproduire — y compris voix, postures ou mouvements corporels — en tirant parti du deep learning, l’une des disciplines clé de l’intelligence artificielle d’aujourd’hui. Ensuite, et surtout, parce que la technologie peut s’appliquer à de nombreux scénarios d’usage, bien au-delà des vrais-faux-Tom Cruise sur TikTok ou de Scarlett Johansson en improbable star du porno malgré elle.

Quand les deepfakes marquent l’histoire

Il faut d’abord rappeler que les deepfakes ont été utilisés par le passé pour des expérimentations diverses qui ne se réduisent pas au simple divertissement.

En 2018, le projet JFK Unsilenced avait recréé oralement le discours que John Fitzgerald Kennedy aurait donné à Dallas en 1963 s’il n’avait pas été assassiné quelques minutes plus tôt. Sur la base du texte du discours prévu, et de l’analyse de la voix du président dans 831 discours publics, on a appris au logiciel à « parler comme JFK », pour finalement produire un enregistrement audio très réaliste de ce discours qu’il n’a jamais prononcé. Le principe est troublant (un discours « post-mortem ») mais le résultat permet de mieux transmettre l’émotion, la réalité et l’importance historique d’une déclaration politique qui marquait la fin de la guerre froide.

En 2019, une campagne publicitaire de l’ONG humanitaire Malaria Must Die (« En finir avec le paludisme ») mettait en scène un David Beckham parlant successivement neuf langues. En réalité, le footballeur ne parle pas ces langues, mais son visage et sa bouche ont été parfaitement synchronisés au texte via du deepfaking. Plutôt qu’une traduction générique qui aurait pu paraître artificielle, le résultat est plus naturel, plus évocateur et renforce le caractère universel du message pour mieux le faire passer.

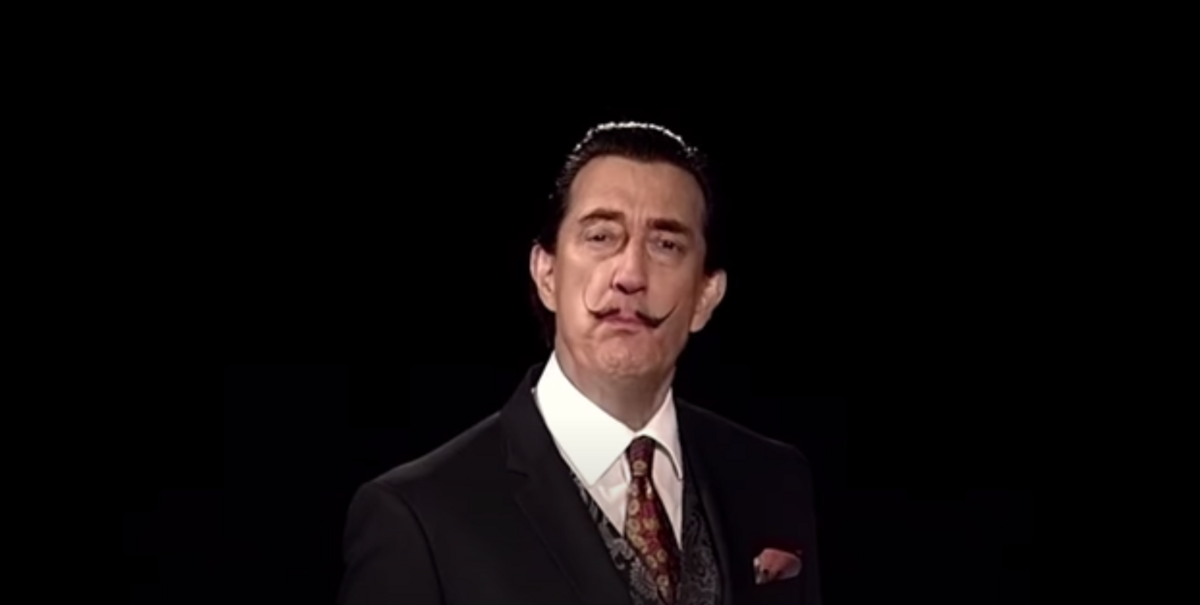

Dans un autre genre, depuis 2019 les visiteurs du Musée Dali de St. Petersburg, en Floride, peuvent voir une version numérique grandeur nature de Salvador Dali leur parler comme s’il était vivant. Sur la base de milliers d’images et de vidéos du peintre décédé en 1989, on a entraîné un algorithme à imiter son visage, ses gestes, sa voix, son accent. On a donc recréé, pour quelques dizaines de minutes, une version virtuelle de Dali, qui n’est pas vraiment lui mais qui parle et se comporte comme lui. Surréaliste, pour le coup.

Plus récemment, début 2021, l’appli Deep Nostalgia a connu un succès fulgurant en permettant, à partir de n’importe quelle photo de visage, de créer une courte vidéo montrant la personne souriant, tournant la tête ou clignant des yeux. Le deepfake pour faire revivre durant quelques secondes une personne disparue, souvent jamais vue en vidéo de son vivant... Le principe a fait couler beaucoup d’encre et suscité moult interrogations éthiques. Mais le succès de l’outil est phénoménal : en cinq semaines, Deep Nostalgia a été utilisé pour générer 72 millions d’animations.

La tentation du deepfake

Tout cela laisse entrevoir une multiplicité d’usages, dont le plus évident (et peut-être le plus attendu) concerne la création artistique. Sans aucun doute, les deepfakes constituent un vaste terrain de jeu pour les artistes. Et c’est sans doute le cinéma qui pourrait le plus bénéficier de la technique.

Faire revivre (ou, au moins, rejouer) des acteurs disparus, mettre un scène un personnage à différents âges de sa vie, ou encore inventer des personnages se métamorphosant en d’autres... Autant de possibilités déjà explorées par Hollywood notamment. Mais les grands studios n’ont pas encore adopté les deepfakes, longs et coûteux à produire. Ils se reposent toujours largement sur des effets spéciaux traditionnels et l’imagerie de synthèse (VFX et CGI) avec des résultats certes spectaculaires, mais qui pourraient néanmoins être encore plus réalistes.

Par exemple, dans Rogue One: A Star Wars Story (2016), la princesse Leia jeune apparaît brièvement telle qu’elle était 40 ans plus tôt dans le premier film de la saga. La scène n’ayant jamais été tournée par l’actrice originelle (Carrie Fisher), elle résulte d’effets spéciaux classiques : le visage est un maquillage numérique (CGI), tandis que le seul mot que prononce Leia a été repiqué sur de vieux enregistrements sonores de 1977, le tout avec un résultat pas toujours jugé convaincant par les fans. Certains estiment qu’on peut faire mieux... avec les deepfakes. En 2020, Shamook, producteur amateur de deepfakes à gros succès sur Youtube, publie une version « améliorée » de la fameuse scène. Le visage de la princesse est « un deepfake ayant nécessité seulement 24 heures de travail sur un PC à 800$ et 500 images de Carrie Fisher », explique l’auteur. Et le résultat paraît incroyablement meilleur que la version initiale de Disney.

Autre exemple, dans The Irishman (2019), Robert de Niro et Al Pacino ont été artificiellement rajeunis par VFX pour de nombreuses scènes. Le résultat est convaincant pour les visages, un peu moins pour les scènes où ils se déplacent — les acteurs ont du mal à se mouvoir comme de jeunes hommes. Mais les recherches vont bon train sur l’application des deepfakes au corps tout entier (ou « full body deepfakes »).

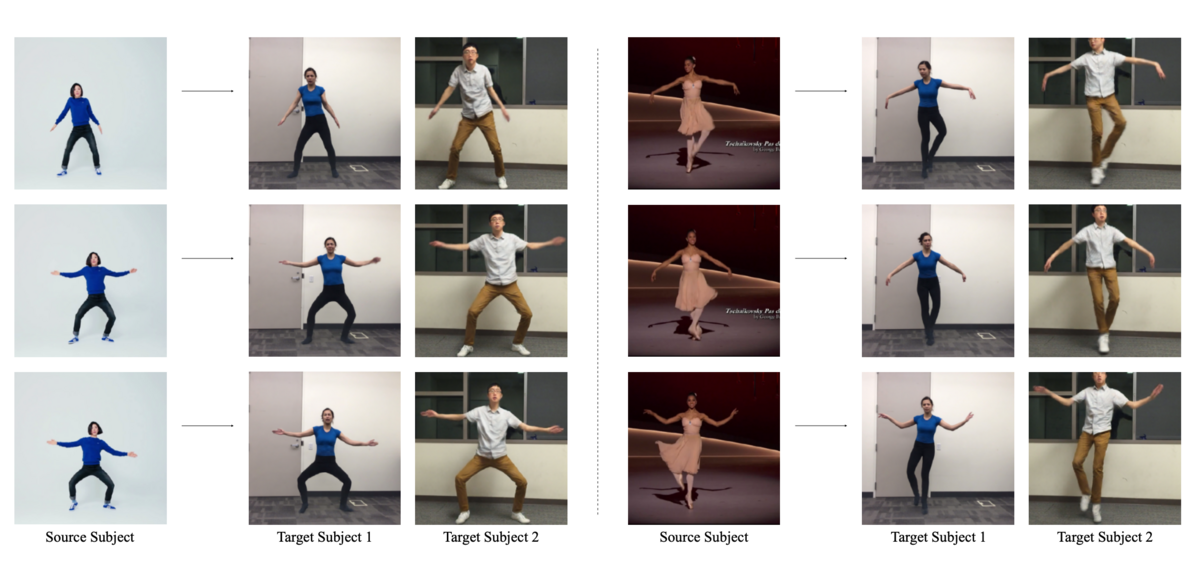

En 2018, l’université de Berkeley, dans un article de recherche titré « Tout le monde danse maintenant », présentait une méthode pour appliquer la vidéo de quelqu’un en train de danser au corps d’une autre personne. Via apprentissage profond et « seulement quelques minutes de la vidéo cible où la personne adopte des postures standard », le logiciel transforme n’importe qui en danseur professionnel. Peu après, l’entreprise japonaise Datagrid avait présenté une solution à base de deepfake, à destination de l’industrie de la mode ou de la publicité, pour « générer des images du corps entier de personnes qui n’existent pas ». C’est l’ère des « mannequins virtuels », qui ont « appris » les poses et les mouvements des vrais top models « au point de pouvoir les remplacer le temps d’une séance photo », comme le note Vogue Business. Un avatar qui marche comme Robert de Niro à 20 ans, défile comme Charlize Theron ou danse comme Beyoncé ? Simple comme un deepfake — ou sans doute à portée de calcul dans les années qui viennent.

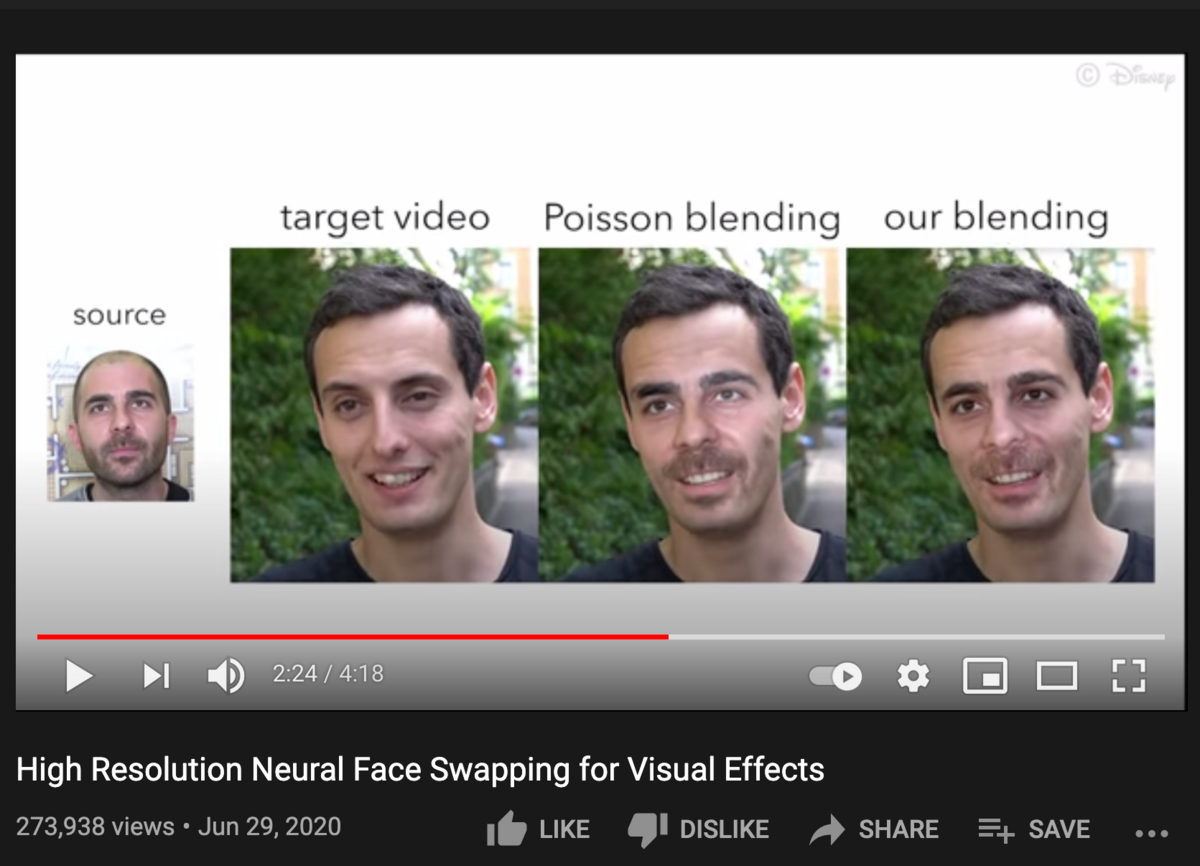

Pour l’heure, les deepfakes appliqués aux blockbusters d’Hollywood sont l’apanage d’amateurs éclairés. Mais il ne fait aucun doute que l’industrie du cinéma s’intéresse de près à tout cela. Les laboratoires de recherche Disney (Disney Research labs), par exemple, publient régulièrement sur le sujet. En juin 2020, ils décrivaient une technique innovante à base de deep learning pour « automatiser l’échange de visages sur des images ou des vidéos en haute résolution ». Une véritable prouesse à ce niveau de qualité et de « réalisme photographique », selon les auteurs de l’étude. Destiné aux cas « où un personnage doit apparaître à un âge plus jeune, où un acteur n’est pas disponible ou même décédé de longue date, ou encore à des cascades assurées par des acteurs mais nécessitant des images de leur visage », le procédé se caractérise par « une fraction du temps et du coût que nécessitent des méthodes traditionnelles ». Comme le pressent Shamook, l’inclusion du deepfake dans la gamme des effets spéciaux utilisés par Hollywood paraît « inévitable » — la seule question est « quand et comment ».

L’intérêt de l’industrie du cinéma pour le deepfake ne s’arrêtera d’ailleurs sans doute pas à l’image proprement dite. Comme le montre l’exemple de la publicité avec David Beckham, on comprend tout le potentiel de la technique pour rendre films et séries mieux adaptés aux versions locales dans chaque pays, donc plus naturels et plus plaisants à regarder. On peut d’ailleurs imaginer que, outre la synchronisation labiale, le deepfake s’applique également au son, avec des acteurs qui s’exprimeraient — sans doublage — dans une langue étrangère mais avec leur propre voix, apprise et synthétisée par un logiciel à partir de la leur.

Des usages plus inattendus

D’autres usages potentiels des deepfakes sont très éloignés de l’usage dominant d’aujourd’hui.

Dans le domaine médical, la technologie pourrait servir à améliorer le quotidien de patients souffrant de troubles du langage. La maladie de Charcot (sclérose latérale amyotrophique, ALS), par exemple, provoque une paralysie progressive de l’ensemble du corps, avec pour effet indirect l’incapacité de parler. Au bout d’un moment, les malades ne peuvent plus communiquer sans des appareils à base de voix synthétiques peu naturelles et induisant un sentiment de perte de leur identité et de leur personnalité. L’utilisation du deep learning peut les aider : à partir d’enregistrements préalables (réalisés avant la perte totale de la parole), on crée une sorte de deepfake de la propre voix du patient. Plusieurs entreprises, comme Acapela ou Vocalid, proposent déjà de générer des voix synthétiques personnalisées. « La révolution de l’apprentissage automatique tient ses promesses en entrant dans le domaine de la voix numérique », décrit Acapela, expliquant que des réseaux neuronaux profonds (« Deep Neural Networks ») peuvent servir à « créer une version numérique de la voix d’une personne à partir de quelques minutes d’enregistrement ». Par le truchement d’une machine, un patient ayant perdu la parole pourrait continuer à s’exprimer avec sa propre voix.

Un autre exemple, dans le domaine de l’éducation cette fois, concerne l’utilisation des deepfakes pour favoriser l’apprentissage. Udacity, l’un des poids lourds de la formation en ligne, avait montré en 2019 des travaux de recherche portant sur la génération de vidéos à partir d’enregistrements audio. Entièrement basé sur le deep learning, l’outil utilise une vidéo existante pour produire de nouvelles vidéos de conférences à partir de simples narrations audio de l’instructeur. Le tout était jugé « très convaincant », avec « le corps et les cheveux paraissant très réalistes et naturels, l’ouverture et la fermeture des lèvres en parfaite synchronisation avec la narration », même si quelques aspects restaient à améliorer, notamment le mouvement des yeux. Selon les chercheurs, le système paraît prometteur (« plus rapide et moins coûteux que de filmer »), et pourrait même être étendu pour produire des vidéos à partir de simples textes. Tout conférencier ou professeur pourrait donc un jour n’avoir qu’à taper un texte pour apparaître en vidéo dans un cours magistral vivant et pédagogique.

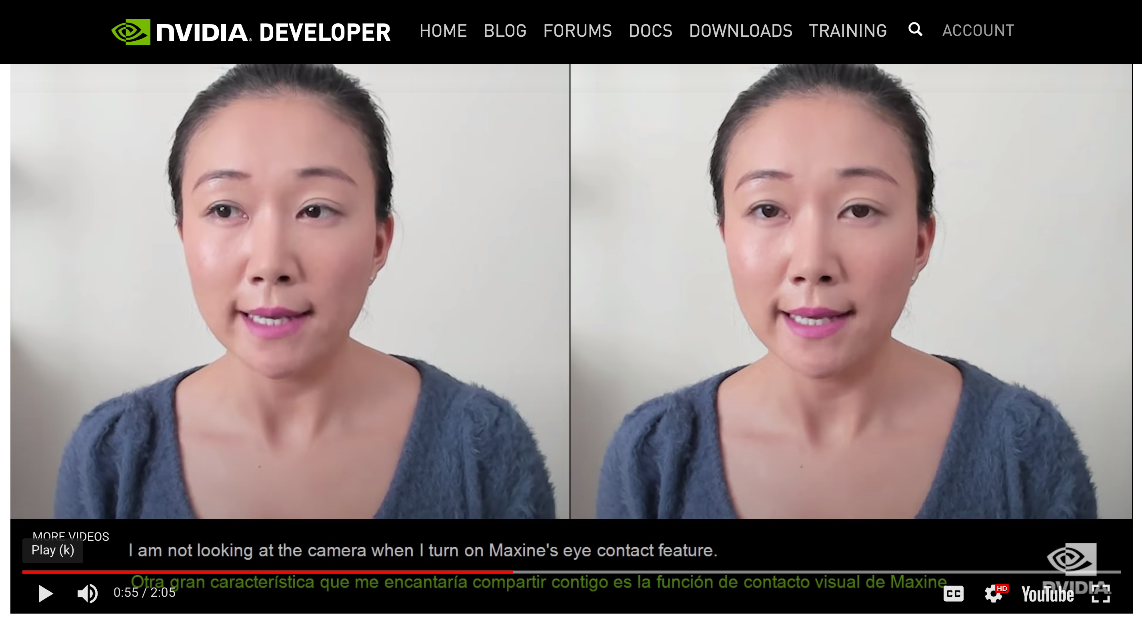

D’autres usages plus techniques laissent entrevoir des possibilités nouvelles en matière de communication. Fin 2020, Nvidia avait présenté Maxine, une plate-forme basée sur le deep learning pour optimiser la visioconférence. Plutôt que de streamer un flux vidéo complet des visages qui se parlent, l’idée est de n’échanger que quelques données clés relatives aux expressions faciales, avant de « reconstruire » les visages complets. En quelque sorte, votre interlocuteur voit un « deepfake en temps réel » de vous, mais il est très réaliste et peut même apporter quelques améliorations, comme un réalignement (pour faire en sorte que le visage regarde toujours en direction de la caméra). Le principe ne plaira pas à tout le monde, mais pourrait séduire les adeptes de la sobriété numérique, puisque selon Nvidia il n’utilise « qu’un dixième de la bande passante » nécessaire pour une visioconférence classique.

Tout cela tend à montrer que les deepfakes qui font aujourd’hui le buzz sur les réseaux sociaux ne sont qu’une petite partie émergée d’un vaste iceberg. Ces vidéos amusantes ou dérangeante reposent sur des technologies puissantes dont les usages sont loin d’avoir été intégralement explorés. Certains de ces usages seront nuisibles et néfastes, d’autres utiles et bénéfiques. En somme, il en va des deepfakes comme de toute autre technologie : tout dépend de la façon dont on s’en sert.