La prochaine génération de cartes graphiques va logiquement atteindre des sommets de consommation électrique. Jusqu'à quel point ?

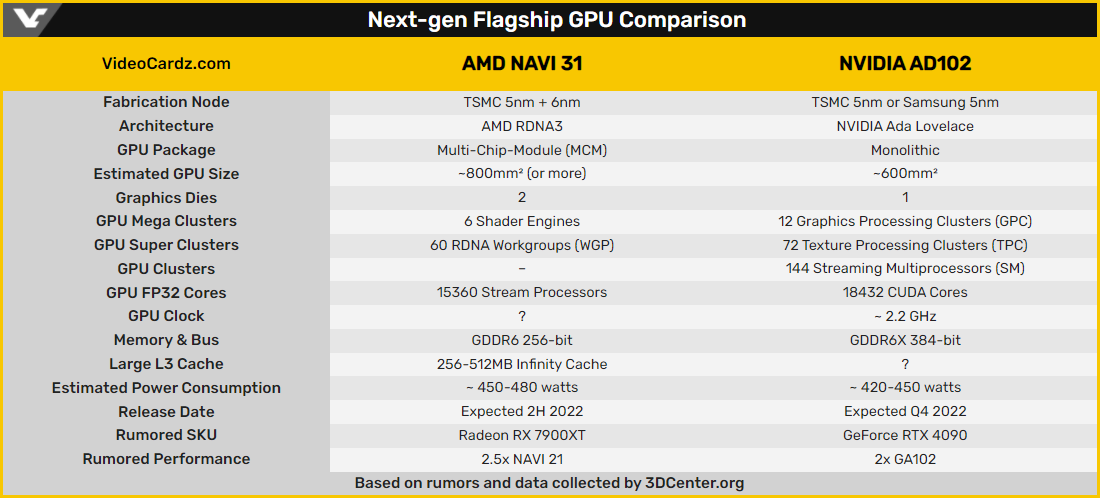

Alors que l'on approche doucement du premier anniversaire des GeForce RTX série 3000, les rumeurs entourant les nouvelles générations NVIDIA et AMD se font plus nombreuses. Nos confrères de Videocardz se sont chargés de les compiler afin d'observer leurs points de convergence.

Une RTX 4090 entre 420 et 450 Watts

Sur Twitter, deux « fuiteurs » bien connus ont ainsi insisté sur la consommation de celle que l'on nomme déjà RTX 4090. Kopite7kimi et Greymoon55 s'accordent effectivement sur un GPU capable d'engloutir entre 420 et 450 Watts. Greymoon55 souligne toutefois que la puce AD102 qui va l'équiper n'est pas encore taped out.

En d'autres termes, le design de la génération connue sous le nom de code Ada Lovelace n'est pas encore finalisé chez NVIDIA. De plus, cette consommation n'est qu'une estimation établie à l'aide des informations déjà recueillies liées à la taille du die ou au nombre de cœurs Cuda.

Entre 450 et 480 Watts pour Navi 31

NVIDIA n'est évidemment pas seul et, avec son Navi 31, AMD semble devoir être dans les mêmes eaux. Nos confrères de Videocardz évoquent un processeur d'environ 800 mm² et parlent d'une consommation comprise entre 450 et 480 Watts.

Cité par nos confrères, un certain wjm47196 semble savoir que Navi 31 serait, lui, déjà taped out pour une sortie envisagée au cours du troisième trimestre 2022. Avec cette nouvelle génération, AMD sera le premier à adopter une architecture MCM – ou Multi Chip Module – à la différence de NVIDIA qui restera sur une architecture plus classique.

Si les diverses sources ici mentionnées par Videocardz sont d'habitude plutôt fiables, gardons toutefois à l'esprit qu'il ne s'agit encore que de rumeurs : chez AMD comme chez NVIDIA, les prochaines générations de GPU ne sont pas encore pour tout de suite.

Source : Videocardz