Les équipes de sécurité de JFrog ont découvert qu’une centaine de modèles de machine learning (ML) hébergés sur Hugging Face étaient à l’origine de backdoors persistantes sur les appareils les ayant téléchargés.

C’est une découverte qui marque un virage dans la recherche sur l’intelligence artificielle. Les datas scientists de JFrog ont cette semaine indiqué avoir repéré un modèle d’AI ML malveillant sur la plateforme collaborative Hugging Face, capable d’exécuter du code arbitraire sur les machines chargeant les fichiers corrompus. En approfondissant leur enquête, une centaine d’autres modèles similaires ont été identifiés dans les référentiels Hugging Face.

Du code arbitraire silencieux à l’espionnage industriel, il n’y a qu’un pas

Si le rapport dévoilé par JFrog ne remet pas en question la politique de sécurité mise en place par Hugging Face, il pointe néanmoins des failles ayant permis à des AI ML dangereux de passer sous le radar, et invite les acteurs de l’IA, chercheurs comme prestataires de services, à faire preuve d’encore plus de vigilance. En cause : l’identification d’un modèle malveillant, suivi d’une centaine d’autres, capable d’exécuter du code arbitraire après que la machine infectée a chargé un fichier pickle (binaire utilisé pour stocker et partager des objets Python). Un procédé permettant aux attaquants de créer des backdoors persistantes sur les appareils ciblés, et donc d’en prendre le contrôle à distance.

Ces intrusions sont d’autant plus insidieuses qu’elles ne permettent pas aux victimes de savoir qu’elles ont été piratées. Les conséquences d’un tel modus operandi pourraient potentiellement donner accès à des systèmes internes critiques et ouvrir la voie à des violations de données à grande échelle, voire mener à de l’espionnage industriel, impactant les utilisateurs individuels comme les entreprises à travers le monde.

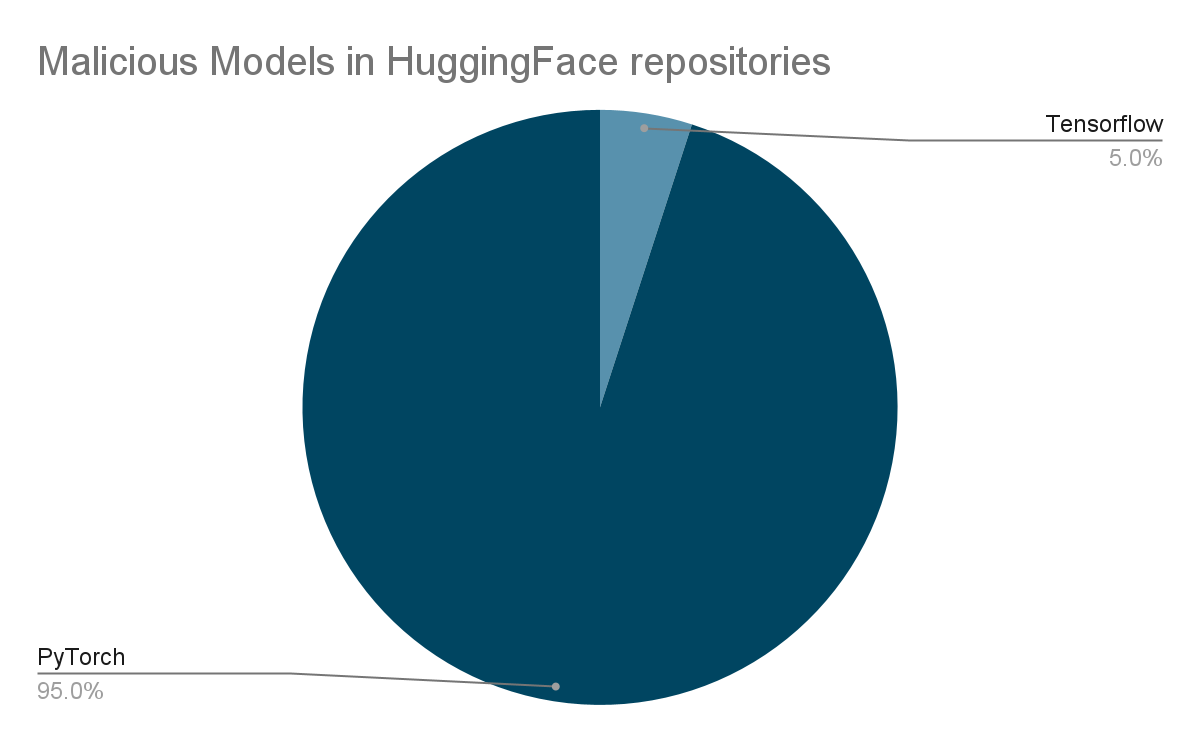

Des centaines de modèles PyTorch et TensorFlow concernés

Poids lourds de la recherche en intelligence artificielle open source, la plateforme collaborative Hugging Face avait pourtant mis en place une série de mesures de sécurité pour empêcher la diffusion de modèles d’IA dangereux, parmi lesquelles l’analyse des fichiers pickle, justement. Un type de scan capable de détecter du code malveillant, des désérialisations dangereuses et des informations sensibles. Or, lorsque Hugging Face identifie des fichiers pickle suspects, il n’en bloque pas ni n’en restreint le téléchargement, laissant ses utilisateurs les manipuler à leurs propres risques.

Le deuxième modèle le plus répandu sur la plateforme de recherche, TensorFlow Keras, fait lui aussi partie des modèles susceptibles d’exécuter du code malveillant à l’insu des celles et ceux qui les téléchargent. Pour compléter les outils d’examen mis au point par Hugging Face, les équipes de JFrog ont développé leur propre environnement d’analyse et statué sur la prévalence des menaces dans les modèles PyTorch et TensorFlow. En plus de représenter un risque d’exécution de code arbitraire plus élevé, le danger qu’ils représentent est accru par leur grande popularité.

Les auteurs de ces modèles n’ont pas été clairement identifiés, mais des indices font penser que certains d’entre eux pourraient être des chercheurs en intelligence artificielle. Un constat qui laisse un goût amer pour JFrog qui fustige la publication d’exploits fonctionnels et de codes malveillants sur une plateforme grand public, alors même que le principe fondamental de la recherche en matière de sécurité est de s’en abstenir.

Face à la croissance exponentielle des cybermenaces, il est plus important que jamais de protéger ses terminaux avec une suite de sécurité antivirus digne de ce nom. Découvrez notre sélection des meilleures protections multiplateforme en mars 2024.

Lire la suite

Source : JFrog