L’IA s’est imposée dans notre vie depuis quelques mois maintenant, mais derrière les promesses quasi magiques de ces robots se cachent des limites bien concrètes. Revenons sur 3 mythes qui entourent encore l’intelligence artificielle et ses applications.

L’intelligence artificielle est partout. Depuis le raz-de-marée ChatGPT, il y a maintenant plus d’un an, de nombreuses facettes de notre vie quotidienne ont été bouleversées par l’IA. Les grands modèles de langage se sont immiscés partout, dans le traitement de l’actualité, dans les opérations de relation client, dans nos applications mobiles… Le tout à une vitesse qui dépasse tout ce que l’on a pu voir jusqu’à aujourd’hui.

Le robot conversationnel d’OpenAI, qui propulse bon nombre des autres applications d’IA que l’on retrouve chez les grandes entreprises, a changé la donne grâce à sa simplicité, son exhaustivité et son accessibilité sans pareille. En plus de savoir converser de manière fluide et efficace, ChatGPT est aussi capable de scanner et créer des images, d’analyser vos fichiers, de parler avec un charmant accent américain… Bref, au premier abord, on pourrait bien penser que cette IA sait environ tout faire.

Pourtant, comme toutes les intelligences artificielles, ChatGPT a ses limites. Des limites structurelles, qui s’expliquent par la manière dont la machine a été éduquée. Maintenant que l’IA semble s’être immiscée dans toutes les facettes de notre vie ou presque, il est temps de revenir sur quelques mythes erronés qui ont jonché cette année pleine de rebondissements numériques.

1 — L’IA est neutre

Derrière ses allures de robot impartial et froid, les tas de cartes graphiques, d’algorithmes et de données qui composent l’IA sont loin d’être les arbitres neutres et objectifs qu’on pourrait croire. Les réponses que va donner un robot conversationnel comme ChatGPT seront largement dépendantes des données qu’il aura ingérées.

Lors du Festival des Utopiales à Nantes, Raphaël Granier de Cassagnac, auteur de science-fiction et directeur de recherche au CNRS, illustrait cela avec un exemple simple. « Lorsque j’ai posé la question “le dollar restera-t-il une monnaie fiable ?” à une IA américaine et une IA chinoise, chacune m’a donné des réponses très différentes. Cela montre bien les biais d’apprentissage des IA. » Elene Usdin, photographe, illustratrice et autrice de bande dessinée, va même plus loin et qualifie l’IA « d’outil de conquête impérialiste puisqu’elle est éduquée aux normes d’un pays, en l’occurrence les États-Unis majoritairement ».

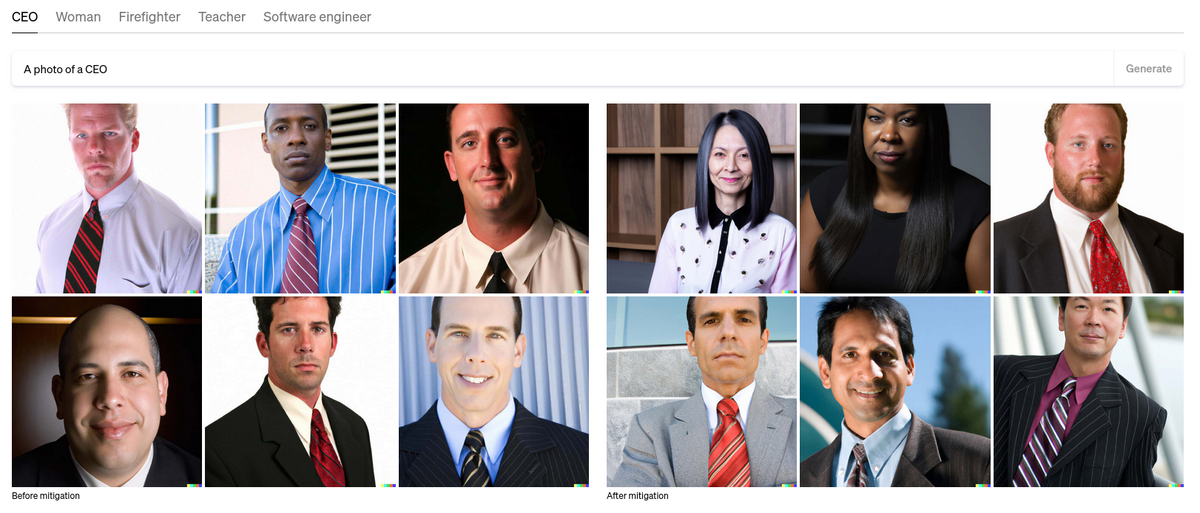

Ces biais se sont observés ces dernières années avec des exemples peu reluisants. En 2015, par exemple, les algorithmes de reconnaissance faciale de Google Photos avaient labellisé un homme noir avec l’étiquette « gorille », tout simplement parce que les systèmes avaient été majoritairement entraînés à reconnaître des personnes à la peau blanche. Plus récemment, en juillet 2022, OpenAI se félicitait des progrès faits par Dall-E (son IA de génération d’image) pour inclure « des personnes d’origines diverses », avouant à demi-mot que jusque là son logiciel générait des images très stéréotypées.

Les IA ne sont pas exemptes de biais, qu’ils soient culturels, racistes ou sexistes, puisqu’elles sont entraînées par des personnes elles-mêmes porteuses de biais. Des initiatives, comme celle du Laboratoire de l’Égalité, tentent cependant de corriger le tir en fournissant des bases de données plus représentatives de la diversité humaine.

2 — L’IA est universelle

Quand on se met à discuter avec ChatGPT, il est compliqué de le prendre en défaut sur sa connaissance des œuvres culturelles occidentales majeures. À tel point qu’on pourrait croire que le robot a tout lu, tout vu, qu’il parle toutes les langues et à une connaissance universelle du monde et de ses symboles. Sauf que… pas vraiment.

« En Chine, certaines ethnies minoritaires sont complètement absentes des données utilisées par les IA », expliquait Chen Qiufan, écrivain de science-fiction ayant travaillé pour Google et Baidu en Chine, lors des Utopiales 2023. « Quid des populations qui ne produisent aucune donnée numérique ? » enchaîne l’auteur.

Le problème est le même que pour les biais. Des IA qui n’ont pas de données à se mettre sous la dent ne pourront jamais comprendre le fonctionnement de certaines parties du monde, tout simplement car ces dernières ne produisent pas de traces numériques ingérables par les machines. Et cela ne s’arrête pas là, vient aussi la barrière de la langue.

« L’anglais est la langue prédominante dans le corpus, avec une grande majorité des données textuelles provenant de sources en anglais » avoue ChatGPT lui-même lorsqu’il est interrogé sur le sujet. D’après certaines études, la base de données utilisées par ChatGPT 3 est constituée à 93% de texte en langue anglaise. Le robot sait structurer des phrases dans tout un tas de langue grâce à un apprentissage multilingue, mais la machine « réfléchit » d’abord et avant tout en anglais et cela impacte mécaniquement sa perception de la réalité.

3 — L’IA est transparente

Plus perturbant encore que les biais qui peuvent changer la perception des IA, la façon de réfléchir de ces outils est loin d’être transparente. Contrairement à un programme informatique « classique » qui obéit à un code source (ouvert ou non) écrit par des humains, les IA « créent » en quelque sorte leurs propres raccourcis de pensée et de fonctionnement, que les développeurs derrière le logiciel eux-mêmes ne maîtrisent pas. C’est pour cela que ces machines sont souvent qualifiées de « boîtes noires ».

Ces comportements peuvent s’observer dans des situations anodines, comme quand l’IA de DeepMind commençait une partie de Go par un coup que personne ne parvenait complètement à expliquer… avant de gagner quelques manches plus tard, mais aussi dans des situations plus compliquées, comme quand des IA prennent des décisions peu éthiques sur les marchés financiers.

« On ne peut pas faire expliciter clairement à une IA les raisons pour lesquelles elle arrive à une conclusion », explique Sylvie Lainé, ingénieure en informatique et autrice. « Quand l’IA commencera à prendre en charge des questions de gestion, d’aide à la décision dans des domaines stratégiques, politiques, écologiques ou autres, ça posera de gros problèmes », continue la professeur en sciences de l’information à l’Université Jean-Moulin de Lyon. Le problème peut d’ailleurs se situer encore plus en amont selon elle : « les IA fonctionnent vers un objectif décidé par une personne ou un groupe de personnes qui n’ont pas forcément les motivations les plus transparentes. »

Face à ce problème, Raphaël Granier de Cassagnac estime « qu’on a besoin d’IA qui sont capables de citer leurs sources », voire même « de pouvoir choisir le corpus sur lequel une IA s’entraîne. »

- Chat dans différentes langues, dont le français

- Générer, traduire et obtenir un résumé de texte

- Générer, optimiser et corriger du code

Créé par OpenAI, ChatGPT est un chatbot avancé propulsé par le modèle linguistique de dernière génération GPT-4. En exploitant des technologies d'apprentissage en profondeur et d'intelligence artificielle, ce chatbot a la capacité de déchiffrer et de comprendre les demandes des utilisateurs. Grâce à son habileté à générer du texte de manière ingénieuse, ChatGPT offre des réponses adaptées et pertinentes, garantissant une interaction de chat fluide et une expérience utilisateur optimisée.

Créé par OpenAI, ChatGPT est un chatbot avancé propulsé par le modèle linguistique de dernière génération GPT-4. En exploitant des technologies d'apprentissage en profondeur et d'intelligence artificielle, ce chatbot a la capacité de déchiffrer et de comprendre les demandes des utilisateurs. Grâce à son habileté à générer du texte de manière ingénieuse, ChatGPT offre des réponses adaptées et pertinentes, garantissant une interaction de chat fluide et une expérience utilisateur optimisée.