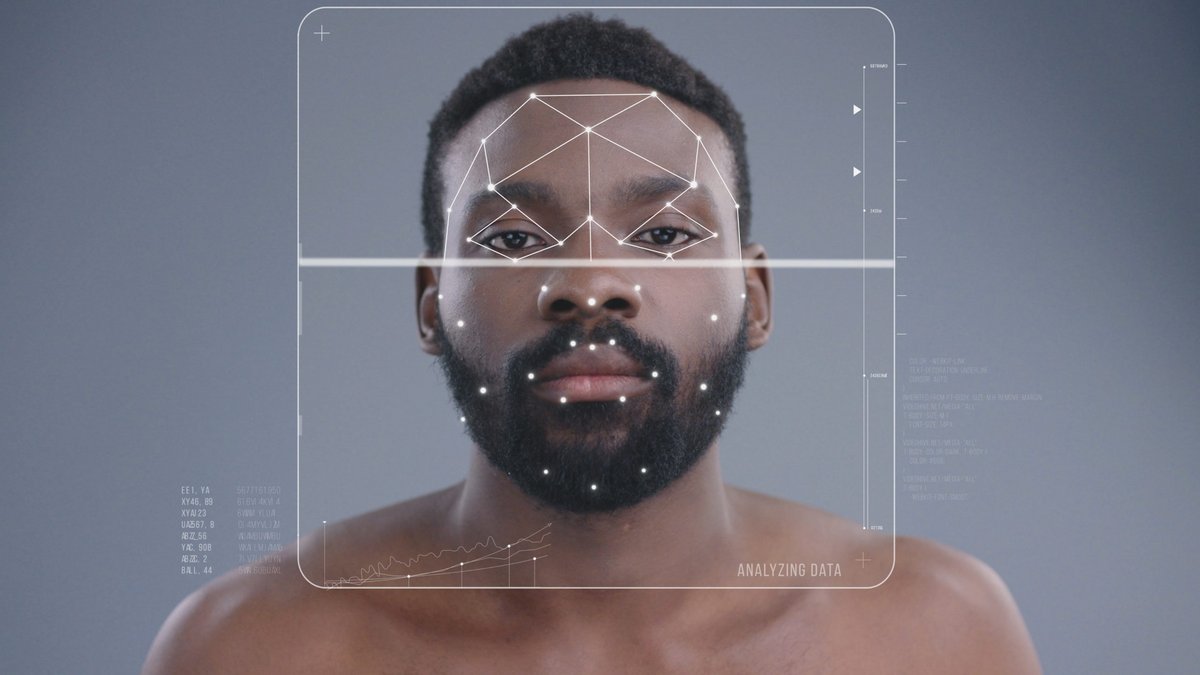

Toutes les arrestations par erreur dues à la reconnaissance faciale par la police américaine concernent des personnes noires.

Si la perspective de l'utilisation de la reconnaissance faciale par la police peut déjà paraître dystopique en elle-même, cette dernière est de plus tout sauf infaillible. Et les statistiques ne laissent pas vraiment de place à l'interprétation : en matière d'erreurs de police dues à la reconnaissance faciale, les victimes sont toujours noires.

La reconnaissance faciale utilisée quotidiennement dans plusieurs villes du pays

En février dernier, Porcha Woodruff, une femme noire vivant à Detroit, est en train de préparer ses enfants pour les emmener à l'école quand six policiers se présentent chez elle, l'accusant d'un vol de voiture. Finalement relâchée, elle a décidé de porter plainte, devenant la sixième personne (au moins) à avoir été accusée à tort, uniquement sur la base des conclusions de la technologie de reconnaissance faciale utilisée par la police pour procéder à son arrestation. Comme elle, les cinq autres personnes ayant été victimes de ce type d'erreurs étaient toutes noires.

Contacté, le chef de la police de Detroit a reconnu que le problème était très grave, et que son département conduirait une enquête interne. Le simple fait que la technologie soit utilisée pose question, pas seulement sur un plan philosophique, mais du seul point de vue de l'efficacité. Car en 2020, ce même chef de police avait reconnu que la reconnaissance faciale, quand utilisée seule, se trompait 96 % du temps. Ce qui n'a pas empêché la police de Detroit d'utiliser la technologie à 125 reprises en 2022. Mais dans le domaine, c'est celle de Baltimore qui fait la course en tête, avec pas moins de 800 recherches utilisant la reconnaissance faciale cette même année.

Pour les activistes et les experts, c'est tout sauf une surprise

Mais pour des associations de défense des libertés publiques, tout comme pour des chercheurs en IA, ce type de dérive est tout sauf une surprise, et ils alertent sur la question depuis des années déjà. Pour eux, si la technologie n'est pas raciste en elle-même, elle est en revanche développée par des ingénieurs majoritairement blancs, et donc construite avec les mêmes biais que ces derniers. Cela se manifeste notamment par la quasi-absence de personnes noires dans les bases de données utilisées pour entraîner les intelligences artificielles, augmentant significativement le risque d'erreur quand elles sont l'objet de la recherche utilisant ces technologies.

Mais pour ces chercheurs, la perception de ces technologies comme utiles par les policiers, qui s'ajoute à leurs propres biais racistes, amplifie encore d'autant un système profondément injuste qui rend toute contestation par les victimes de ces erreurs presque impossible.

Rappelons que la reconnaissance faciale sera utilisée au cours des Jeux olympiques de Paris et au moins jusqu'en 2025 en France.